Abstract

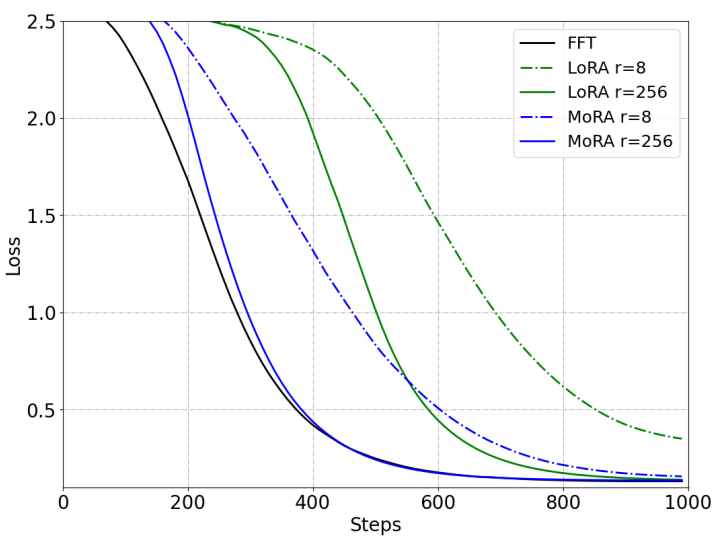

Non-parameter 연산자를 통해 LoRA와 동일한 피라미터 수를 유지하면서도 high-rank update를 달성하는 MoRA 제안

[Github]

[arXiv](2024/05/20 version v1)

Analysis the Influence of Low-rank Updating

LoRA (Low-Rank Adaptation)는 기존 지식은 잘 활용하지만 새로운 지식을 기억해야 할 때는 FFT (Full-FineTuning)에 비해 성능이 떨어진다.

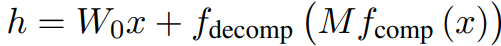

Method

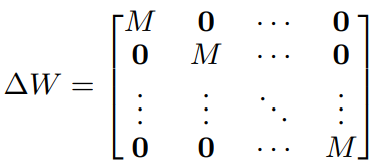

핵심은 가능한 적은 피라미터를 유지하면서도 ∆W의 rank를 높이는 것이다.

정사각 행렬을 사용하면 동일한 피라미터에서 가장 높은 rank를 가질 수 있다.

Non-parameter 연산자를 통해 입출력 차원을 조절한다.

구체적으로 x를 n개로 분할하고 크기가 r̂ × r̂인 행렬 M을 각각 적용한다. 반대 연산은 각 벡터를 연결하면 된다.

그러면 ∆W는 다음과 같다.

Experiment

'논문 리뷰 > Language Model' 카테고리의 다른 글

| ConvLLaVA: Hierarchical Backbones as Visual Encoder for Large Multimodal Models (0) | 2024.05.28 |

|---|---|

| SimPO: Simple Preference Optimization with a Reference-Free Reward (0) | 2024.05.27 |

| RLHF Workflow: From Reward Modeling to Online RLHF (1) | 2024.05.27 |

| Reducing Transformer Key-Value Cache Size with Cross-Layer Attention (0) | 2024.05.24 |

| LoRA Learns Less and Forgets Less (0) | 2024.05.24 |

| Chameleon: Mixed-Modal Early-Fusion Foundation Models (1) | 2024.05.23 |