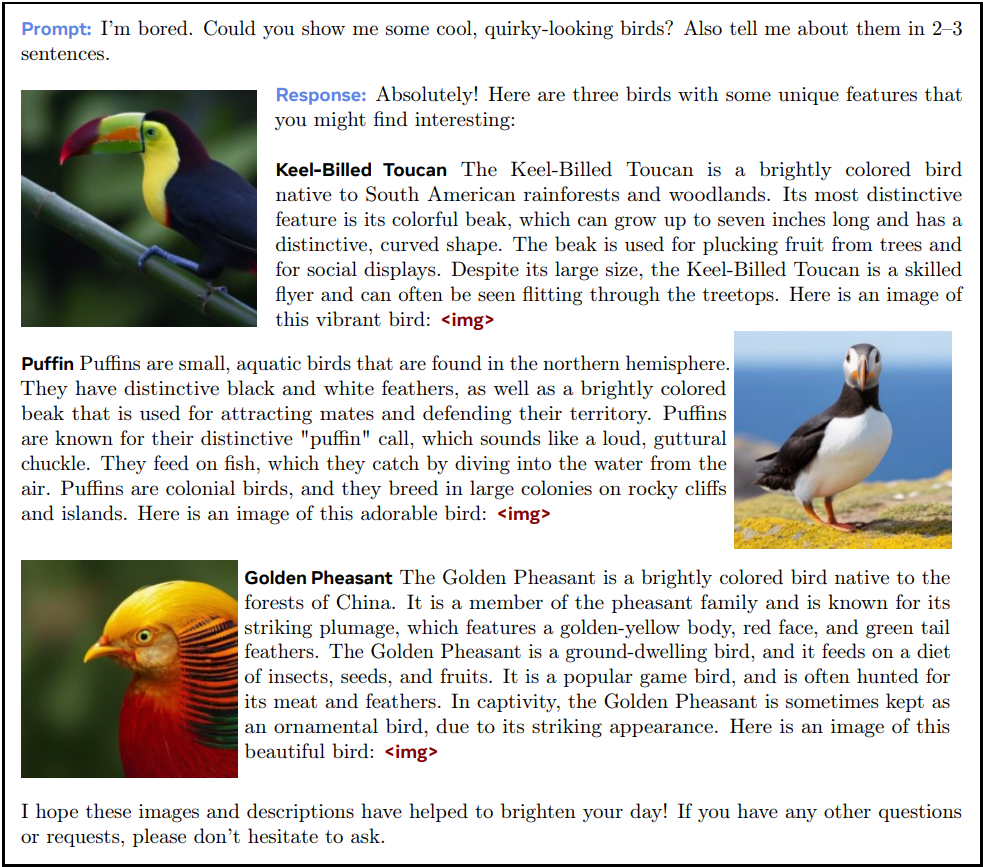

Abstract

사전 훈련된 각 modal-encoder와 LLM을 사용하는 대신 end-to-end 방식으로 처음부터 훈련된 mixed-modal model인 Chameleon 소개

[arXiv](2024/05/16 version v1)

Chameleon은 Meta에서 이미 5개월 전에 훈련을 완료했으며 지금은 훨씬 더 발전했다고 한다.

Pre-Training

Tokenization

Image tokenizer

Make-A-Scene의 image tokenizer를 기반으로 이미지 패치를 8192개의 codebook vector 중 하나로 인코딩.

Tokenizer

8192개의 이미지 코드를 포함한 65536 vocabulary size의 BPE tokenizer.

Pre-Training Data

사전 훈련은 전체 훈련의 80%를 차지하는 1-stage와 20%를 차지하는 2-stage로 구분된다.

모든 text-image pair의 50%는 이미지가 앞에, 나머지는 텍스트가 앞에 위치한다.

First Stage

Text-only, text-image pair, text/image interleaved data가 포함된 약 5T개의 토큰으로 훈련

Second Stage

1-stage data의 가중치를 낮추고 고품질 데이터셋을 추가하여 훈련

Stability

아키텍처는 기본적으로 LLaMA-2를 따른다. 하지만 훈련 중후반부에서 발산이 일어남을 관찰했다.

연구진은 이것이 softmax의 translation invariant 특성 (i.e., softmax(z) = softmax(z + c)) 때문에 발생한다고 생각했다. Chameleon은 모든 modal이 가중치를 공유하기 때문에 각 modal이 norm을 점점 높여가며 경쟁하려 한다는 것이다.

그림 a를 보면 output norm이 지속적으로 증가하는 것을 볼 수 있다.

해결책:

- Q, K에 정규화를 적용

- Attention 및 FFN 이후 dropout 적용

- Chameleon-34B는 dropout 대신 정규화의 순서를 바꿔 norm을 억제하는 방법을 사용했다. (dropout가 호환이 안된다고 함)

또한 최종 softmax로 생성되는 logit의 크기를 줄이는 Z-loss 사용.

Inference

Text-image interleaved inference의 문제점

- 텍스트와 이미지의 디코딩 방식이 다르므로 각 단계에서 토큰을 검사해야 함

- 텍스트는 길이가 가변적이지만 이미지는 고정된 길이의 토큰 시퀀스를 생성한다. 따라서 이미지 생성 도중인 경우 텍스트의 생성을 억제해야 한다.

등등의 과제를 해결하기 위해 독립적인 추론 파이프라인을 구축했다.

Safety, Alignment 생략

Experiments

인간 평가

Image-text task

Text-only

'논문 리뷰 > Language Model' 카테고리의 다른 글

| MoRA: High-Rank Updating for Parameter-Efficient Fine-Tuning (0) | 2024.05.24 |

|---|---|

| Reducing Transformer Key-Value Cache Size with Cross-Layer Attention (0) | 2024.05.24 |

| LoRA Learns Less and Forgets Less (0) | 2024.05.24 |

| Fishing for Magikarp: Automatically Detecting Under-trained Tokens in Large Language Models (0) | 2024.05.21 |

| xLSTM: Extended Long Short-Term Memory (0) | 2024.05.20 |

| DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model (0) | 2024.05.19 |