Abstract

LLM에 명령어 계층을 도입하여 악의적 prompt를 선택적으로 무시할 수 있도록 한다.

[arXiv](2024/04/19 version v1)

The Instruction Hierarchy

LLM에 명령어 계층을 만들어 명령어 충돌 시 상위의 명령을 따르도록 할 것을 제안.

Training Data Generation for Different Attacks

- 명령을 조각으로 분해하고 분해된 각 명령을 계층 구조의 각 level에 배치하고 모델을 교육한다. (예: '스페인어로 20줄 시 쓰기'라는 명령의 경우 시 쓰기, 스페인어 사용, 20줄 작성으로 분해)

- 잘못 정렬된 명령(상위 계층의 명령에 반함)의 경우 명령을 본 적이 없는 것처럼 답변을 생성하도록 한다.

훈련 데이터로는 LLM을 이용해 합성 데이터를 생성한다.

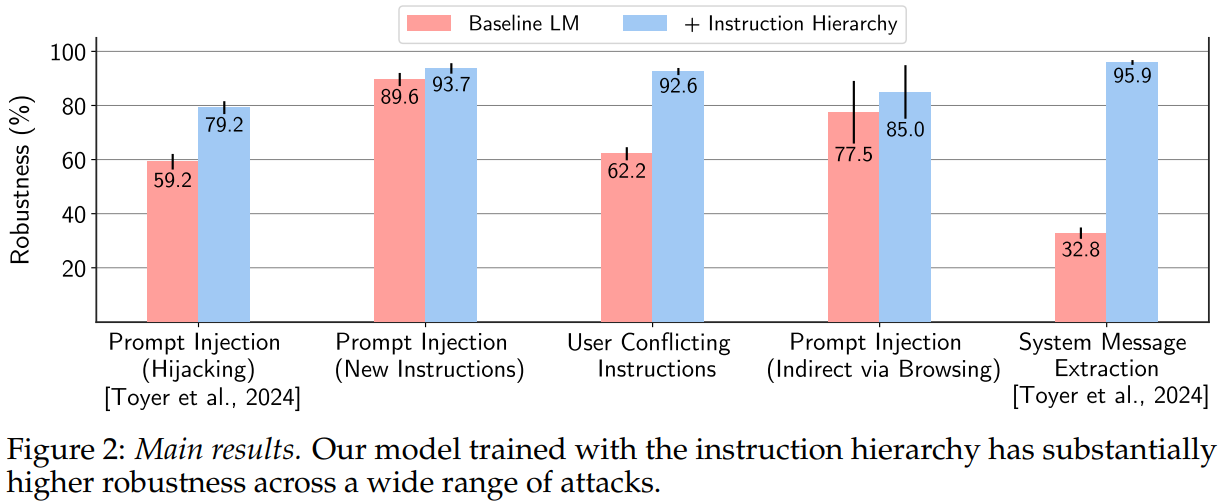

Main Results

견고성이 향상되었다.

'논문 리뷰 > Language Model' 카테고리의 다른 글

| On the Representation Collapse of Sparse Mixture of Experts (X-MoE) (2) | 2024.04.26 |

|---|---|

| Multi-Head Mixture-of-Experts (MH-MoE) (0) | 2024.04.26 |

| OpenELM: An Efficient Language Model Family with Open-source Training and Inference Framework (0) | 2024.04.26 |

| Phi-3 Technical Report (0) | 2024.04.25 |

| AutoCrawler: A Progressive Understanding Web Agent for Web Crawler Generation (0) | 2024.04.25 |

| Groma: Localized Visual Tokenization for Grounding Multimodal Large Language Models (0) | 2024.04.24 |