Abstract

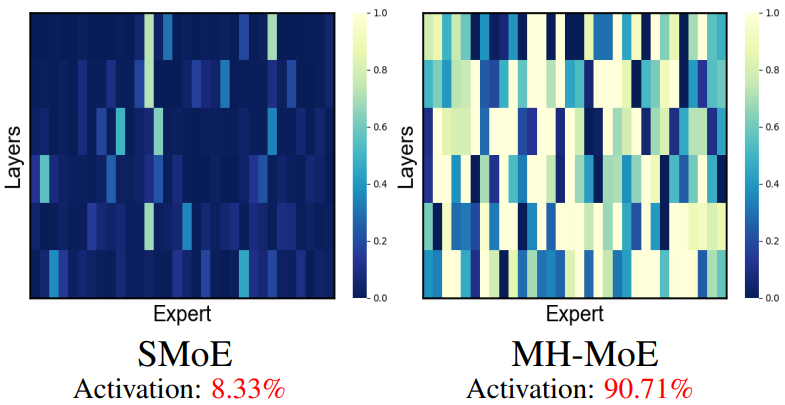

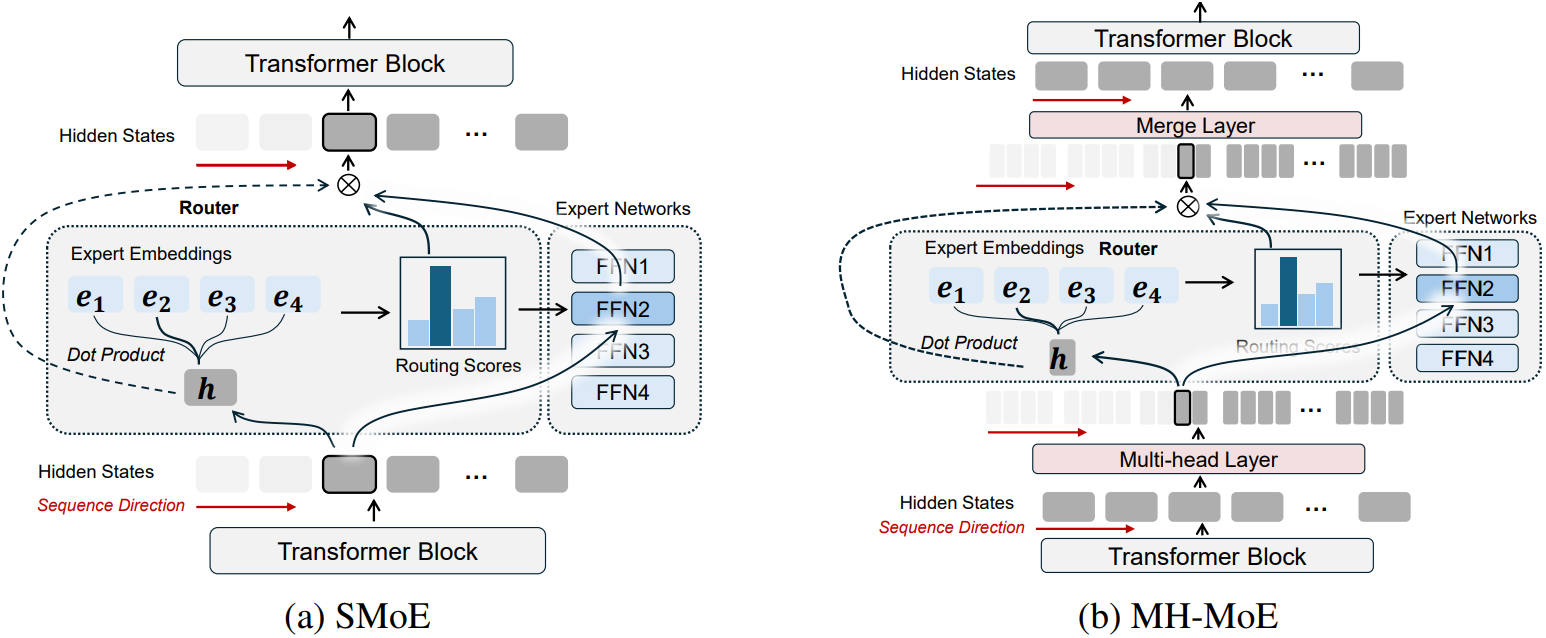

Input token을 sub-token으로 분해한 뒤 여러 expert에 할당하여 expert 활성률을 높이고 더 나은 이해력 제공

[arXiv](2024/04/23 version v1)

Method

Multi-Head Mixture-of-Experts

별 거 없음. 토큰을 투영하고, 나누고, MoE 수행하고, 붙이고, 투영하고, 끝.

각 전문가의 내부 차원을 스케일링하여 투영과 multi-head로 인해 추가된 계산량의 균형을 맞춘다.

Training Objectives

Load balancing loss

MoE에서 가장 흔하게 사용되는 손실. 라우팅 확률과 실제 라우팅된 비율의 내적.

Task specific loss

Experiments

MH-MoE는 X-MoE를 기반으로 구축된다.