Abstract

Region encoding을 기반으로 region-level task에 능숙한 MLLM인 Groma 소개

[Github]

[arXiv](2024/04/19 version v1)

Method

Model Architecture

Image Encoder

DINOv2: CLIP보다 고해상도에서 fine-grained feature를 포착하는 데 더 적합하다.

LLM에 입력되는 토큰 수를 줄이기 위해 인접한 4개의 패치를 하나로 연결한다.

Region Proposer

Deformable DETR의 head를 이진 분류기로 대체하여 region proposer로 사용.

Region Encoder

GLaMM의 region encoder와 동일하게 feature + region을 통합하여 region token을 생성한다.

LLM

Vicuna-7B. 추가 projection MLP를 통해 image, region token을 LLM에 투영한다.

Input and Output Formatting

Region token <rn>을 출력에서 참조할 수 있다.

사용자가 지정한 영역 또한 똑같이 인코딩하여 region token으로 처리한다.

Model Training

훈련은 3단계로 나뉜다.

Detection Pretraining

Detection dataset을 통해 Deformable DETR을 region proposer로써 훈련.

LLM과 분리된 architecture, training 덕분에 detection pretraining 지식의 이점을 얻을 수 있다.

Alignment Pretraining

정렬을 위해 projection MLP, region encoder를 훈련.

Instruction Finetuning

고품질 intstruction dataset을 통해 LLM을 fine-tuning.

GPT4V-assisted Grounded Conversation Generation

GPT-4V를 통해 Groma Instruct dataset 제작.

- 각 영역의 중앙에 마커를 오버레이한 이미지를 입력으로 사용하면 모델이 영역을 쉽게 참조할 수 있다.

- 지역, 이미지 설명, QA 예시를 제공하면 환각을 줄이고 모호성을 해결하는 데 유용하다.

- 수동으로 설계된 grounded chat을 추가 context 예제로 제공하여 통일된 형식의 대화를 생성한다.

Experiments

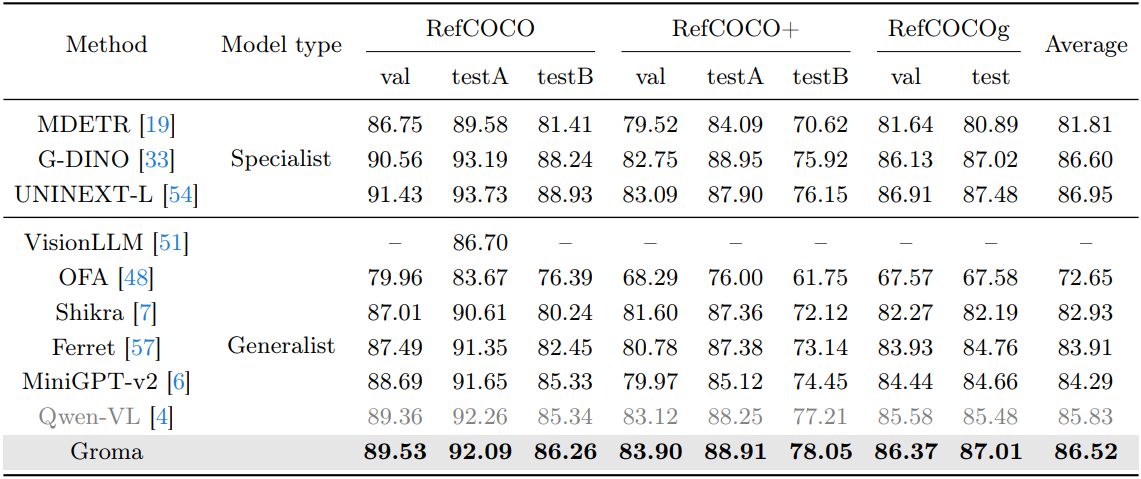

Grounding benchmark

'논문 리뷰 > Language Model' 카테고리의 다른 글

| The Instruction Hierarchy: Training LLMs to Prioritize Privileged Instructions (1) | 2024.04.25 |

|---|---|

| Phi-3 Technical Report (0) | 2024.04.25 |

| AutoCrawler: A Progressive Understanding Web Agent for Web Crawler Generation (0) | 2024.04.25 |

| TextSquare: Scaling up Text-Centric Visual Instruction Tuning (0) | 2024.04.24 |

| Toward Self-Improvement of LLMs via Imagination, Searching, and Criticizing (AlphaLLM) (0) | 2024.04.24 |

| TransformerFAM: Feedback attention is working memory (1) | 2024.04.19 |