[Github]

[arXiv](2024/02/06 version v1)

Abstract

현재까지 가장 크고 강력한 open-source CLIP model인 EVA-CLIP-18B 출시

참고: [EVA-01, EVA-02, EVA-CLIP]

Introduction

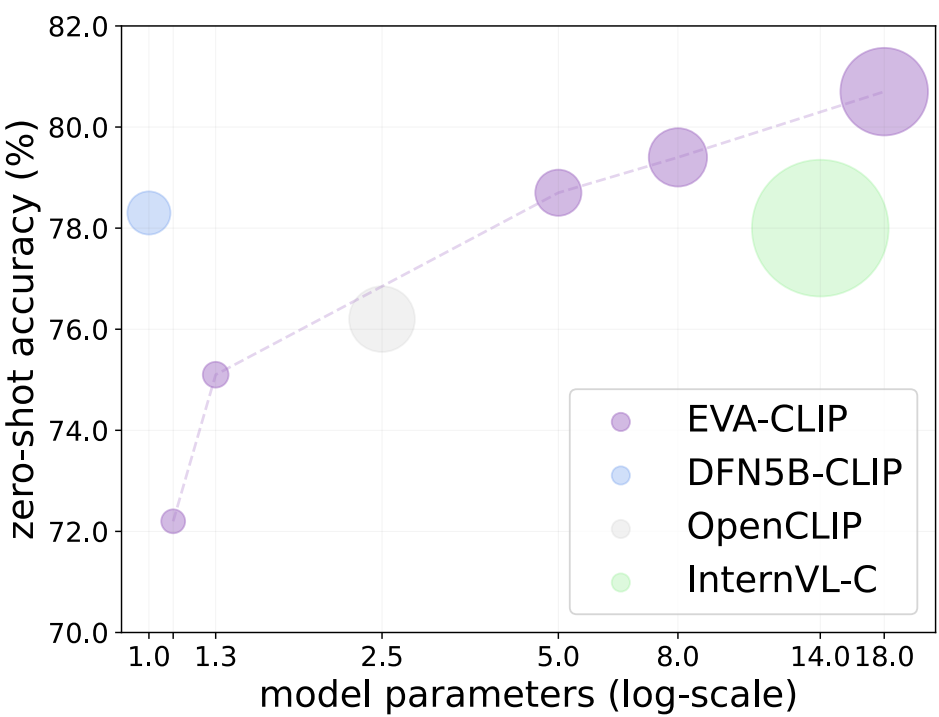

EVA-CLIP을 18B까지 확장.

포화의 징후를 보이지 않아 추가로 확장할 수 있는 잠재력이 있다.

Weak-to-Strong Vision Scaling

EVA 시리즈의 철학에 따라 작은 모델의 지식을 큰 모델로 증류하고 반복해서 더 큰 모델로 증류한다.

EVA-02-CLIP-E/14+를 교사로 EVA-02를 18B까지 확장하고 데이터셋은 대부분 고정된 상태로 유지된다.

또한 EVA-18B(≠ EVA-CLIP-18B)는 QKV projection의 bias를 생략하고 LayerNorm 대신 RMSNorm을 사용한다.

Experiments

Settings

비전 인코더로는 사전 훈련된 EVA-18B, 텍스트 인코더로는 EVA-02-CLIP-E/14+로 초기화한다.

하이퍼 피라미터는 논문 참고.

Dataset

Image-text pair로 구성된 Merged-2B dataset.

약 2천만 개의 video-text pair와 고해상도 image-text pair를 각각 추가한 Merged-2B+ dataset.

Zero-Shot Image Classification

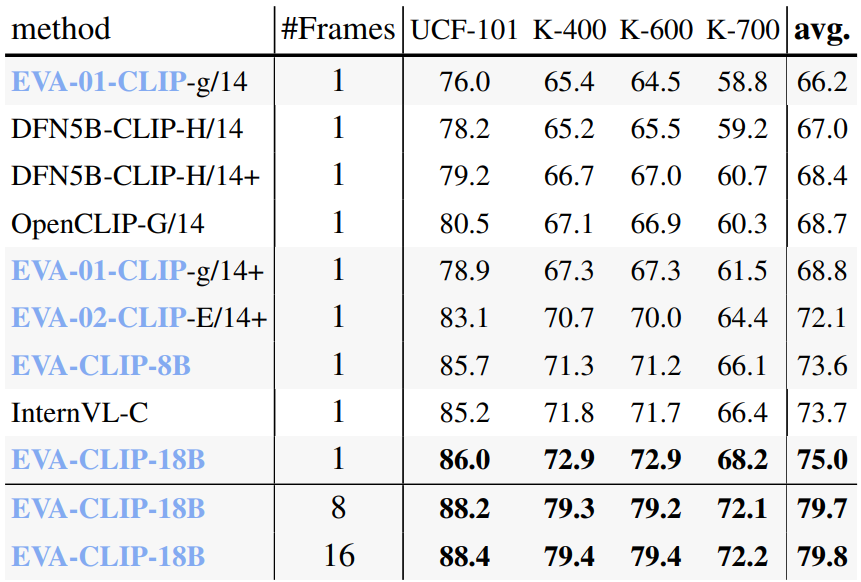

Zero-Shot Video Classification

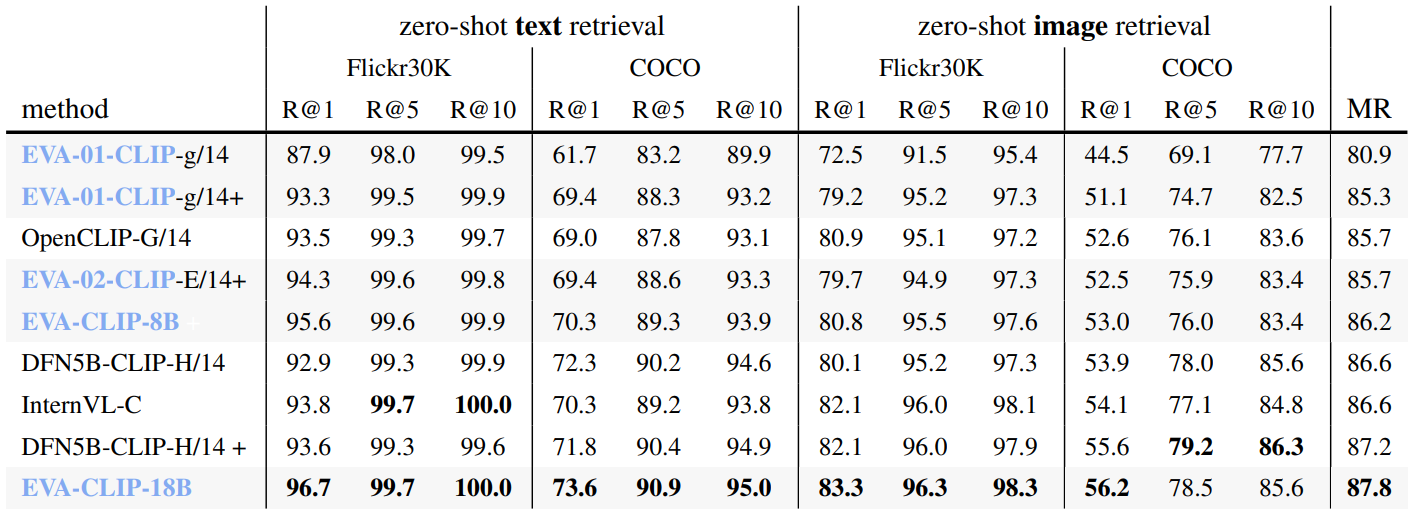

Zero-Shot Image-Text Retrieval

Robustness

3D Representation

Ablation Studies

Video Data

Image Resolution

근데 비디오와 고해상도 이미지 모두 데이터가 적어서 성능 향상이 애매한 거 아닌가...?

'논문 리뷰 > Vision Transformer' 카테고리의 다른 글

| VisionLLaMA: A Unified LLaMA Interface for Vision Tasks (0) | 2024.03.12 |

|---|---|

| FiT: Flexible Vision Transformer for Diffusion Model (0) | 2024.03.05 |

| From Sparse to Soft Mixtures of Experts (SoftMoE) (2) | 2024.02.23 |

| Rethinking Patch Dependence for Masked Autoencoders (CrossMAE) (1) | 2024.01.30 |

| Depth Anything: Unleashing the Power of Large-Scale Unlabeled Data (6) | 2024.01.26 |

| Scalable Pre-training of Large Autoregressive Image Models (AIM) (0) | 2024.01.19 |