EVA에서 훈련 효율성을 주로 개선하여 최대한 큰 배치에서 많이 훈련할 수 있도록 함

Foundation Model이라 그런 건지 각 샘플의 정확성?을 희생하고 배치를 최대한으로 늘렸더니 성능이 좋아짐. 사실 희생이라기도 뭐한게 결과적으로 과적합을 줄여주기도 하니까... 그럼 무조건 이득인데?

[Github]

[arXiv](Current version v1)

Abstract

CLIP 훈련의 효율성과 효과를 획기적으로 향상하는 일련의 모델인 EVA-CLIP 제안.

Introduction

CLIP은 강력한 vision-language foundation model이지만 높은 훈련 비용과 확장 시 훈련 불안정성 문제가 있다.

본 논문에서는 pre-training EVA 표현으로 CLIP을 초기화하고 훈련 프로세스 안정화, 제로샷 성능 향상 등을 가능하게 하는 여러 기술을 통합한다. EVA-CLIP은 동일한 수의 피라미터에 훨씬 더 적은 훈련 비용으로 이전 CLIP 모델에 비해 우수한 성능을 달성했다.

Approach

Better Initialization

Pre-training EVA 가중치로 EVA-CLIP 이미지 인코더 초기화.

Optimizer

대규모 배치를 사용하는 CLIP 훈련에 유용한 LAMB optimizer 사용.

FLIP

FLIP 논문에 따라 입력 이미지 토큰 중 50%를 무작위로 마스킹. 추가 메모리 소모 없이 배치 크기를 2배로 늘릴 수 있다.

Settings

훈련 프로세스를 더욱 개선하기 위해 DeepSpeed optimization library(ZeRO stage-1 optimizer, gradient checkpointing, flash attention) 사용.

xFormers library,

EVA-01-CLIP은 FP16 정밀도, EVA-02-CLIP은 bfloat16 형식 사용.

Experiments

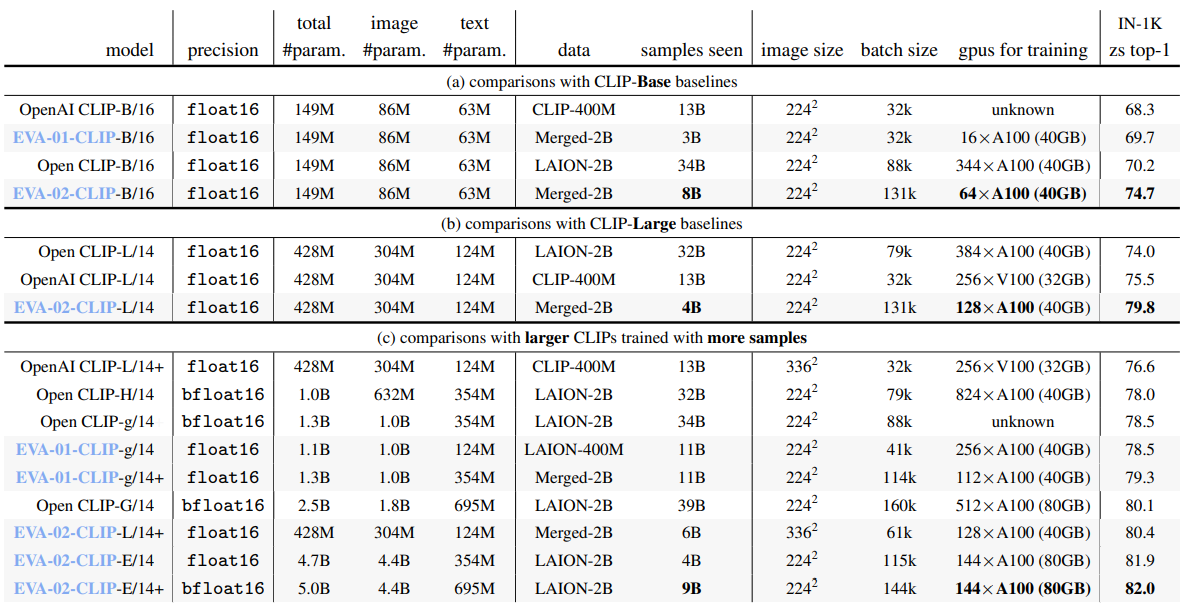

CLIP model configurations and zero-shot top-1 accuracy on ImageNet

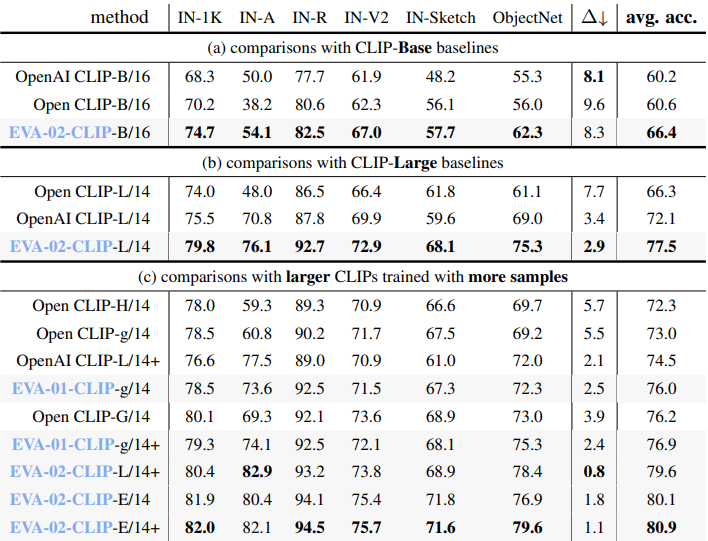

Summary of zero-shot performance on ImageNet variants and ObjectNet

Summary of EVA-CLIP zero-shot image classification performance on 27 datasets