Architecture 개선, EVA-01의 visual feature space 계승

[Github]

[arXiv](Current version v2)

[EVA-01]

Abstract

MIM(Masked Image Modeling)을 통해 language-aligned vision feature를 재구성하도록 사전 훈련된 차세대 Transformer 기반 시각적 표현인 EVA-02 출시.

Introduction

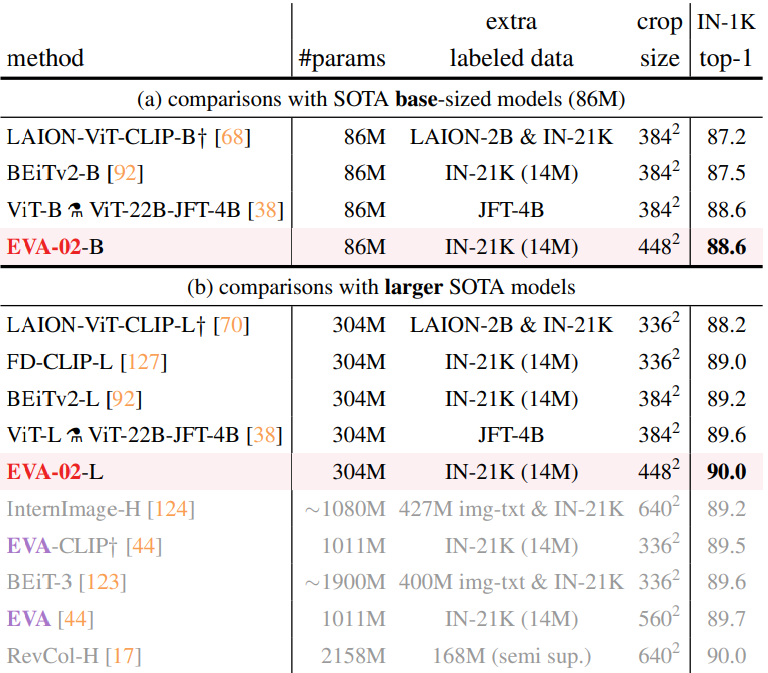

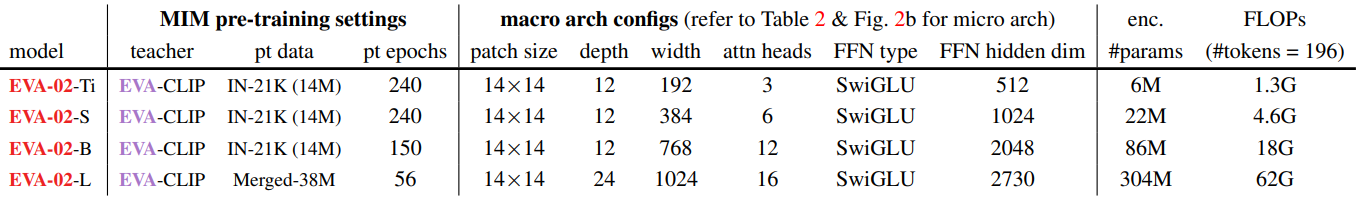

MIM pre-training을 통해 CLIP의 시각적 표현과 적당한 모델 크기를 갖춘 강력하게 최적화된 ViT 시리즈인 EVA-02 제시.

EVA-02 시리즈는 6M부터 304M까지 다양한 모델 크기가 포함되어 있으며 다운스트림 작업에 탁월한 성능을 보여줌.

Approach

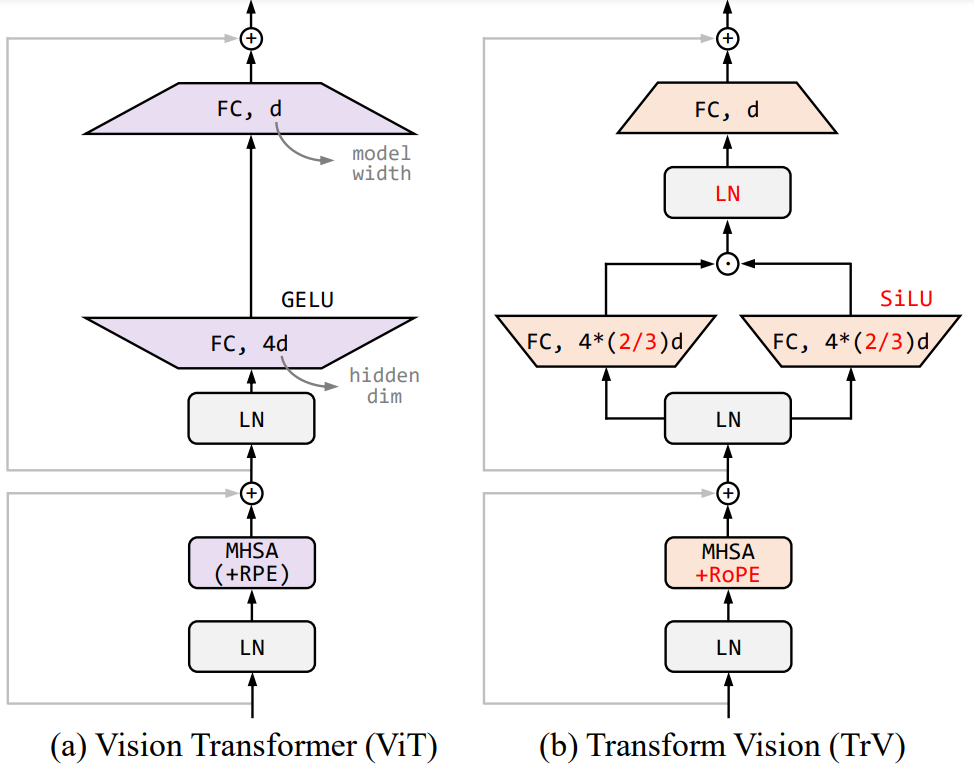

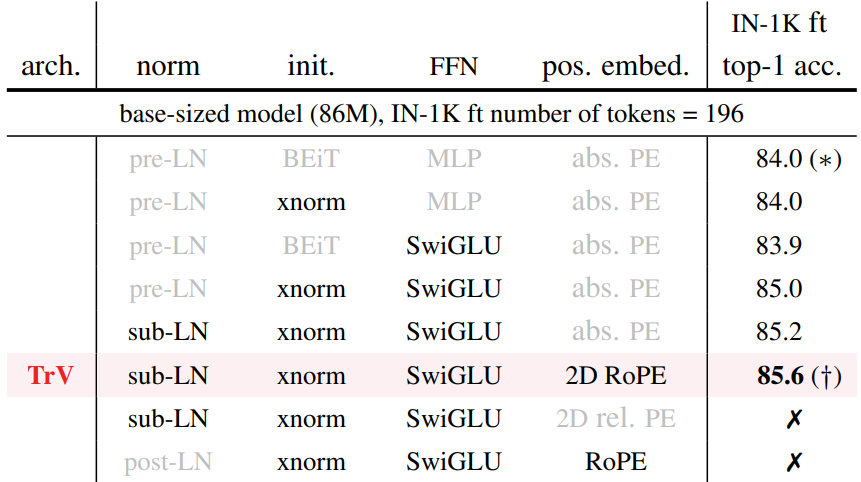

Architecture

- SwiGLU(SiLU + GLU)

- Sub-LN

- 2D rotary position embedding(RoPE)

- Xavier initialization

Pre-training Strategy

각 모델을 MIM 교사로 사용했을 때의 정확도:

EVA-01 교사는 오히려 성능이 떨어졌다. (a)

연구진은 EVA-01의 많은 피라미터로 인해 더 많은 pre-training이 필요하다고 가정하여 실험했다. (b)

(근데 다른 모델을 교사로 TrV를 교육한 결과는 왜 없음? 통계조작 아님?)

더 큰 데이터셋에 대해 학습하면 더 성능 좋아짐 (c)

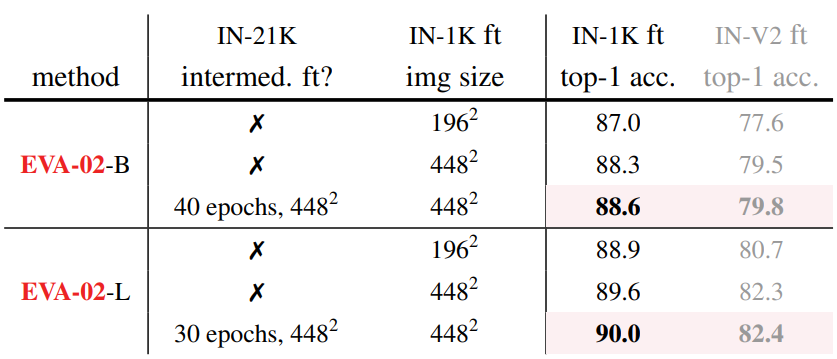

Label이 있는 데이터로 추가 fine-tuning을 하면 성능을 더 향상할 수 있다.

Model variants

Pre-training objective

학습 과정은 목표 모델이 CLIP에서 EVA-01로 바뀐 거 말고는 EVA-01과 똑같음.

Experiments