[Github]

[arXiv](2024/01/20 version v1)

Project Page 보면 정렬은 확실히 좋은데 품질은 잘 모르겠는 느낌...? Realistic 하지 않달까...

Abstract

다양한 보상 함수에 대한 대규모 공동 훈련

Method

강화 학습에 대한 지식이 없으신 분들은 이 글에서 ' Baseline function을 빼면 gradient의 분산이 줄어드는 이유' 까지만 보시면 됩니다.

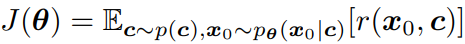

RL 목표: 피라미터 θ를 통해 보상 r 최대화

Policy Gradient with Multi-step MDP (Markov decision process)

Denoising process를 정책으로 취급하고 최종 결과물에만 보상을 준다.

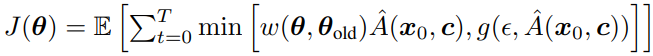

안정적인 훈련을 위해 importance sampling, advantage function, clipped trust region을 사용한다.

Importance sampling: 새 정책이 이전 정책으로부터 얼마나 벗어났는지를 측정하고, 이를 통해 새 정책의 효과를 평가한다.

Clipped trust region: 너무 높거나 낮은 점수는 잘라낸다.

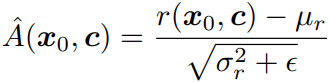

Advantage function: 보상을 정규화. 우리의 훈련 세트가 매우 크기 때문에 배치 별로 수행한다.

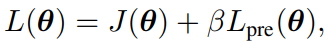

최종 훈련 목표는 다음과 같다.

Distribution-based Reward Functions

모델이 다양한 출력을 생성하도록 하는 것이 목표라면, 모델 전체의 출력 분포를 고려해야 한다. 하지만 실제 생성 분포를 구성하는 것은 어렵기 때문에, 미니 배치에 대한 경험적 샘플을 사용하여 근사치를 구할 수 있다. (Training task 중 하나로 사용함.)

Multi-task Joint Training

단일 모델에서 다양한 training task에 대해 공동으로 훈련한다.

Multi-reward Joint Optimization

- 인간 선호도 모델

- 다양한 피부색을 생성하기 위한 공정성, 다양성 목표

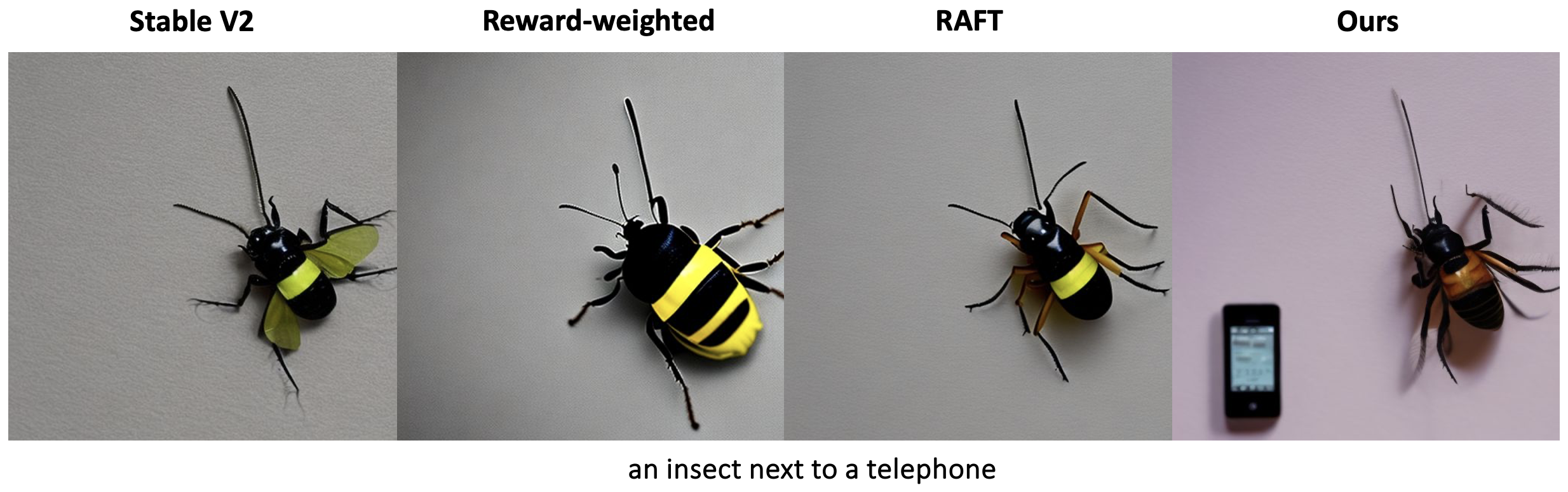

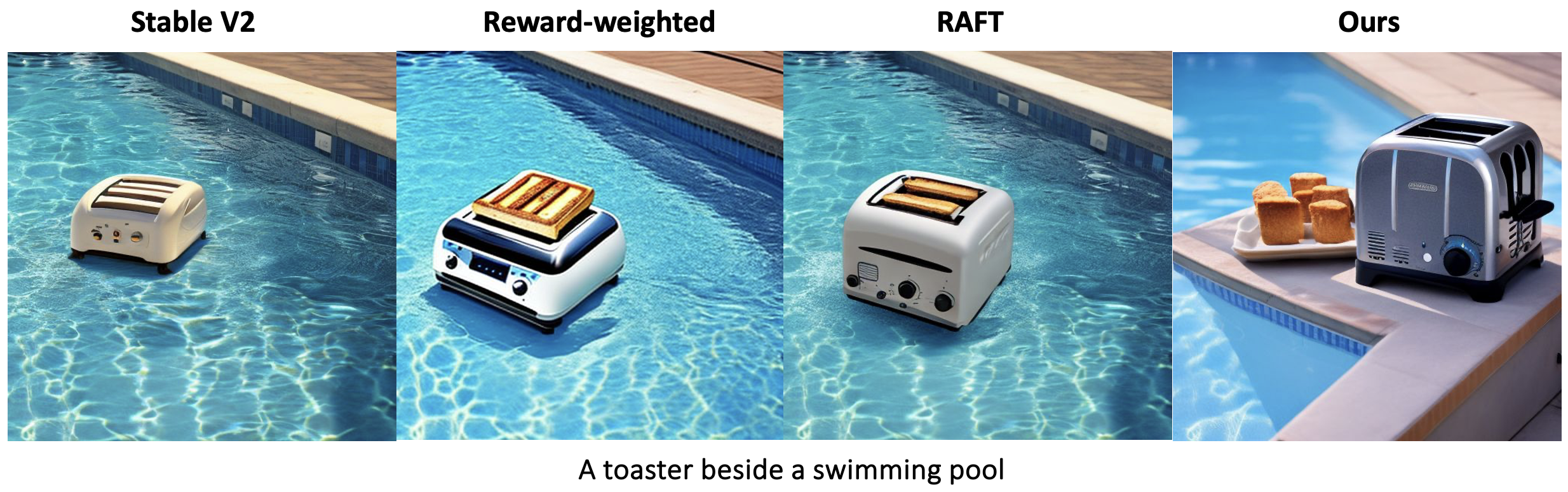

- 5가지 관계 용어(“and,” “next to,” “near,” “on side of” and “beside,”) 중 하나를 사용하여 서로 다른 두 개체 간의 공간적 관계를 잘 생성하기 위한 목표

대규모 데이터셋에서 위 3가지 목표에 대해 공동으로 훈련한다.

공동 훈련 모델은 각 목표에 대해 개별적으로 fine-tuning 된 모델의 80% 이상의 성능을 동시에 충족했다.

다른 건 모르겠고 공간적 관계는 ㄹㅇ 잘 생성하긴 함

SOCIAL MEDIA TITLE TAG

SOCIAL MEDIA DESCRIPTION TAG TAG

pinterest.github.io