[Github]

[arXiv](2024/01/22 version v1)

|

|

|

Abstract

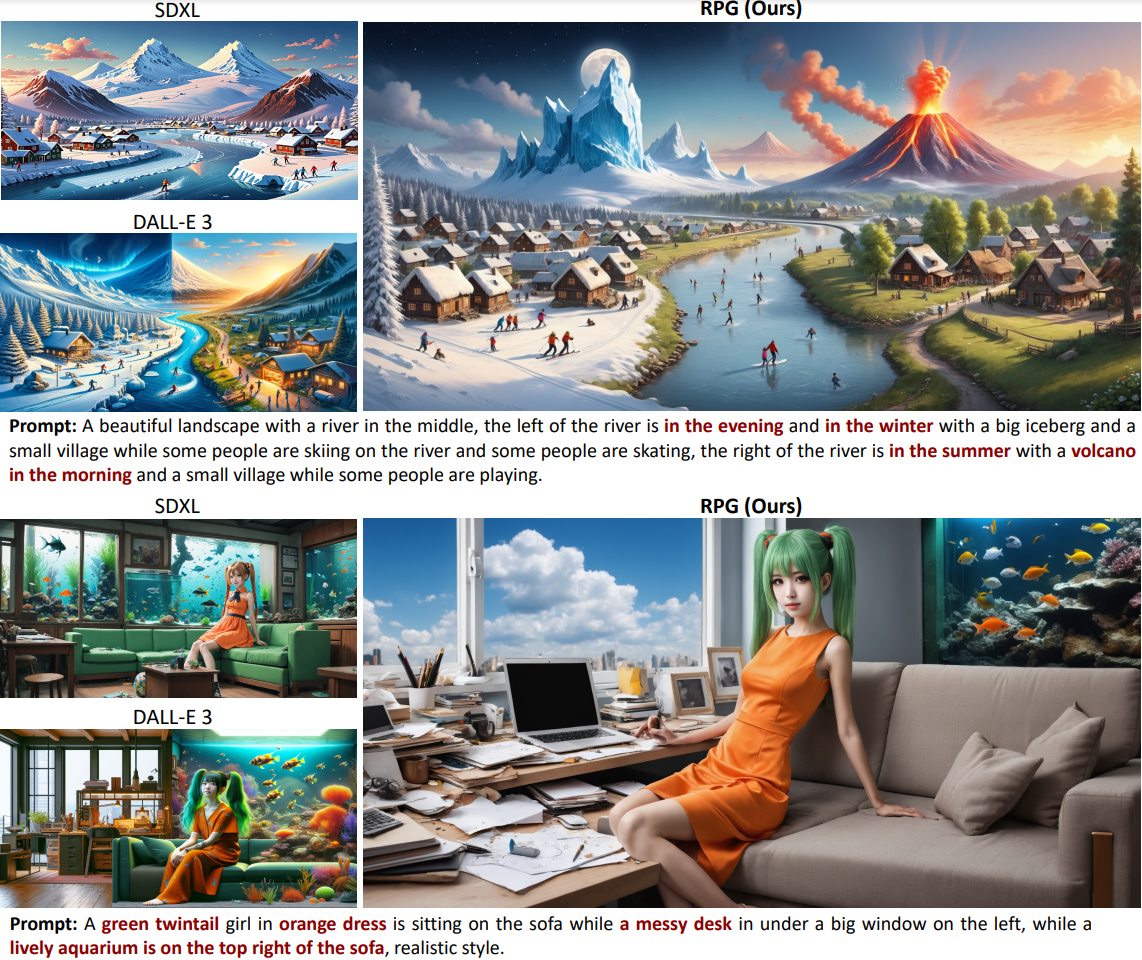

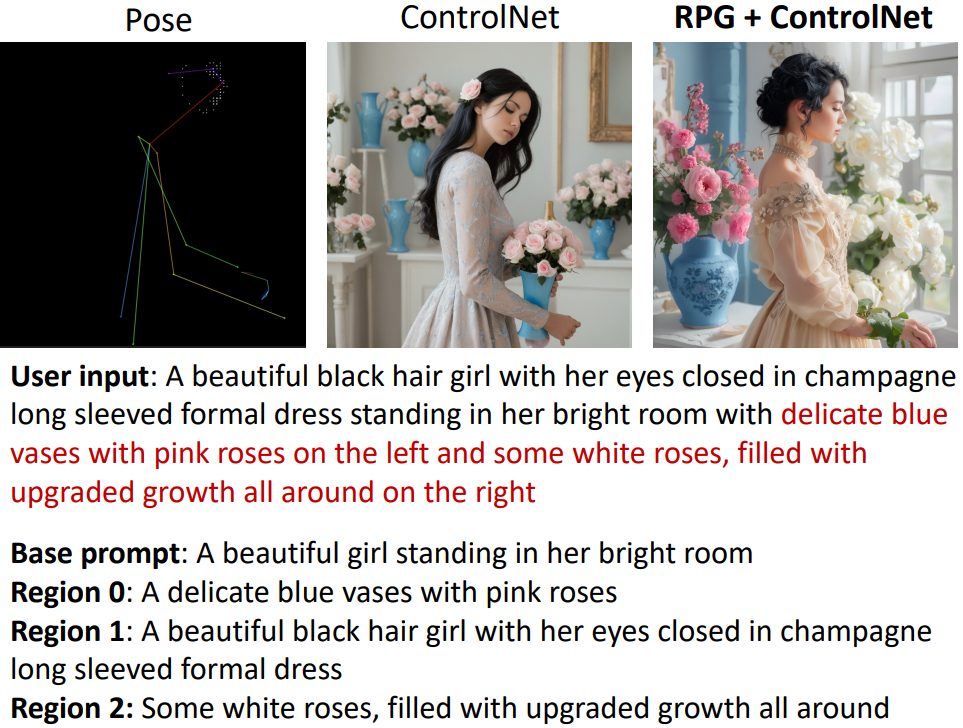

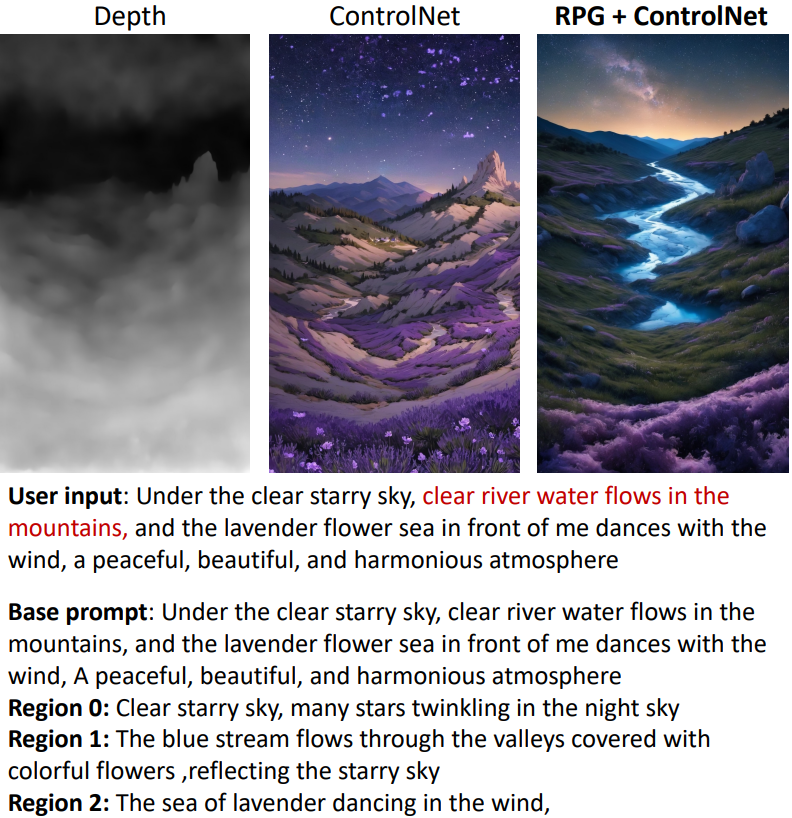

복잡한 이미지 생성을 LLM을 통해 간단한 하위 영역 생성으로 분해하는 Recaptioning, Planning, and Generating (RPG)

Keyword: Multimodal Recaptioning, Chain-of-Thought Planning, Complementary Regional Diffusion

Method

Text-to-image Generation

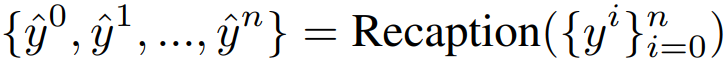

Prompt Recaptioning

User prompt yc에서 핵심 문구를 식별하고

충실도를 향상하기 위해 세부 정보를 보완한다.

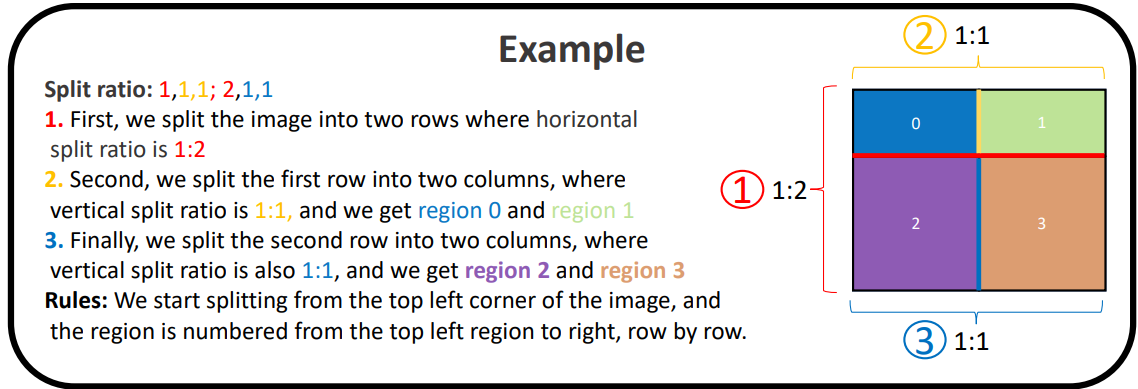

CoT Planning for Region Division

LLM의 Chain-of-thought (CoT) 추론 능력을 활용하여 각 prompt를 각 영역 R에 할당한다.

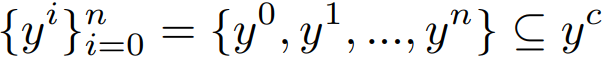

영역 분할을 다음과 같이 표기:

CoT 추론의 간소화 템플릿:

3가지 핵심 원칙:

- 같은 class인 개체는 각각의 영역을 가진다. (e.g. '사과 5개'의 경우 각 사과가 서로 다른 영역을 가짐)

- 두 개체의 복잡한 상호 작용의 경우 두 개체를 전체적으로 사용(?)하여 모순된 중복 생성을 피한다. (배경을 지정하지 않는다는 뜻인 듯?)

- 외형에 초점을 맞춘 prompt의 경우 각기 다른 개체로 취급한다. (e.g. red blouse, blue skirt)

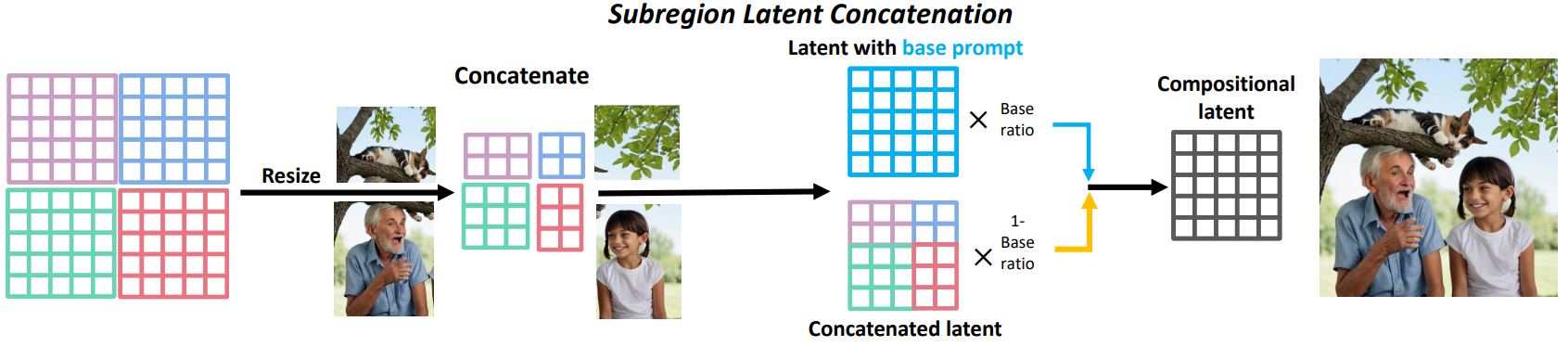

Complementary Regional Diffusion

다음과 같이 n+1개의 prompt와의

cross-attention을 통해 n+1개의 결과를 생성.

Resize and concat

합칠 때는 base latent와의 가중합을 사용.

Text-Guided Image Editing

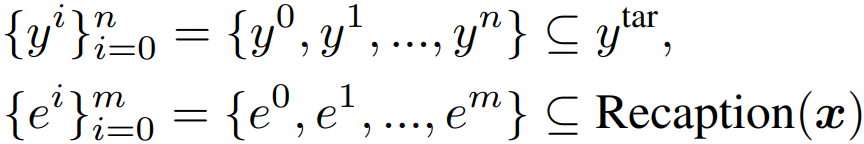

Image Recaptioning

Multi-modal LLM(e.g. GPT-4, Gemini)을 통해 이미지 x와 prompt y의 개체를 식별한다.

CoT Planning for Editing

마찬가지로 고품질 예제를 통해 CoT를 트리거한다.

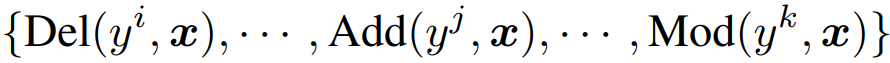

MLLM은 Del, Add, Mod를 포함해 일련의 편집 지침을 계획한다.

Contour-based Regional Diffusion

SAM을 통해 편집 명령과 관련된 마스크를 식별하고 Complementary Regional Diffusion을 통해 편집.

Multi-Round Editing for Closed-Loop Refinement

위와 같은 close-loop를 반복하여 보다 가깝게 target prompt에 정렬할 수 있다.

Experiments

GPT-4, SDXL 사용.

동일한 class의 개체가 여럿 포함된 경우 base ratio를 높게, class가 다른 개체(e.g. ceramic vase and glass vase)가 포함된 경우 낮게 설정하는 것이 좋다.