[arXiv](2024/01/24 version v1)

Abstract

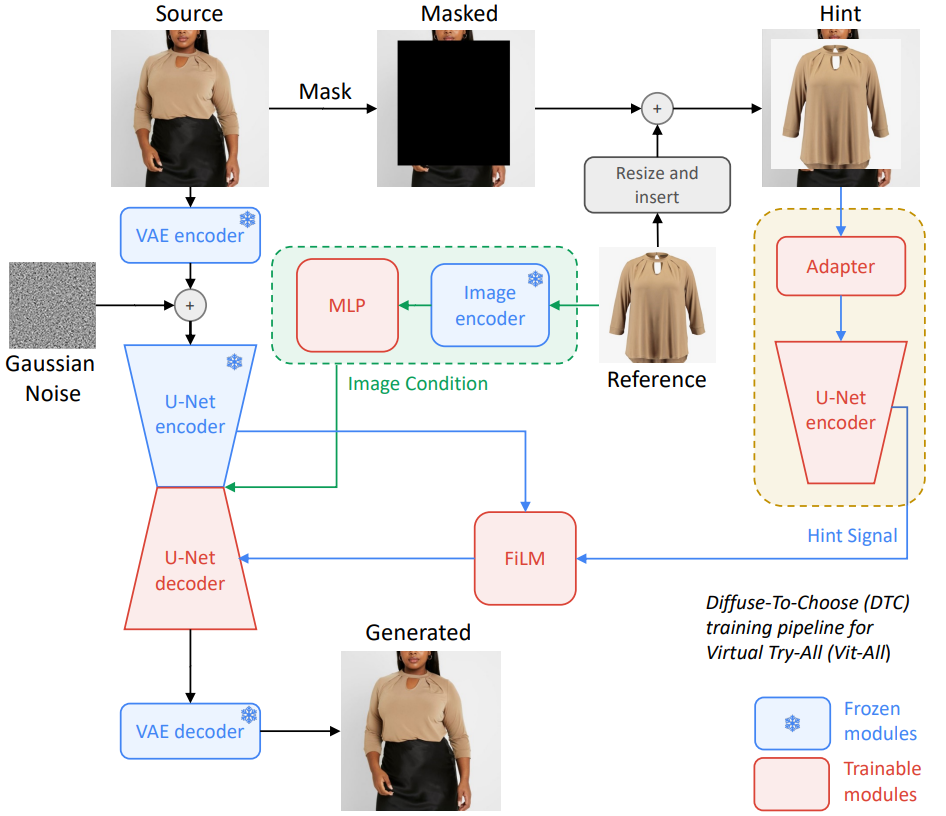

Virtual try-on을 위한 확산 기반 인페인팅 모델인 Diffuse to Choose (DTC)

Method

Diffusion Inpainting Models

PBE에서는 복붙 아티팩트를 피하기 위해 참조 이미지의 클래스 토큰만을 가져왔지만 본문에서는 참조 이미지의 feature가 중요하므로 모든 패치를 받으며 더 큰 이미지 인코더인 DINOv2를 사용하였다.

또한 diffusion loss 외에도 색상 등의 정렬을 위해 생성 이미지와 소스 이미지에 대해 VGGNet의 perceptual loss를 도입했다.

Design of Diffuse to Choose

Creating the Hint Signal

ControlNet의 구조에서 영감을 받아 보조 U-Net 인코더를 사용한다.

인코더 입력도 ControlNet과 비슷하게 latent + conv layer를 통과한 condition이다.

Combining Hint Signal with Main U-Net

보조 U-Net 인코더의 정보를 메인 U-Net 디코더에 주입하는 3가지 방법을 실험하고

- ControlNet과 같은 잔차 연결

- Cross-attention

- Feature-wise Linear Modulation (FiLM)

디테일을 보존하는 데 필수적인 feature channel을 향상시키는 FiLM을 채택하였다.

Experiments

https://diffuse2choose.github.io/

As online shopping is growing, the ability for buyers to virtually visualize products in their settings—a phenomenon we define as "Virtual Try-All"—has become crucial. Recent diffusion models inherently contain a world model, rendering them suitable fo

diffuse2choose.github.io