현재 semantic segmentation의 여러 벤치마크에서 SOTA를 차지하고 있는 ViT-Adapter

GitHub - czczup/ViT-Adapter: Vision Transformer Adapter for Dense Predictions

Vision Transformer Adapter for Dense Predictions. Contribute to czczup/ViT-Adapter development by creating an account on GitHub.

github.com

Abstract

ViT를 위한 간단하지만 강력한 어댑터를 조사한다. 비전별 유도 편향을 아키텍처에 도입하는 최근의 시각적 transformer와 달리 ViT는 이미지의 사전 정보가 부족하여 dense prediction에서 성능이 떨어진다. 이 문제를 해결하기 위해 ViT의 결함을 해결하고 추가 아키텍처를 통해 유도 편향을 도입하여 비전별 모델과 동등한 성능을 달성할 수 있는 Vision Transformer Adapter(ViT-Adapter)를 제안한다. 특히, 본 논문의 프레임워크의 백본은 multi-modal 데이터로 사전 학습할 수 있는 vanilla transformer이다. 다운스트림 작업을 미세 조정할 때, 양식별 어댑터를 사용해 데이터와 작업의 prior 정보를 모델에 도입하여 이러한 작업에 적합하게 만든다.

(dense prediction = semantic segmentation, instance segmentation 등의 픽셀 단위 예측을 의미)

Introduction

ViT와 같은 vanilla transformer는 다양한 임베딩을 사용하여 이미지, 비디오 및 텍스트 측면에서 multi-modal 데이터를 처리할 수 있다. 그러나 ViT는 작업별 transformer와 비교하여 다운스트림 작업에서 사전 정보가 부족하다는 결정적인 결함을 가지고 있다. 따라서 본 논문에서는 NLP 분야의 어댑터에서 영감을 받아, ViT와 같은 vanilla transformer와 다운스트림 비전 작업을 위한 전용 모델 사이의 격차를 줄이기 위한 어댑터를 개발하는 것을 목표로 한다.

이를 위해 ViT-adapter를 제안하는데, 이는 원래 아키텍처를 변경하지 않고 ViT를 다운스트림 dense prediction에 효율적으로 적용할 수 있는 추가 네트워크이다.

특히, 유도 편향을 vanilla transformer에 도입하기 위해 3가지 맞춤형 모듈을 설계한다.

- 입력 이미지의 local semantics를 캡처하기 위한 spatial prior 모듈

- ViT에 spatial prior을 통합하기 위한 spatial feature 주입기

- Dense prediction에 필요한 다중 스케일 특징을 재구성하기 위한 다중 스케일 feature 추출기

위의 그림과 같이, 대규모 이미지 데이터 세트에 대한 사전 훈련과 다른 작업에서 미세 조정했던 이전 패러다임에 비해 본 논문의 패러다임은 더 유연하다. 백본 네트워크는 multi-modal 데이터 및 작업으로 사전 훈련될 수 있는 일반 모델이며 이를 다운스트림 작업에 적용할 때 사전 훈련 없는 특정 어댑터를 사용하여 모델을 다운스트림 작업에 적합하게 만든다. 이러한 방식으로, ViT-adapter는 dense prediction을 위해 특별히 설계된 Swin Transformer와 같은 transformer 백본과 비교할 수 있거나 심지어 더 나은 성능을 달성한다.

본 논문의 기여는 다음과 같다.

- ViT 백본에 image prior를 도입하여 다운스트림 비전 작업에서 Swin Transformer 및 PVTv2와 같은 전용 transformer 사이의 격차를 메울 수 있는 ViT용 dense prediction 어댑터를 제안한다.

- ViT의 구조를 변경하지 않고 image prior를 도입하기 위해 spatial prior 모듈과 two feature interaction operators를 설계했다.

- 여러 까다로운 벤치마크에서 ViT-adapter를 평가하여 이전 모델에 비해 향상된 성능을 보여준다.

Related Work

Vision Transformer Adapter

Overall Architecture

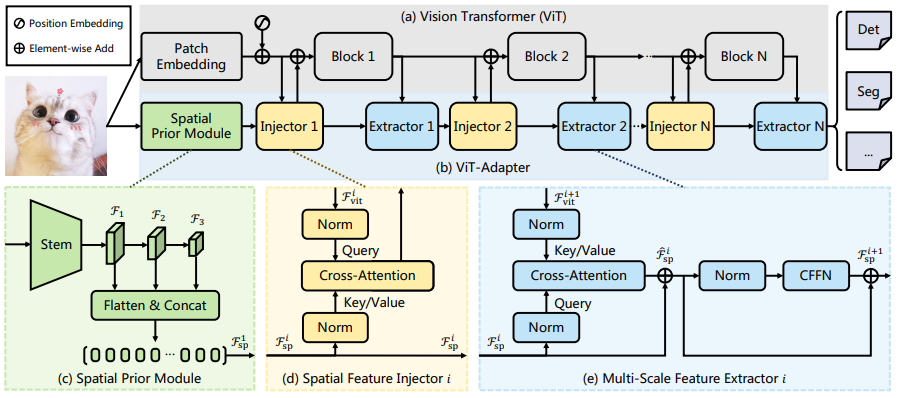

전체적인 구조는 다음과 같이 백본 ViT 네트워크와 ViT-adapter로 나뉘어있다.

Spatial Prior Module

Spatial prior 모듈은 3개의 컨볼루션과 max pooling으로 구성된 stem 계층(찾아보니까 초기 시각적 처리를 의미한다고 합니다.)과 3개의 stride-2 컨볼루션으로 이루어져 있다. 얻어진 각 해상도의 feature map을 D 차원에 맞추기 위해 1x1 컨볼루션 후 평평하게 만들어 feature token F1sp를 만든다.

Feature Interaction

기둥형 구조의 ViT의 feature map은 피라미드 구조와 비교하여 성능이 떨어진다. 따라서 어댑터와 ViT 사이의 feature map을 통신하기 위한 두 가지 상호작용 모듈을 제안한다. 먼저 transformer 인코더를 N개의 동일한 블록으로 나누고, 제안된 두 개의 모듈을 각 블록 전후에 적용한다.

Spatial Feature Injector

주입기는 i번째 transformer feature를 query로 받고 spatial prior feature를 key와 value로 받아 multi-head cross-attention을 실행한다.

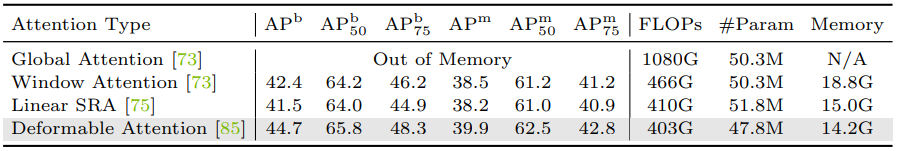

계산 비용을 줄이기 위해, 선형 복잡성을 가진 sparse attention인 deformable attention을 채택하여 attention을 구현한다. 또한 학습 가능한 벡터인 γ를 도입하여 Fvit와 Fsp의 균형을 맞춘다.

Multi-Scale Feature Extractor

추출기에서는 역할을 바꿔 Fsp를 query로 deformable attention을 한다.

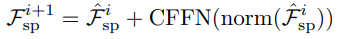

또한 고정 크기 위치 임베딩의 결함을 해결하기 위해 depth-wise 컨볼루션을 통해 local 연속성을 향상시키는 convolution feed-forward network(CFFN)를 추가한다.

최종 결과는 다음 블록의 입력으로 사용된다.

Architecture Configurations

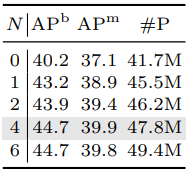

ViT의 각 버전에서 어댑터의 피라미터 수

패치 크기는 16, 블록 수 N은 4로 설정.

마지막 상호 작용 단계에서는 3개의 추출기를 쌓는다.

Conclusion

본 연구는 ViT-Adapter를 도입하여 dense prediction에서 ViT와 비전별 transformer 간의 성능 격차를 해소한다. ViT의 아키텍처를 변경하지 않고 ViT에 이미지를 먼저 주입하고 spatial prior 모듈을 통해 다중 스케일 feature를 추출한 다음 두 가지 feature 상호 작용 모듈을 사용한다. 다양한 벤치마크에 대한 광범위한 실험은 본 논문의 모델이 비교 가능한 매개 변수 수에서 잘 설계된 비전별 transformer보다 비교 가능하고 더 나은 성능을 달성할 수 있음을 검증한다.

Experiments

현재 SOTA인 부분

객체 탐지 인스턴스 분할 : COCO

시맨틱 분할 : ADE20K

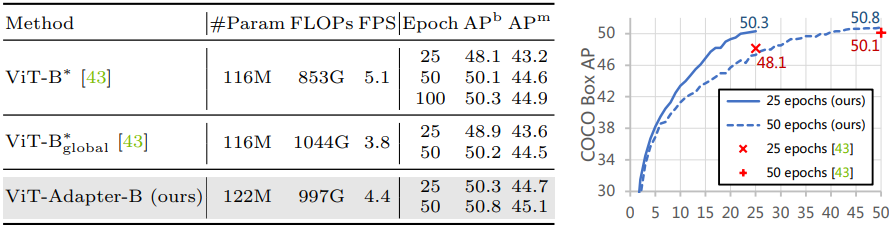

객체 탐지 밑 인스턴스 분할 (MS = mutil scale training)

불친절하게도 1등에 표시를 안해놨다... 그것도 전부 다...

각각의 다른 프레임 워크에서의 객체 탐지

사전 훈련에서 조금의 추가 피라미터만으로 훨씬 빠른 수렴 속도 향상을 보여준다.

시맨틱 분할에서 모델별, 모델 버전 별 비교

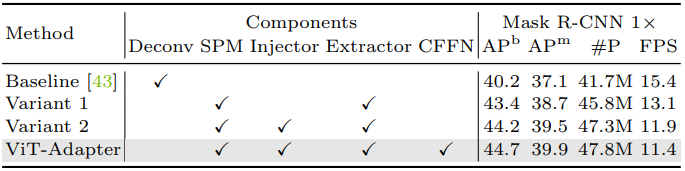

Ablation

Transformer 분할 블록 수

Attention 방법 비교

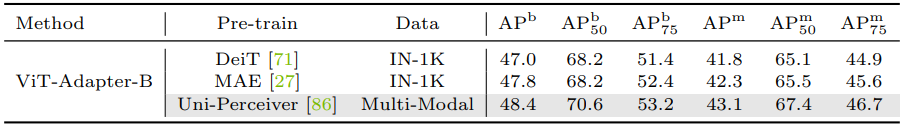

사전 훈련 효과

Feature map 시각화

논문의 부록에 더 많은 정성적, 정량적 평가가 있습니다.