Abstract

Dataset을 분할하여 단계적으로 DPO 수행

[arXiv](2024/03/28 version v1)

Stepwise DPO

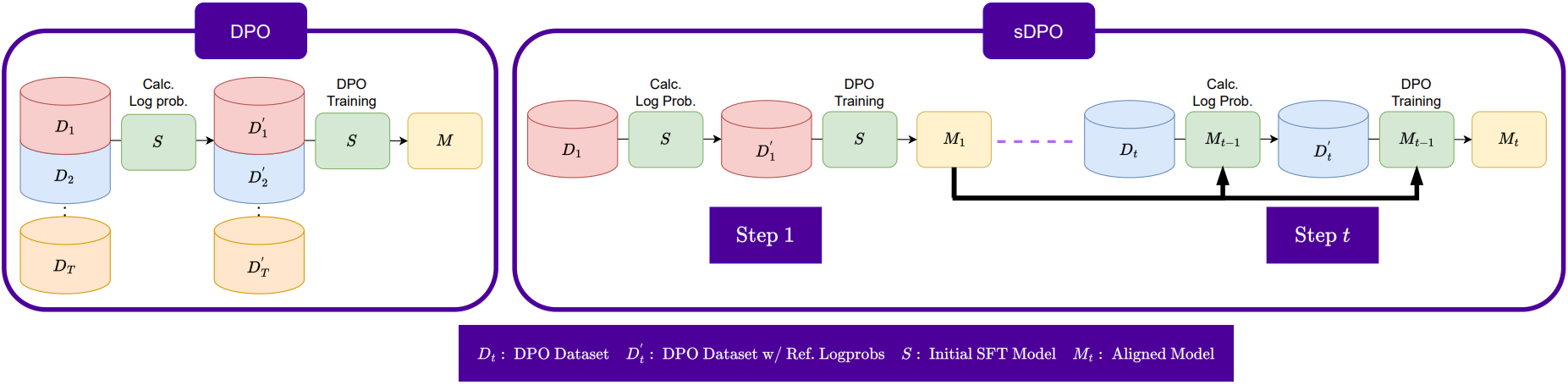

sDPO의 아이디어는 매우 단순하다. 데이터셋을 하위 집합으로 분할하여 단계적으로 DPO를 수행한다.

참조 모델의 로그 확률 계산은 DPO를 수행하기 위해 필요하다.

참조 모델은 목표 모델의 하한으로 작용하며, 이 하한을 점점 높임으로써 최종 모델의 성능을 향상할 수 있다는 것이다.

동일한 데이터셋으로 여러 번 학습하는 것과 뭐가 다르지? 라고 생각할 수 있지만 논문에 언급되어 있는 것처럼 쉬운 작업부터 시작해서 어려운 작업까지 단계적인 커리큘럼을 사용하면 복잡한 문제에 더 잘 적응할 수 있을 것 같긴 하다. 실험에서도 정량적으로 증명했다.

Experiments

OpenOrca → Ultrafeedback dataset을 사용했다.

Claude 피셜 Ultrafeedback이 더 어렵다고 함.

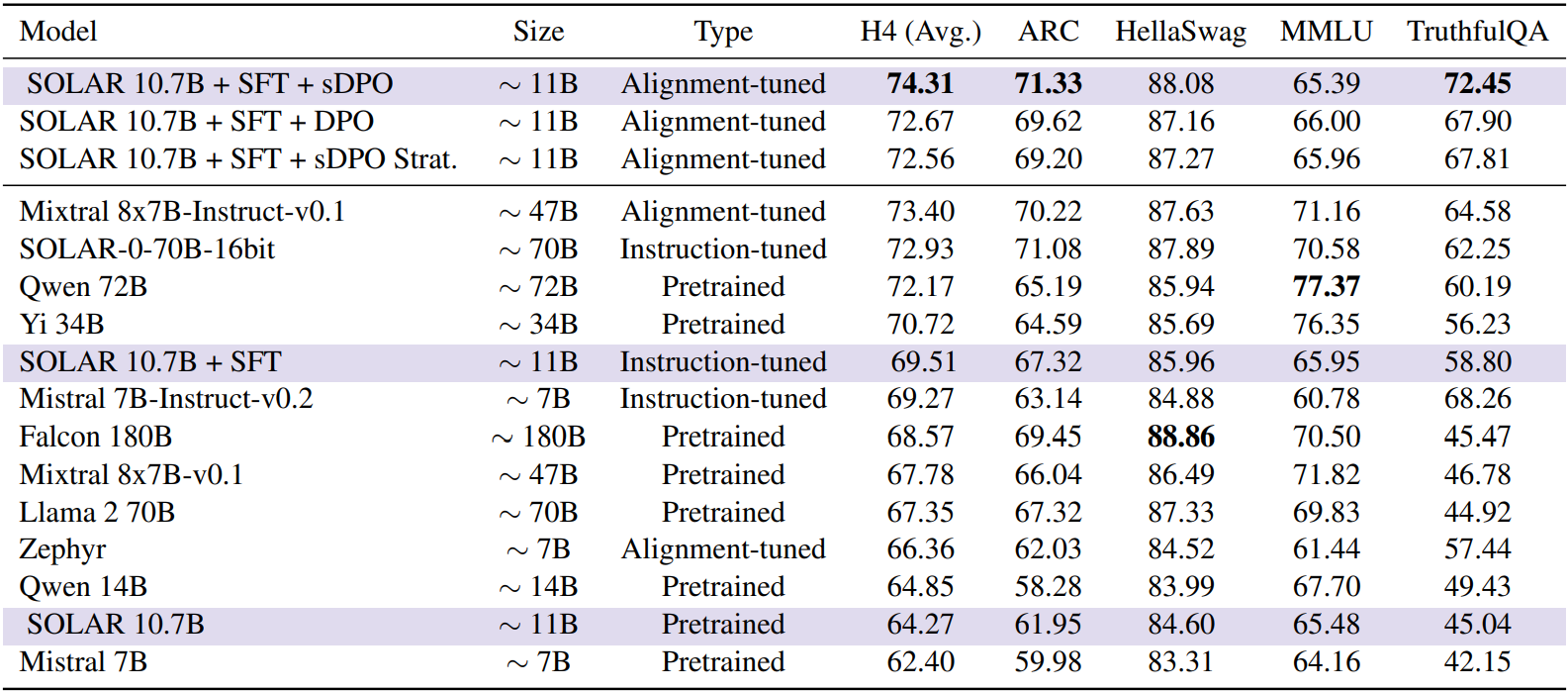

Main Results

sDPO Strat. 모델은 OpenOrca + Ultrafeedback 통합 데이터셋을 두 부분으로 나눈 것으로 기본 sDPO가 더 성능이 좋은 것으로 미루어 보아 단계적인 커리큘럼이 유효했다는 것을 알 수 있다.

'논문 리뷰 > Language Model' 카테고리의 다른 글

| Octopus v2: On-device language model for super agent (0) | 2024.04.05 |

|---|---|

| Advancing LLM Reasoning Generalists with Preference Trees (Eurus) (0) | 2024.04.04 |

| Gecko: Versatile Text Embeddings Distilled from Large Language Models (0) | 2024.04.03 |

| Mini-Gemini: Mining the Potential of Multi-modality Vision Language Models (0) | 2024.04.01 |

| Quiet-STaR: Language Models Can Teach Themselves to Think Before Speaking (0) | 2024.03.27 |

| STaR: Bootstrapping Reasoning With Reasoning (0) | 2024.03.27 |