Abstract

답변에 대한 이론적 근거를 생성하도록 하고 bootstrapping을 통해 지속적으로 향상

[Github]

[arXiv](2022/05/20 version v2)

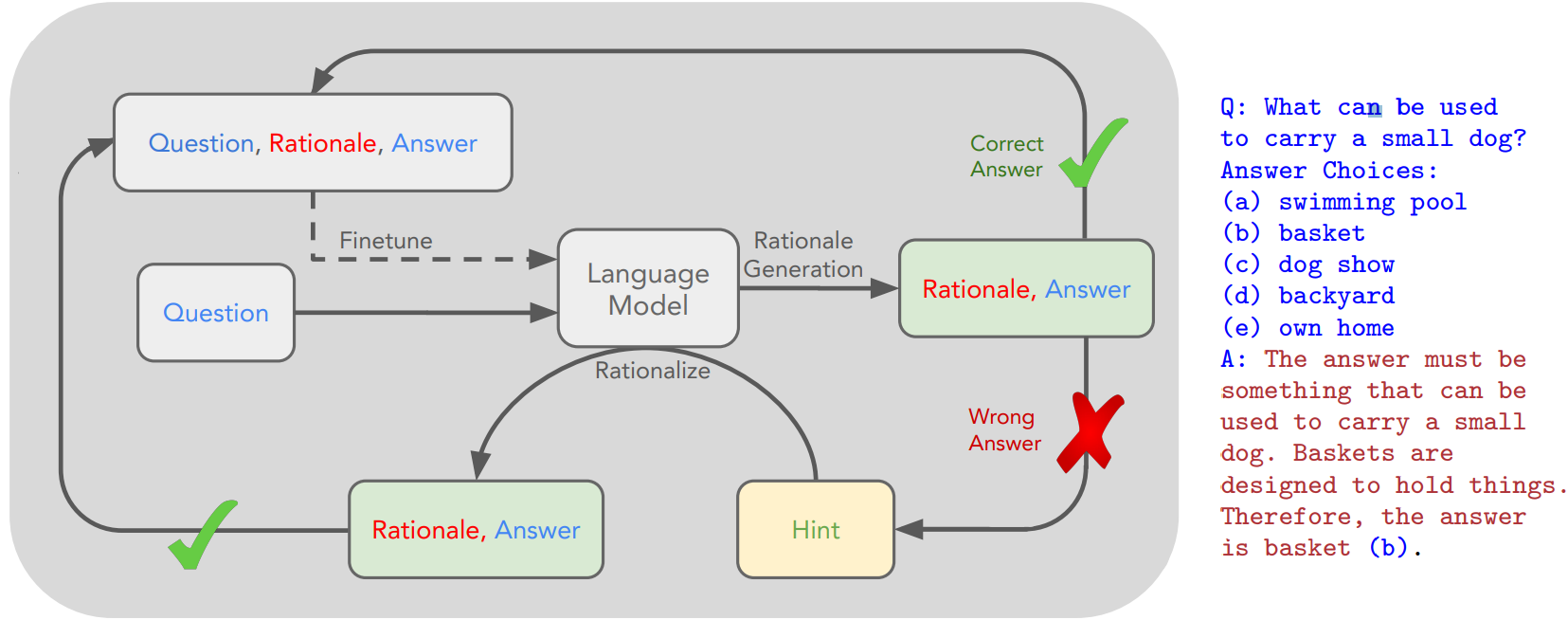

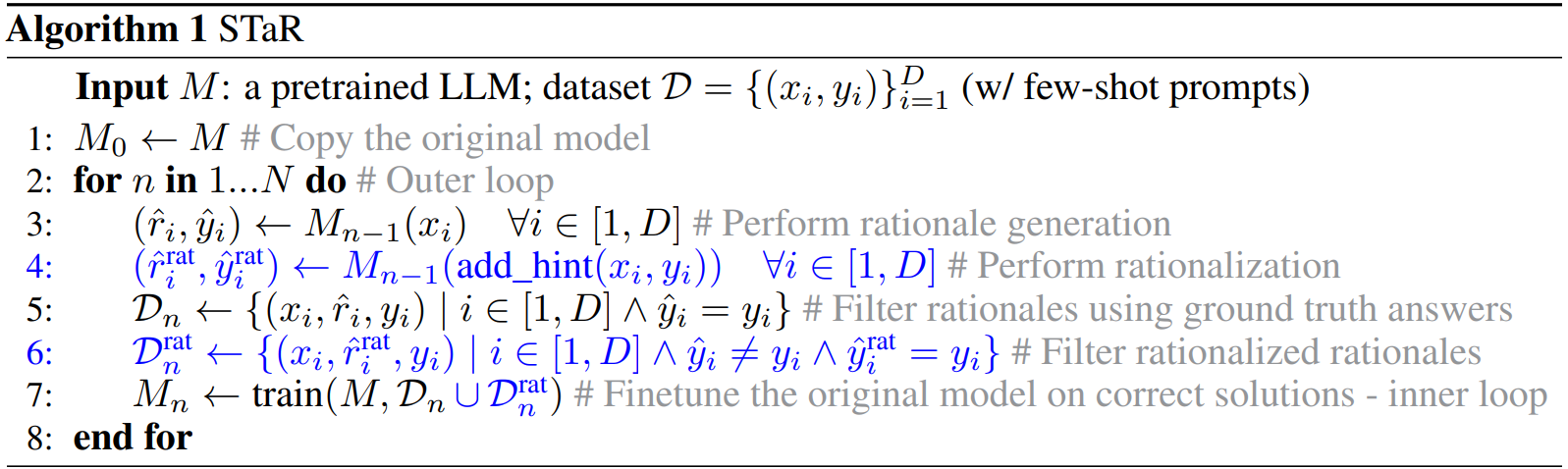

Method

Rationale Generation Bootstrapping (STaR Without Rationalization)

질문과 답변이 있는 초기 데이터셋 D = { X, Y }에 대해 근거 r (rationales)이 있는 예제 prompt set P = {X, R, Y}를 사용하여 in-context learning으로 LLM이 근거와 답변을 출력하도록 한다.

생성된 출력 중 정답을 생성한 출력만으로 새로운 데이터셋 Dn = {X, R, Y}을 구성하고 이 데이터셋으로 모델을 fine-tuning 한다.

이때 주의할 점은 D에 대한 과적합을 피하기 위해 같은 모델을 지속적으로 tuning 하는 것이 아니라 항상 기본 모델에서 재시작한다.

Rationalization

하지만 위와 같이 정답만으로 데이터셋을 구성하면 새로운 문제를 해결할 수 없다. 따라서 '합리화'라는 새로운 방법을 도입한다.

합리화는 다음과 같이 정답을 힌트로 제공하면서 근거와 답변을 생성하도록 한다.

힌트 없이는 정답을 맞히지 못했지만 힌트가 주어졌을 때 정답을 생성한 근거, 답변 쌍을 '힌트 없이' Dn에 추가한다.

합리화는 모델이 틀린 문제를 다시 생각해 보도록 할 수 있으며 데이터셋 크기 또한 증가한다.

'논문 리뷰 > Language Model' 카테고리의 다른 글

| sDPO: Don't Use Your Data All at Once (0) | 2024.04.01 |

|---|---|

| Mini-Gemini: Mining the Potential of Multi-modality Vision Language Models (0) | 2024.04.01 |

| Quiet-STaR: Language Models Can Teach Themselves to Think Before Speaking (0) | 2024.03.27 |

| DoRA: Weight-Decomposed Low-Rank Adaptation (0) | 2024.03.26 |

| LoRA+: Efficient Low Rank Adaptation of Large Models (0) | 2024.03.22 |

| RAFT: Adapting Language Model to Domain Specific RAG (0) | 2024.03.21 |