[arXiv](2024/01/30 version v1)

Introduction

- Text Diffusion과 AR language model 비교

- 고전적인 AR 방법의 관성에서 오는 text diffusion model의 진입 장벽을 낮추기 위해 사전 훈련된 AR 모델을 확산 모델로 변환하는 AR2Diff 방법을 조사

구글 딥마인드 논문이라 기대했는데 별 내용은 없어요.

Experiments

Diffusion implementation

표준 transformer의 사전 훈련된 AR model checkpoint에서 SUNDAE의 훈련 방법을 따르며 L(1:2) loss를 사용한다.

이러한 방법을 AR2Diff 라고 함.

추론 시 저온 샘플링(τ = 0.2) 활용, N(=8) 개의 샘플을 병렬로 디코딩하고 10개의 확산 디코딩 단계를 사용한다.

SUNDAE의 length predictor를 사용하지 않고 훈련 중 padding token을 통해 시퀀스 길이를 예측하도록 함.

Selecting objective and architecture

최종 task에 대한 전문 훈련 대신 대규모 모델을 사전 훈련하고 downstream task에 적용하는 것을 목표로 한다.

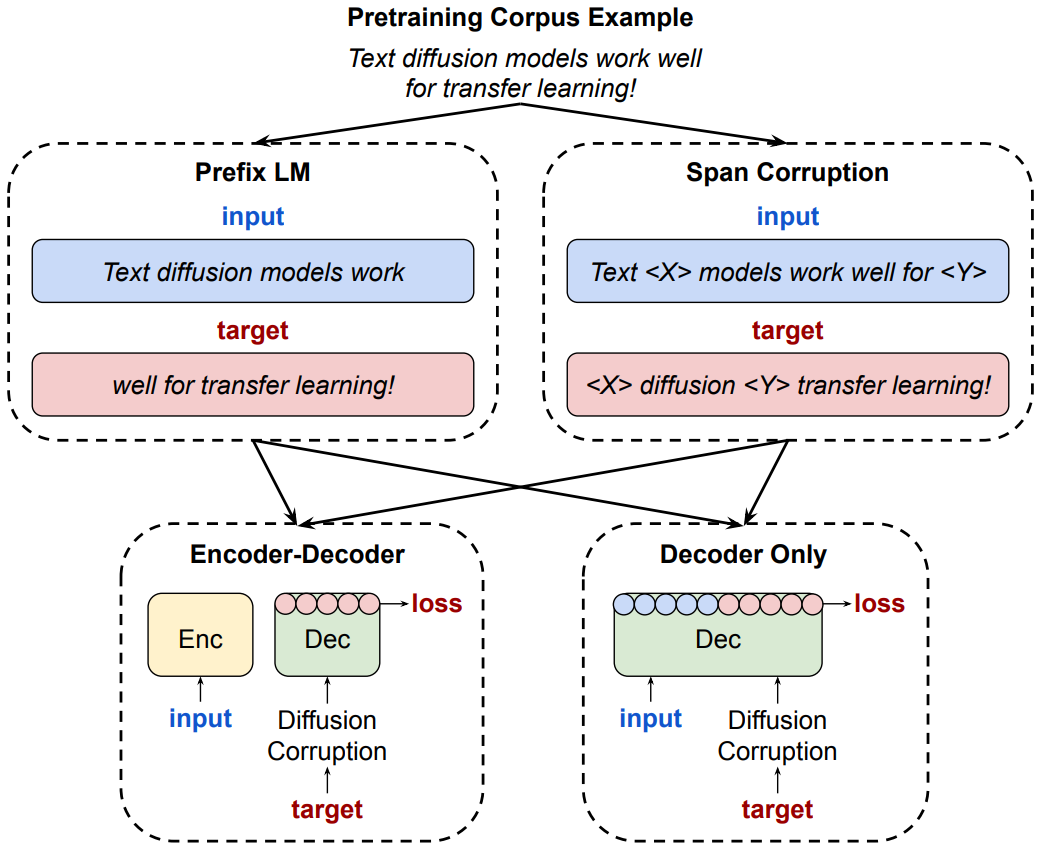

또한 encoder-decoder vs. decoder-only, span corruption vs. prefix LM의 4가지 조합을 모두 테스트하고

모든 모델에서 Decoder-only, Prefix LM의 조합을 선택하였다.

Core results

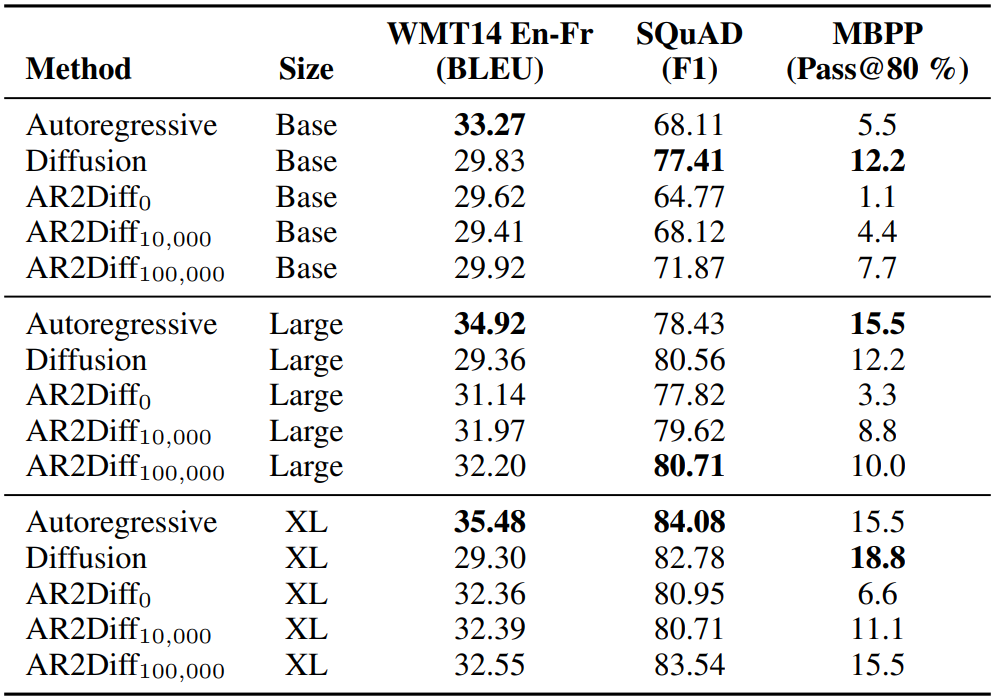

Diffusion model은 SUNDAE, AR model은 그냥 표준 transformer 인 듯?

뭔가 결과가 이렇다고 말하기엔 상당히... 애매한... 결과...?

번역은 AR 미만 잡이고, Diffusion은 코딩(MBPP)에 강점을 보이는 모습?

디코딩 단계와 단계 당 샘플링 수를 늘리면 긴 형식의 코드 합성이 필요한 MBPP가 확실히 향상되지만 QA에는 미미하다.

속도는 Diffusion 쪽이 압도적으로 빠르다.