Temporal attention 없이 cross-frame attention, equivariant fine-tuning만으로 시간적 일관성 향상

[arXiv](Current version v1)

Abstract

30 fps, 4s, 512x384 video를 14초 만에 생성할 수 있는 비디오 편집 확산 모델인 Fairy 제안

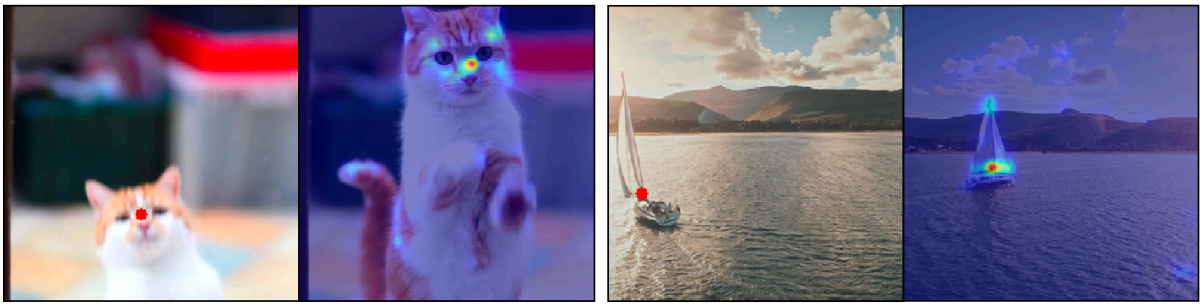

Implicit Tracking via Cross-frame Attention

Cross-frame attention은 시간 대응 추적의 기능이 있다.

특히 고해상도 feature에서.

Fairy: Fast Video-to-Video Synthesis

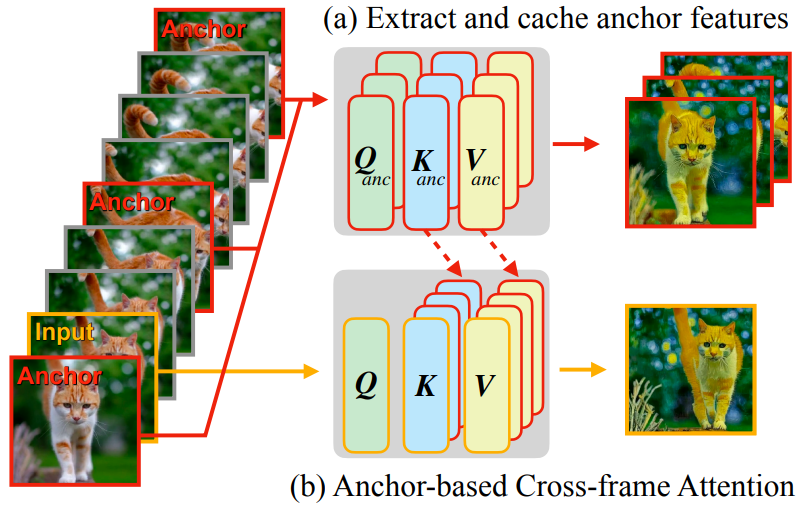

Anchor-Based Model

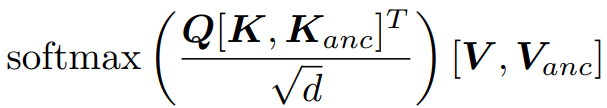

모든 anchor frame의 K, V를 캐시에 추가.

Query frame의 self-attention을 수행할 때 모든 anchor frame의 K, V를 추가한다.

Equivariant Finetuning

여전히 불일치가 관찰되며, 입력과 의미론적 일치가 없는 생성된 content의 경우 입력 프레임의 작은 변화가 상당한 변화를 일으켰다.

Torchvision의 random affine transformation을 사용하여 소량의 rotation, translation, scaling, shear, resize-crop 등이 포함된 affine transformation g()를 샘플링하고 I와 편집된 이미지 I'에서 g(I), g(I')을 얻는다.

그런 다음 모델이 g(I)에서 g(I')을 생성하도록 equivariant fine-tuning 한다. Fine-tuning 후 시간적 일관성이 눈에 띄게 향상되었다고 한다.

Results

이미지 편집 모델에서 temporal attention layer를 사용하지 않고 self-attention만 cross-frame attention으로 대체하였다.

Anchor frame은 균일한 간격으로 3개로 설정.

시간적 다운샘플링 없이 모든 프레임 편집.

10 step Euler First sampler 사용.

fairy-video2video

Project webpage for fairy-video2video

fairy-video2video.github.io