LLaVA에 대한 간단한 수정을 통해 성능 향상

LLaVA도 굉장히 장점이 많은 모델인데 이번 논문도 내용도 핵심만 딱 있어서 간결하고, 제안한 내용도 간단하고 성능 향상은 많이 되고 정말 좋은 논문이다. 다들 논문을 이렇게 써야 하는데...ㅇㅅㅇ

[arXiv]

[Github]

Abstract

LMM(Large Multimodal Model) 중 하나인 LLaVA에 대한 간단한 수정을 통해 성능 향상

Introduction

LLaVA의 장점:

- LLM, vision encoder 사이에 projection layer만을 추가한 매우 간단한 구조

- 단일 8-A100 machine에서 1일 만에 훈련 가능한 매우 빠른 학습 속도

- 공개적으로 사용 가능한 데이터만을 사용

LLaVA-1.5

- MLP cross-modal connector

- VQA와 같은 학문적 작업 관련 데이터를 통합

Improved Baselines of LLaVA

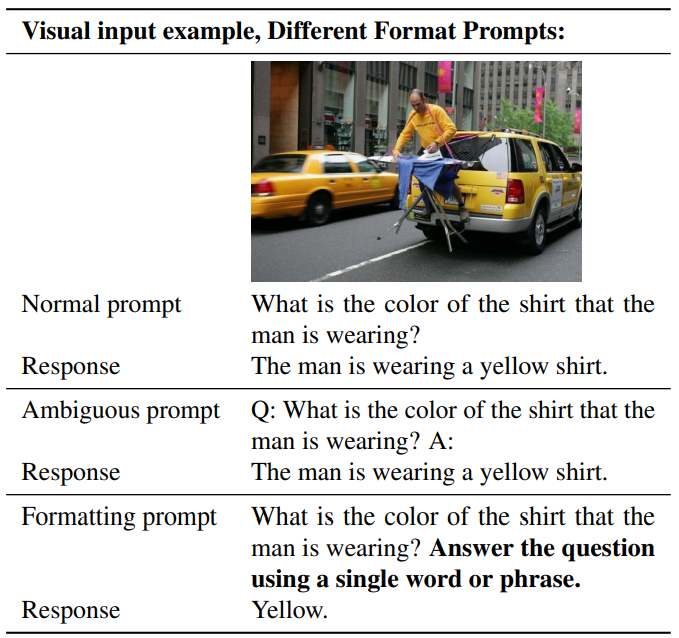

Response formatting prompts

짧은 답변이 필요할 때, VQA 질문 끝에 "단일 단어나 문구를 사용하여 질문에 답변하세요." 문구를 추가.(formatting)

이러한 프롬프트가 포함된 VQA-v2에 대하여 fine-tuning 할 시 성능 향상됨.

MLP vision-language connector

LLaVA의 projection layer를 2계층 MLP로 변경하여 표현력 향상.

Academic task oriented data

InstructBLIP에서 사용되는 데이터셋인 OKVQA/OCR 추가.

또한 Region-level VQA(Visual Genome, RefCOCO) 추가. 세부 정보를 지역화하는 기능이 향상됨.

Additional scaling

- 이미지의 세부 사항을 더 명확하게 볼 수 있도록 입력 이미지의 해상도 확장

- 추가적인 시각적 소스로 GQA 데이터셋 추가

- ShareGPT 데이터셋 추가

- LLM을 13B로 확장

Discussion