LLM의 context 크기를 확장하는 효율적인 fine-tuning 방법

Abstract

제한된 계산 비용으로 LLM의 context 크기를 확장하는 효율적인 fine-tuning 방식인 LongLoRA 제안

Introduction

LoRA는 row-rank update를 사용하여 전체 fine-tuning을 근사화한다.

이와 비슷하게 연구진은 short attention으로 long context에 근사할 수 있다는 것을 발견했고,

이 통찰에 따라 효율적인 shift short attention(S2-Attn) 제안.

그리고 S2 attn을 통해 긴 context를 효율적으로 fine-tuning 할 수 있는 LongLoRA까지.

LongLoRA

Shift Short Attention

Pattern 1 : 그룹 간 정보 교환이 없어 잘 작동하지 않음.

정보 교환을 위해 pattern 2를 추가.

Attention head의 절반씩에 각각의 패턴을 사용함으로써 계산 비용을 늘리지 않음.

(좌하단 네모는 시작 토큰들과 끝 토큰들이 같이 묶임으로써 생김.)

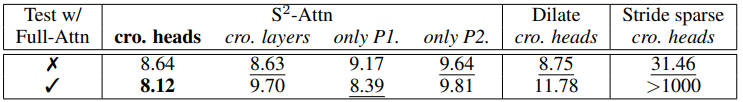

Context 길이를 3만 이상으로 늘렸을 때, 다른 효율적인 attention 방법들과 비교한 위의 표를 보면 cross-head S2-attn으로 fine-tuning 한 모델을 full-attention 환경에서 테스트했을 때(하단) 결과가 가장 좋다.

이는 shifting이 특정 attention 패턴에 과적합 되는 것을 방지해 준다고 볼 수 있다.

Improved LoRA for Long Context

Context 길이를 크게 늘릴수록 full-attention과 LoRA fine-tuning의 격차가 커지는데, 이는 LoRA의 rank를 올린다고 해서 극복할 수 있는 것이 아니다.

격차를 줄이기 위해 임베딩 및 정규화 레이어를 학습 가능하도록 연다.