예제마다 일일이 최적화하지 않고 모델 개인화

Abstract

매번 일일이 fine tuning 할 필요 없이 즉각적인 T2I 모델의 개인화를 가능하게 하는 InstantBooth 제안

Introduction

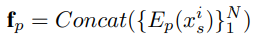

T2I(Text-to-Image) 모델의 개인화는 두 가지로 분류 가능

- 입력 이미지를 텍스트 공간으로 반전

e.g. DreamBooth, Textual-Inversion

단점: 각 예제에 대해 fine tuning 필요, 수정된 모델 가중치를 저장해야 함

- 텍스트 가이드를 통해 I2I 매핑 학습

e.g. InstructPix2Pix, ControlNet

단점: 학습 쌍 데이터 필요

Fine tuning 없는 T2I 모델의 개인화가 목표.

- 최적화 대신 인코더를 학습하여 일반화

- 세부 정보를 위해 어댑터 계층 도입

Method

Overall Framework

Model Architecture Details

Data Pre-Processing

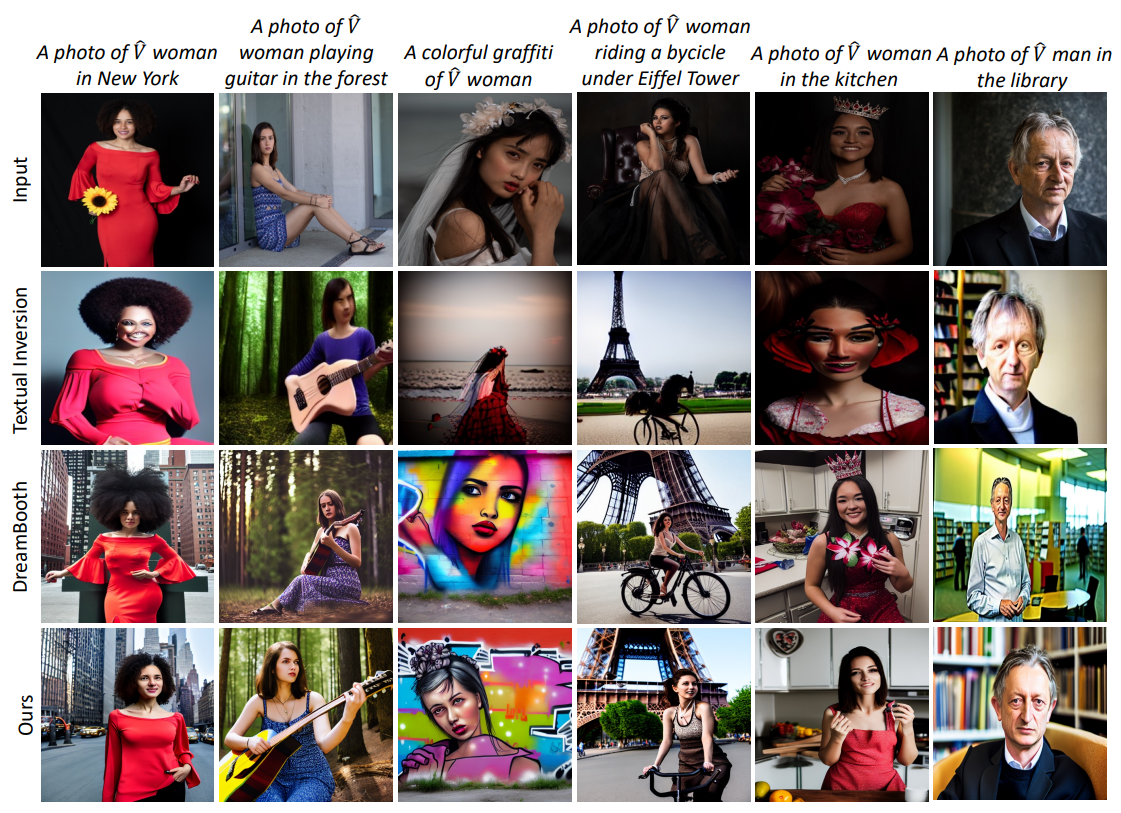

원본 이미지 세트 Xt에 대해 개체 마스킹과 무작위 증강을 적용하여 최종 조건 이미지 세트 Xs을 얻음.

Prompt Creation

수정된 프롬프트 ps 얻음.

A photo of a person playing guitar → A photo of a V̂ person playing guitar

Concept Embedding Learning

이미지 인코더를 통해 조건 이미지의 평균을 feature vector fc로 매핑하고 V̂에 대체.

Rich Representation Learning with Adapters

개념 임베딩은 세부사항을 놓칠 수 있기 때문에 어댑터 도입.

먼저 인코더를 통해 각 이미지에서 visual token을 추출하여 patch feature를 얻고

이전 계층의 출력 y와 합친 후 self attention(γ = 학습 가능 스칼라, β = 상수)

Model Training

xt = ground truth, 학습에서 Xt의 N = 1

손실함수:

Model Inference

Balanced Sampling

β는 학습 중에는 1, 추론에서는 줄임

Concept Token Renormalization

β의 값을 줄여도 때때로 V̂의 영향력이 너무 커질 때가 있음.

따라서 concept token fc를 재정규화.

Experiments

Ablation