추가 학습이나 최적화 과정 없이 T2I 모델로 비디오 생성

Abstract

Zero-shot text-to-video 생성을 소개하고 기존의 T2I 합성 방법을 이용한 저비용 접근 방식 제안.

비디오 데이터에 대한 추가 학습 없이도 기존 T2V와 비슷한 성능을 보여줌.

Instruct-Pix2Pix와 같은 다른 편집 작업에도 적용할 수 있음.

Introduction

본 논문에서는 최적화나 미세 조정 없이 T2V를 가능하게 하는 zero-shot “training-free” text-to-video를 연구한다.

시간적 일관성을 위한 수정 사항

- Global scene과 background의 일관성을 위해 모션 정보로 생성된 프레임의 잠재 코드를 풍부하게 함

- Foreground 개체의 context 및 정체성을 보존하기 위해 첫 번째 프레임에서 cross-frame attention 사용

Method

Stable Diffusion

DDPM, DDIM 설명 영상 (레전드)

LDM (=Stable Diffusion=SD)

Zero-Shot Text-to-Video Problem Formulation

Zero-shot text-to-video synthesis 정의 :

텍스트 τ와 정수 m에 대해 비디오 프레임 V(m*H*W*3)를 출력하는 함수 F를 설계하는 것.

Method

각 posterior에서 m개씩 샘플링하는 방법은 일관성이 없음.

해결책으로

- 잠재 코드에 motion dynamics를 도입

- Cross-frame attention 도입

표기단순화

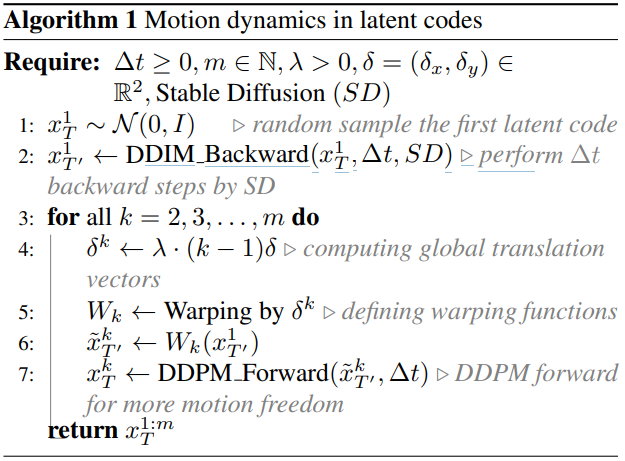

Motion Dynamics in Latent Codes

다음의 단계를 수행하여 코드를 구성

- 첫 번째 프레임의 잠재 코드 xT1 샘플링

- ∆t 만큼 DDIM 역방향 단계를 수행하여 xT'1 얻음 (xT1은 noise이기 때문에 윤곽을 잡는 역할)

- Global scene과 모션을 위한 방향 δ 정의

- 각 프레임 k에 대해 translation vector δk 계산

- δk를 반영하여 x̃T'1 얻음

- x̃T'1에 DDPM 순방향 단계를 수행하여 잠재 코드 xTk 얻음

최종적으로 얻은 xT1:m을 시작점으로 사용함.

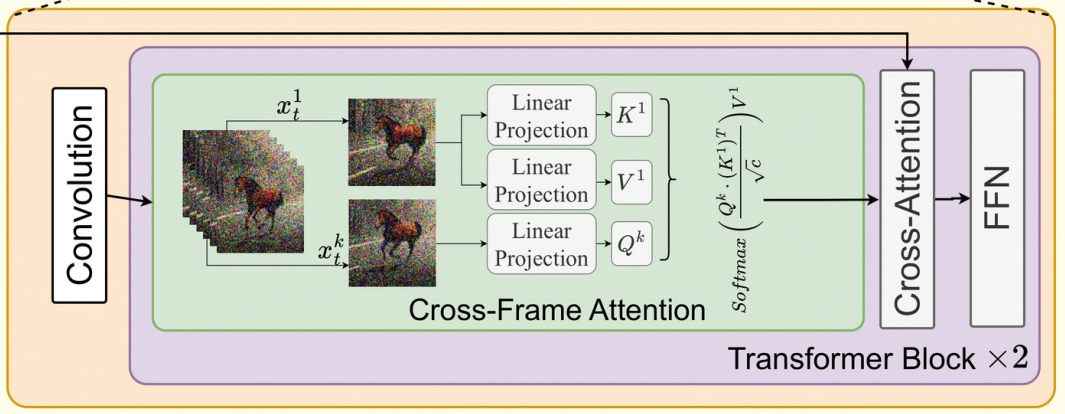

Reprogramming Cross-Frame Attention

원래 SD의 self attention은 입력 x를 Q, K, V로 선형 투영하여 진행된다.

Self attention layer를 cross frame attention으로 교체하는데, m개 프레임을 입력으로 받고 다음과 같이 계산함.

Ablation Study

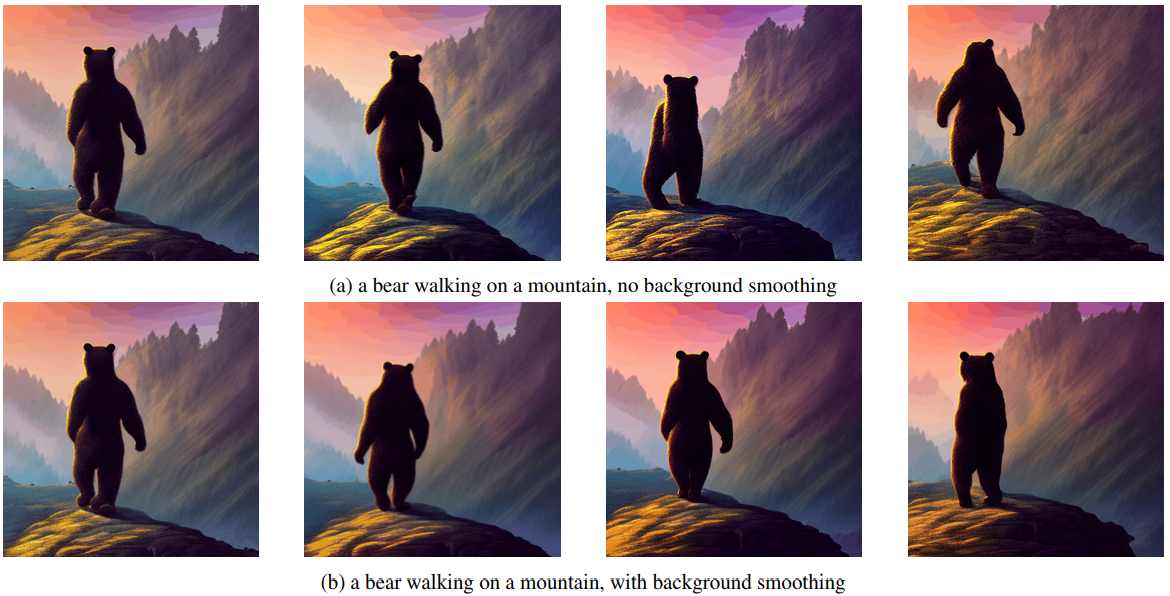

Background smoothing (Optional)

첫 번째 프레임과 k 프레임 사이의 background-masked latent code의 convex combination을 사용하여 배경의 시간적 일관성을 더욱 향상한다. 초기 이미지나 가이드가 제공되지 않을 때 특히 유용.

프레임 k에서 detection 모델로 foreground mask를 얻고

xt1에 위에서 정의한 모션 적용 함수 Wk를 적용하여 x̂tk를 얻는다.

실제 잠재 코드 xtk와 모션 계산으로 얻은 잠재 코드 x̂tk의 조합으로 배경을 얻음.

(α는 계수, 최종적으로 DDIM 샘플링을 하여 완성함.)

Conditional and Specialized Text-to-Video

ControlNet 적용.

수정된 U-Net 모델을 ControlNet에서도 그대로 복사하여 쓰고 딱히 변경사항은 없는 듯...?

Video Instruct-Pix2Pix

Instruct-Pix2Pix는 비디오가 아닌 T2I를 위한 편집 방법이지만 Text2Video-Zero에서는 추가 학습이 필요하지 않으므로 적용 가능.

Experiments

추가적인 학습이나 데이터가 필요하지 않은 게 새로운 점이고 성능은 기존 확산 기반 T2V 모델들과 비슷함.

더 많은 실험 결과는 Project page로