InstructPix2Pix

We propose a method for editing images from human instructions: given an input image and a written instruction that tells the model what to do, our model follows these instructions to edit the image. To obtain training data for this problem, we combine the

www.timothybrooks.com

Abstract

언어 모델, text-to-image 확산 모델을 이용해 finetuning, inversion 없이 이미지를 편집하는 InstructPix2Pix

Method

Generating Instructions and Paired Captions

LAION-Aesthetics 데이터셋에서 700개의 캡션을 샘플링하고 edit instruction, output caption을 인간이 수동으로 작성

해당 데이터셋으로 GPT-3 Davinci 모델을 single epoch finetuning 하여 캡션 입력 시 그럴듯한 instruction과 caption을 출력하도록 했다.

연구진은 불필요한 noise caption이 많은데도 불구하고 다양성 때문에 LAION 데이터셋을 선택했다. 이 단점은 뒤에 소개할 방법으로 완화함.

Generating Paired Images from Paired Captions

Prompt-to-Prompt를 이용해 캡션 쌍에서 이미지 쌍 생성

Prompt-to-Prompt에는 구조 변화가 큰 변형에 대해 샘플링의 몇 번째 단계에서 변형을 적용할지 지정하는 매개변수 p가 있다.

StyleGAN-NADA 논문의 CLIP 방향 유사성 metric으로 랜덤 p에 대해 최적의 샘플을 필터링한다.

InstructPix2Pix

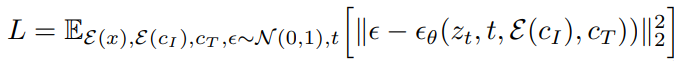

조건 이미지 cI, text instruction cT에 대해 stable diffusion model을 최적화

(E()는 stable diffusion의 인코더)

첫 번째 컨볼루션 레이어에서 cI를 주입하고 추가된 피라미터의 가중치는 0으로 하고 사전 훈련된 stable diffusion의 checkpoint에서 훈련 시작.

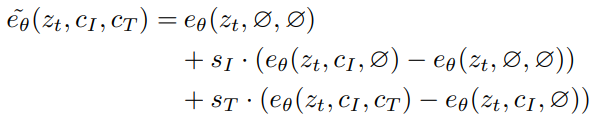

Classifier-free Guidance for Two Conditionings

InstructP2P에서는 두 개의 조건을 받기 때문에 (cI, ∅) 5%, (∅, cT) 5%, (∅, ∅) 5%로 훈련 진행, 샘플링은 다음과 같음 :

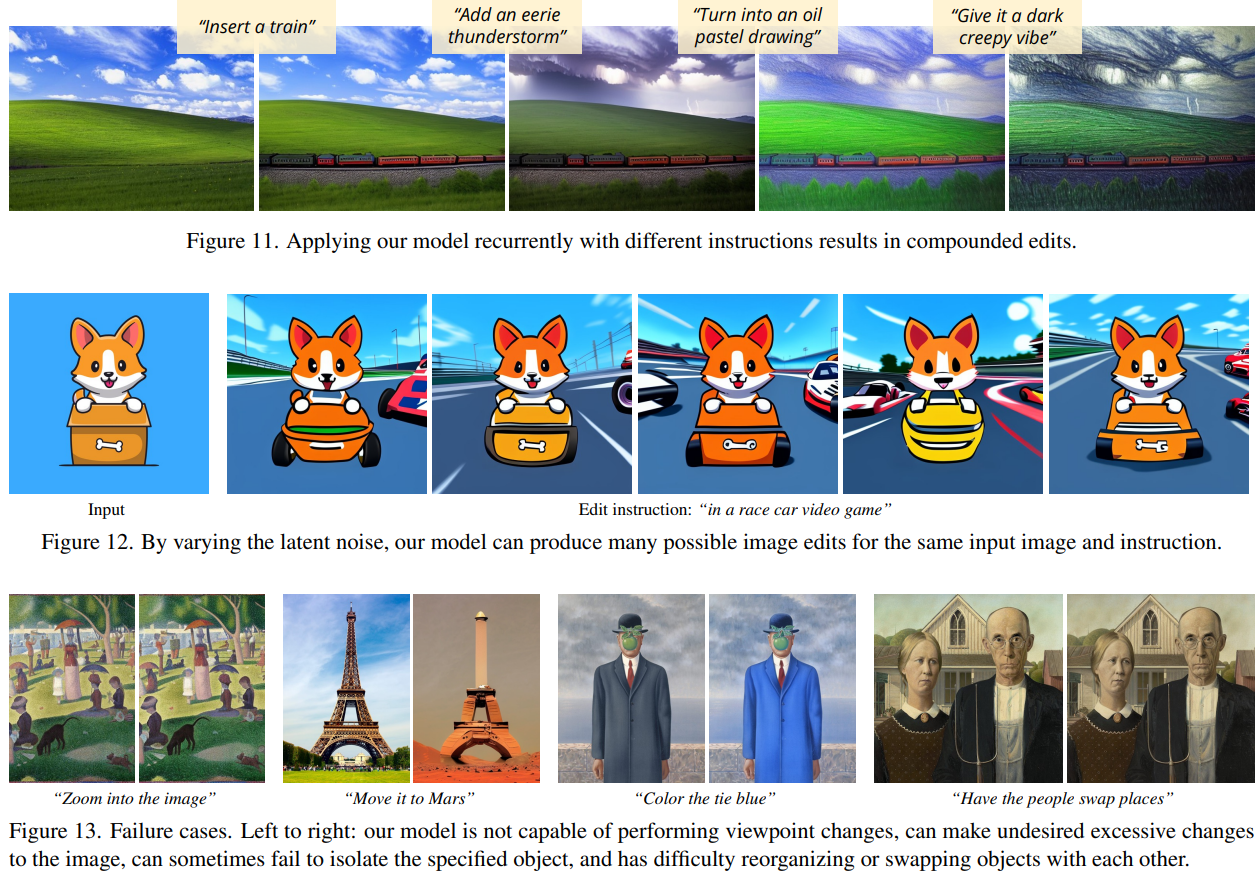

Results