사전 훈련 T2I 모델로 비디오 생성

Tune-A-Video: One-Shot Tuning of Image Diffusion Models for Text-to-Video Generation

A new method for text-to-video generation using one text-video pair.

tuneavideo.github.io

Abstract

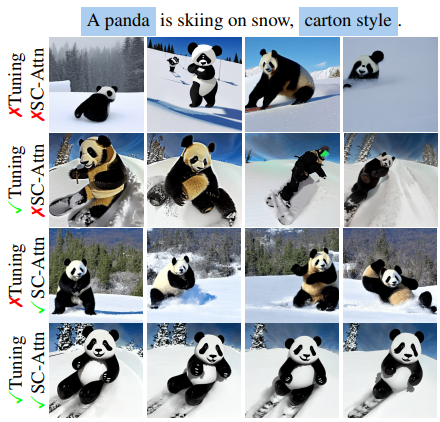

사전 훈련된 Text-to-Image(T2I) 확산 모델의 튜닝을 통해 text prompt에서 비디오를 생성하는 Sparse-Causal Attention이 있는 Tune-A-Video(TAV) 제안

Introduction

T2I 모델의 self attention을 여러 이미지로 확장하는 것만으로 프레임 간에 콘텐츠 일관성이 유지된다. 이는 T2I 모델의 self attention이 픽셀 위치보다는 공간적 유사성에 의해서 작동된다는 것을 의미한다.

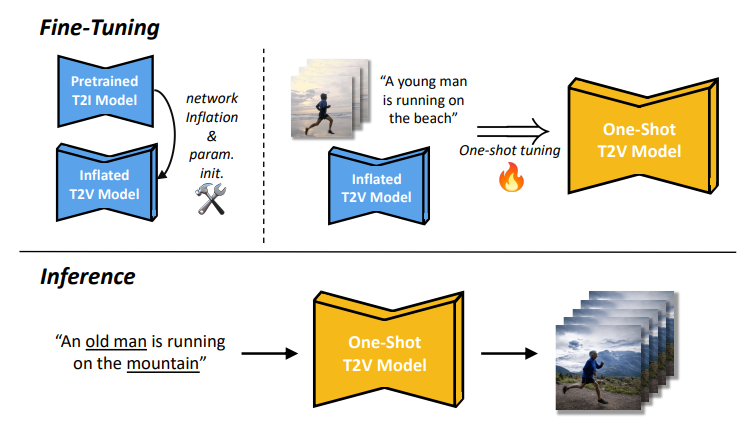

TAV는 3x3 컨볼루션을 1x3x3으로 대체하고 spatial self-attention을 시공간으로 확장한 T2I 모델의 간단한 inflation을 기반으로 한다. 다른 피라미터는 동결하고 attention block의 projection matrix만 업데이트하는 효율적인 튜닝 전략 제안.

시공간으로의 확장은 계산비용의 기하급수적인 증가로 이어지는데, 계산 복잡성을 줄이기 위해 Sparse Causal Attention (SC-Attn)을 제안한다.

Method

Preliminary: Diffusion Models

Latent Diffusion(LDM)

One-Shot Video Generation

m 프레임이 있는 비디오 V가 설명 T와 함께 주어지면,

T와 같은 동사를 공유하는 text prompt T̂과 사전 훈련된 T2I 모델 M을 통해 새로운 비디오 V̂을 생성한다.

Our Tune-A-Video

Network Inflation

먼저 Video Diffusion Model에 따라 3x3 컨볼루션을 1x3x3 컨볼루션으로 대체하고 기존의 spatial self-attention 이후에 시간축에 대한 temporal self-attention 추가.

Sparse-Causal Attention

더 나은 시간적 일관성을 위해 spatial self-attention을 시공간으로 확장.

Spatial self-attention의 대안 중 full은 너무 연산량이 많고, causal 또한 가장 큰 시퀀스를 수용해야 하기 때문에 계산 부담이 크다.

SC-attention에서는 첫 번째 프레임과 바로 직전 프레임만을 참조한다.

첫 번째 프레임에 대한 쿼리는 전역 일관성을 학습하고 직전 프레임에 대한 쿼리는 연속 프레임 간에 필요한 동작을 학습한다.

또한 SC-attention은 자기회귀적인 특성으로 긴 비디오 시퀀스의 생성을 가능하게 한다.

One-Shot Tuning

SC-attention은 프레임 vi에서 이전 프레임으로의 단방향 매핑이고, 이전 프레임에서 파생된 key와 value는 vi의 출력에 독립적이기 때문에 Wk, Wv는 고정하고 Wq만 업데이트한다.

비디오와 텍스트 간의 정렬을 개선하기 위해 cross attention의 query projection도 업데이트.

결과적으로 attention block만을 finetuning하여 계산적으로 효율적이고 T2I 모델의 훌륭한 사전 지식까지 활용할 수 있다.

Experiments