여러 확산 과정을 혼합하여 이미지 생성

Abstract

캔버스의 서로 다른 영역에 작용하는 여러 확산 과정을 조화시킴으로써 더 큰 이미지를 생성할 수 있는 Mixture of Diffusers 알고리즘 제안

Introduction

일반적인 확산 모델은 다음과 같은 프롬프트를 잘 나타내지 못하며, 위치가 무시된다.

또한 큰 이미지를 생성하는 데에 기하급수적으로 컴퓨팅 비용이 증가함.

Mixture of Diffusers는 여러 확산 과정을 혼합하여 위 문제들을 해결한다.

Mixture of Diffusers의 이점:

- 특정 위치에서 개체를 생성하거나 스타일 사이의 공간에 부드러운 전환을 도입할 수 있음

- 각 확산 과정이 동일한 신경망을 공유하기 때문에 적은 메모리로 고해상도 이미지 생성 가능

- 이미지 아웃페인팅 가능

- 사전 훈련된 확산 모델 사용 가능

Mixture of Diffusers

Method description

핵심 아이디어는 각 이미지 영역 ri에 대해 xt, ri를 각각 예측하는 모델 ε̂θi를 사용하는 것이다.

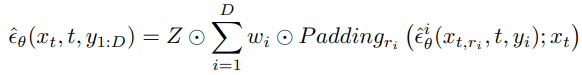

예측은 다음과 같이 생성되며.

Paddingri는 xt와 크기가 같으면서 해당 영역 ri를 제외하고 0으로 채워진 텐서를 생성하는 연산,

wi는 각 영역의 혼합 가중치, Z는 정규화 기능이다.

알고리즘:

메모리가 충분하다면 여러 신경망을 사용해도 상관없음.

각 영역이 겹치지 않을 때:

각 영역이 일부 겹칠 때: 일부 아티팩트가 생김

각 영역 내부에서 가우시안 가중치를 사용할 때: 부드럽게 생성됨

Adaption to latent spaces

위의 방법은 픽셀에서 작동하는 확산 모델에는 적용될 수 있지만 잠재 공간에서 작동하는 Stable Diffusion과 같은 LDM 모델에는 적용할 수 없다.

잠재 공간의 단일 위치가 픽셀 공간의 모든 값에 영향을 미칠 수 있으므로 각 모델은 전체 잠재 공간을 처리해야 하기 때문이다.

따라서 잠재 공간의 각 위치가 픽셀 공간의 UxU(디코더의 업스케일링 수치) 영역을 생성한다는 대략적인 매핑을 가정하여 픽셀 공간에서 U를 나누는 것으로 잠재 공간의 영역을 찾는다.

또한 U-Net에는 self attention이 있어 특정 픽셀이 다른 영역에 영향을 미칠 수 있는데, 딱히 문제는 없다고 한다?

Experiments

Hugging Face의 diffusers library로 구현

Stable Diffusion 1.4v

Image composition

High resolution image generation

1408x896 이미지

4K 이미지

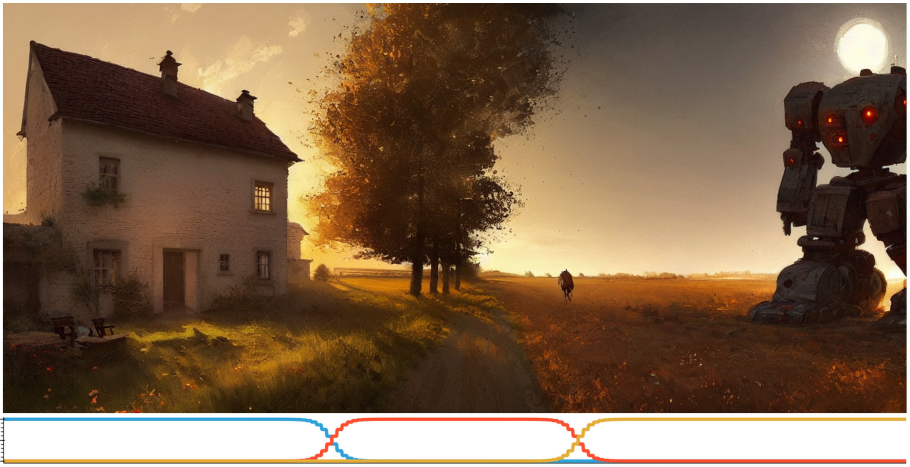

Smooth style transitioning

스타일만 다른 프롬프트를 사용하여 다음과 같은 이미지 생성 가능.

스타일당 2개의 영역을 할당하여 더 자연스러운 전환 표현.

Conditioning on images

SDEdit에서는 안내 이미지 x(gi), 안내 강도 t(gi)를 활용하여 안내 이미지와 노이즈를 혼합하고 해당 이미지를 xt로 확산 과정 중간부터 denoising을 실행할 수 있다.

Mixture of Diffusers에서는 안내 영역 I(gi)를 추가하여 t시점에서 t > t(gi)일 경우 해당 영역의 이미지를 안내 이미지로 대체하는 컨디셔닝 방법 사용.

해당 컨디셔닝 방법을 이용하여 고해상도 이미지를 생성할 때 각 영역의 일관성을 강화하는 방법으로도 사용할 수 있다.