분해-재구성 단계를 통해 다양한 컨디셔닝에 적응

Abstract

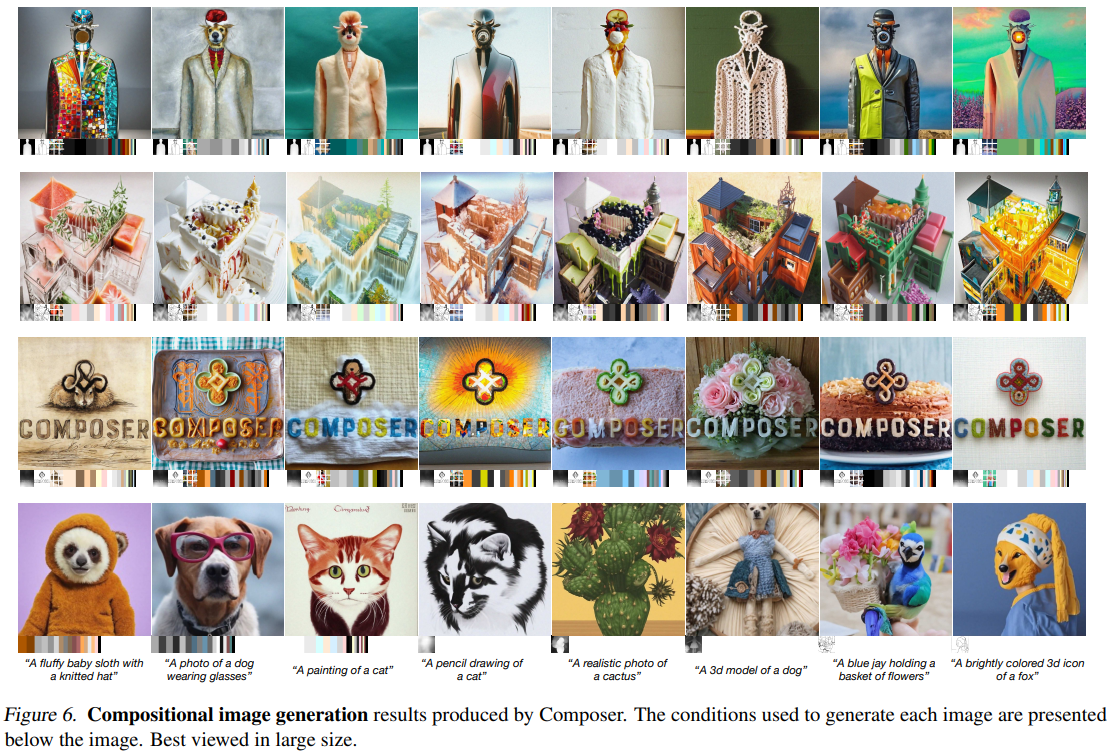

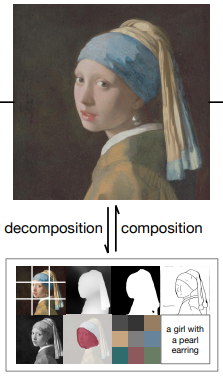

먼저 이미지를 대표 요소로 분해한 다음 이 모든 요소를 조건으로 하여 입력을 재구성하는 확산 모델을 훈련하여 출력 이미지를 유연하게 제어할 수 있는 차세대 패러다임인 Composer 제안

Introduction

연구진은 제어 가능한 이미지 생성의 핵심이 컨디셔닝뿐만 아니라 compositionality에 더 의존한다고 주장한다. (잠재적으로 무한한 수의 새로운 조합을 인식하고 생성)

Compositional generative model이란 시각적 구성 요소를 매끄럽게 재결합하여 새로운 이미지를 생성할 수 있는 생성 모델을 말한다.

Composer는 U-Net 백본의 확산 모델로 구현되며 학습에는 decomposition, composition 두 단계가 있고 잠재적으로 서로 호환되지 않을 수 있는 보이지 않는 표현 조합에서 새로운 이미지를 디코딩할 수 있다.

Composer는 개념적으로 간단하고 구현하기 쉬우며 다양한 이미지 작업에서 강력한 성능을 보여준다.

Method

Diffusion Models

Composer는 여러 조건을 수용하는 확산 모델로써 classifier-free guidance와 유사한 방식으로 안내된다.

c1과 c2는 각각 다른 조건인데, c1을 이용하여 x0을 xT로 뒤집은 다음 c2를 사용하여 xT에서 샘플링함으로써 이미지를 disentangle한 방식으로 조작할 수 있다.

조작 방향은 c1과 c2의 차이로 정의된다.

Decomposition

각각의 사전 훈련 모델을 통해 이미지를 훈련 중에 즉석으로 분해한다.

- Sematics and style

- Depth map

- Masking

- Sketch

- Intensity

- Instances

- Color

- Caption

Composition

이미지를 재구성하기 위해 GLIDE 아키텍처를 사용하며 두 가지의 컨디셔닝 매커니즘을 탐색:

Global conditioning

문장 임베딩, 색상 팔레트 등 글로벌 표현의 경우 cross attention을 위한 context로 사용

Localized conditioning

Sketch, mask, depth map 등 지역화된 표현의 경우 xt와 동일한 크기로 투영하고 U-Net에 공급하기 전에 연결

훈련 중에 각 조건에 대해 드롭아웃 0.5, 모든 조건 삭제 0.1, 모든 조건 유지 0.1 적용

출력 이미지는 64x64고 업스케일링을 위해 추가적으로 무조건 확산 모델을 훈련한다.

(Stable Diffusion 시대에 이게 맞나...)

Experiments