여러 확산 과정을 최적화를 통해 한 장의 이미지로 통합

Abstract

추가 훈련 없이 사전 훈련된 text-to-image 확산 모델을 사용하여 다재다능하고 제어 가능한 이미지 생성을 가능하게 하는 통합 프레임워크인 MultiDiffusion 제안

Introduction

사전 훈련된 참조 확산 모델은 이미지의 서로 다른 영역에 적용되고 MultiDiffusion은 최소 제곱 최적화를 통해 global denoising sampling step을 수행한다.

또한 계산 오버헤드 적음.

Method

점진적으로 이미지를 IT → I0으로 denoising 하는 사전 훈련된 참조 확산 모델

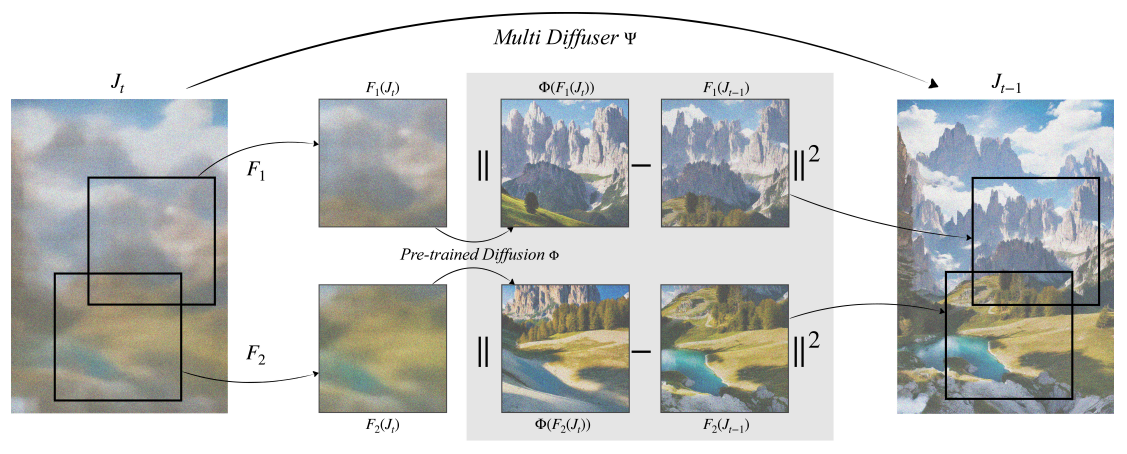

MultiDiffusion

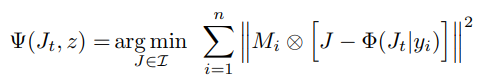

MultiDiffusion은 image space J와 condition space z에 대해 다음을 수행

핵심 아이디어는 Ψ를 Φ와 가능한 한 일치하도록 정의하는 것이다.

구체적으로 두 매핑 세트를 정의하고

다음과 같이 Jt를 최적화

(W는 픽셀별 가중치)

Closed-form formula

영역이 겹친 부분은 가중 평균을 구하여 최적화

Properties of MultiDiffusion

다음과 같은 확률 분포 PJ를 선택하고

J를 최적화하여 LFTD = 0에 도달하면 다음과 같고

결국에 모든 단계(T ~ 0)에서 최적화되면 Fi(J0)은 참조 확산 모델의 단일 역확산 결과인 I0i와 완전히 동일하게 된다.

이 명제는 매우 중요한데, 단일 참조 확산 과정을 다양한 이미지 생성 시나리오에 유연하게 적응시킬 수 있다는 말이 된다.

Applications

Panorama

Wi = 1.

y = z 이기 때문에

Region-based text-to-image-generation

영역 마스크 세트 {Mi}, 프롬프트 세트 {yi}가 주어지면

Fidelity to tight masks

Tight mask에 대한 추가 지원으로 매핑 Fi에 시간 종속성을 통합하여 bootstrapping 단계 도입.

(St는 배경으로 사용될 단일 색상 이미지)

생성 이미지의 레이아웃은 초기에 대부분 결정되므로 확산 과정의 초기에 마스크에 해당하는 픽셀만 최적화되도록 함.

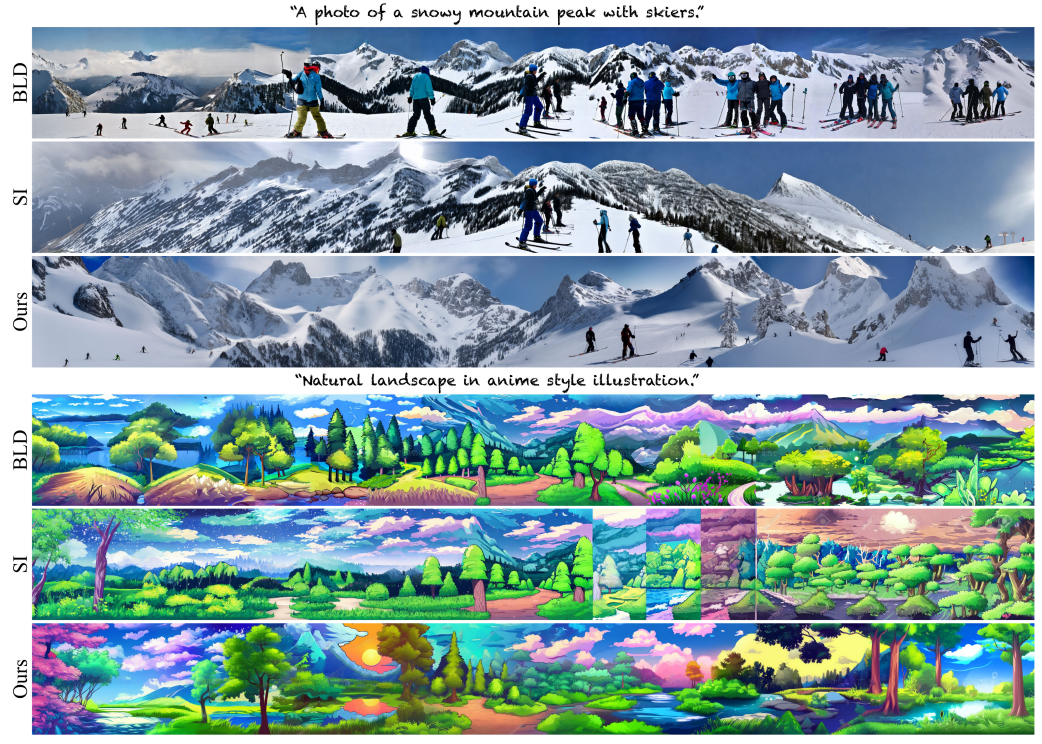

Results