Abstract

참조 이미지에서 content와 style을 분리하고 style attention block에만 주입.

[Github]

[arXiv](2024/04/03 version v1)

Methods

Motivations

1. 스타일의 정의가 모호하다. 같은 스타일의 데이터를 수집하는 것은 불가능에 가깝다.

2. Inversion을 사용하면 스타일 정보를 잃게 된다.

3. Content와 style 간의 균형을 잡기가 어려워 content 누출 문제가 발생한다.

Observations

1. Adapter의 기능이 과소평가되었다.

IP-Adapter로도 강도를 낮추면 content 누출을 줄이고 style을 전달할 수 있다.

2. CLIP feature space는 호환성이 좋으며 특정한 feature를 더하거나 뺄 수 있다.

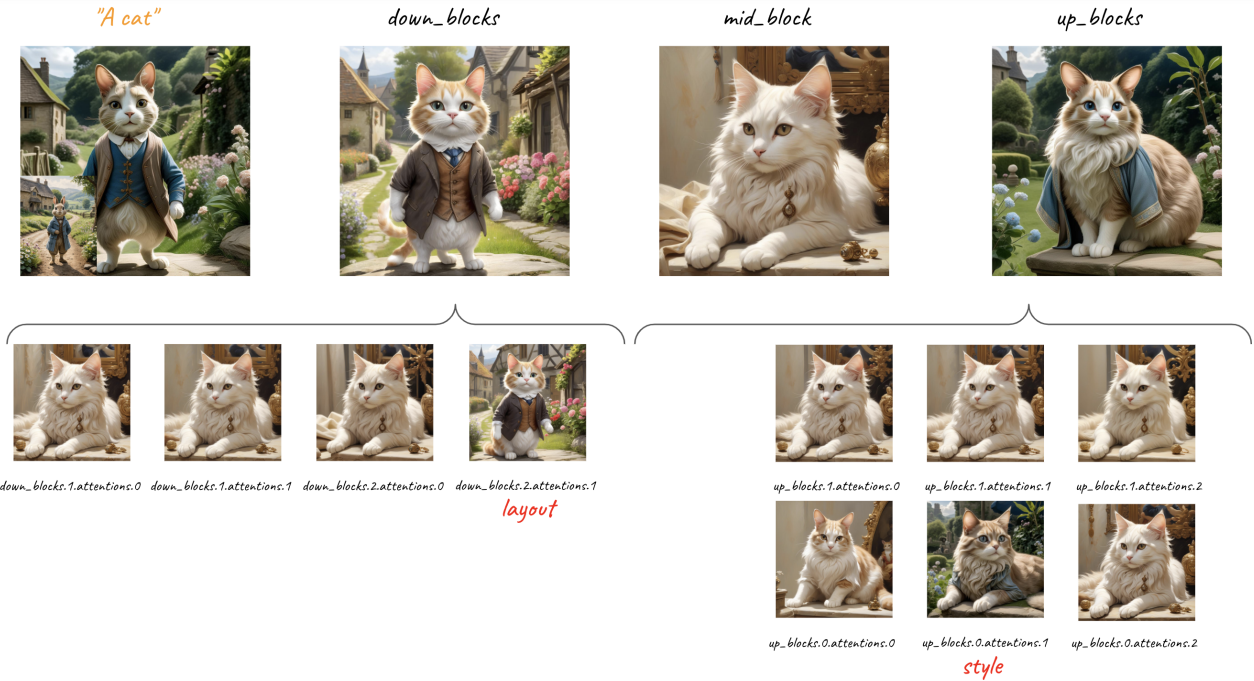

3. 출력에 대한 각 U-Net block의 영향은 동일하지 않다.

IP-Adapter에 대한 실험을 수행하여 각 attention layer의 효과 분석.

Methodology

1. 이미지에서 content 분리.

Style과 달리 content는 명확한 텍스트로 표현될 수 있으며 CLIP text encoder로 추출할 수 있다.

IP-Adapter와 마찬가지로 CLIP image encoder를 통해 참조 이미지의 feature 또한 추출한다.

Image feature - content text feature = style feature

여러 개체가 있는 경우에 각 개체에 대한 content feature를 다 빼면 똑같이 가능한가?

2. Style attention block에 style feature를 주입.

Experiments

실험은 사전 훈련된 SDXL + IP-Adapter로 진행됨.

다른 방법과 비교하면 content 누출은 ㄹㅇ 없긴 함.

참조 이미지를 content로 사용하려면 ControlNet과 같은 추가 어댑터가 필요하다.

Ablation