[Github]

[arXiv](2020/10/21 version v3)

Abstract

N-stream self-attention을 통해 미래 n-gram을 예측하는 sequence-to-sequence model인 ProphetNet 제안

ProphetNet

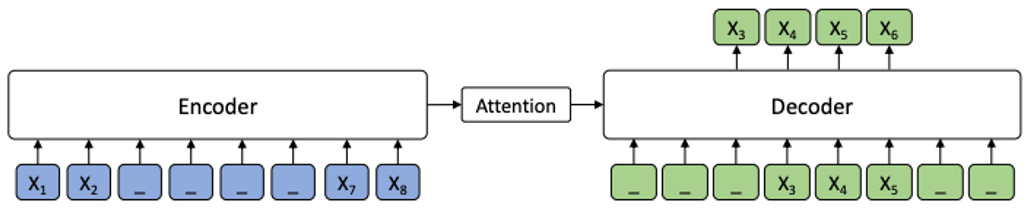

Future N-gram Prediction

일반적인 다음 토큰 예측을 미래의 N개의 토큰을 동시에 예측하는 목표로 변경한다.

N-Stream Self-Attention

Main stream

일반적인 MHA, k번째 레이어의 hidden state에 속한 이전 토큰과 attention을 수행. (a)

1-st predicting stream

2-nd predicting stream

yt 예측을 위한 gt-1 계산과 yt+1 예측을 위한 st-1 계산은 매우 유사하지만 각 초기화 토큰, 절대, 상대 위치 임베딩으로 구별된다.

또한 각 stream은 피라미터를 공유한다.

Seq2Seq Pre-training on Denoising Task

마스크 된 토큰을 복구하는 MASS의 학습 목표를 사용한다.