[arXiv](2024/02/15 version v1)

Abstract

Self-Play Fine-Tuning (SPIN)을 확산 모델에 적용한 SPIN-Diffusion 제안

Problem Setting and Preliminaries

Text-to-Image Diffusion Model

Self-Play Fine-Tuning (SPIN)

Method

SPIN을 확산 모델에 그대로 적용하는 것에는 한 가지 문제가 있다. LLM에서는 확률 pθ(x0|c)를 얻기 쉽지만, 확산 모델에서는 모든 timestep의 궤적을 계산해야 하므로 다루기 어렵다.

Differentiating Diffusion Processes

Self-play와 같은 최소화 목표로 시작.

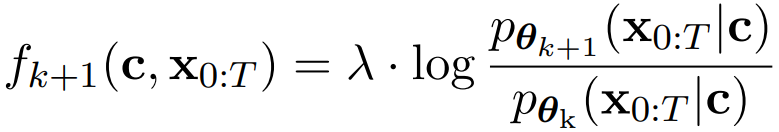

Deceiving the Test Function

Decomposed Training Objective

손실 함수. 여기까지는 self-play와 똑같음.

가우시안 분포의 로그 확률 밀도 함수는 다음과 같이 표현할 수 있고

Timestep T에서의 분포는 조건 c와는 독립적인 분포이므로 최종적으로 다음과 같은 식을 도출할 수 있다.

노이즈의 분산은 β로 피라미터화되고

위에서 도출한 식을 self-play의 손실 함수에 대입하면:

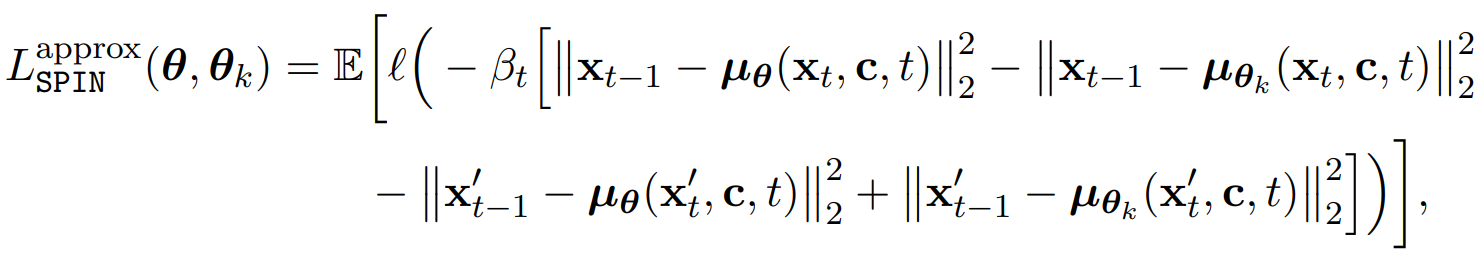

Approximate Training Objective

메모리를 줄이기 위해 모든 timestep에 대해 계산하지 않고 하나의 step에 대해서만 계산하는 근사적인 목표를 사용할 수도 있다.

이는 원래 손실의 상한이기 때문에 (논문 부록 B 참고)

이를 최소화하는 것은 원래 손실을 최소화하는 것과 같다.

Function l은 convex function이면서 단조 감소하는 여러 가지 함수를 사용할 수 있다.

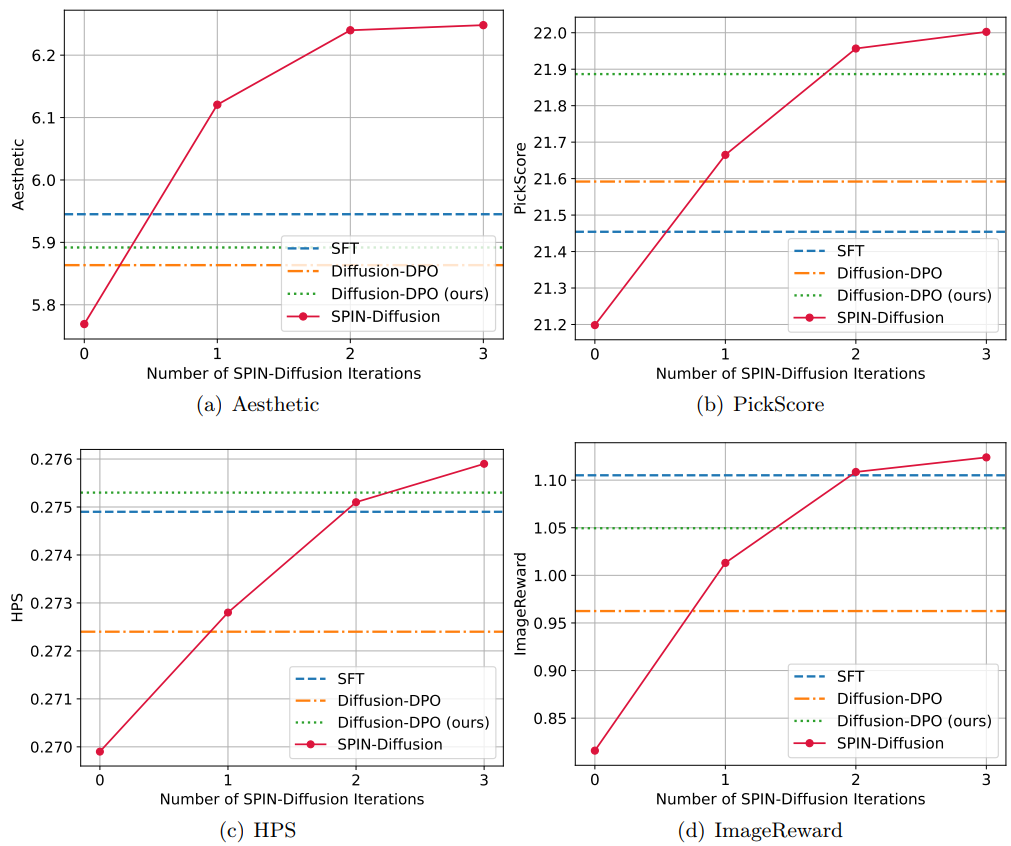

Experiments

'논문 리뷰 > Diffusion Model' 카테고리의 다른 글

| Multi-LoRA Composition for Image Generation (3) | 2024.03.08 |

|---|---|

| SDXL-Lightning: Progressive Adversarial Diffusion Distillation (3) | 2024.03.06 |

| Neural Network Diffusion (3) | 2024.03.05 |

| Training-Free Consistent Text-to-Image Generation (ConsiStory) (0) | 2024.02.19 |

| Boximator: Generating Rich and Controllable Motions for Video Synthesis (2) | 2024.02.14 |

| Emu Edit: Precise Image Editing via Recognition and Generation Tasks (0) | 2024.02.14 |