[arXiv](2024/02/05 version v1)

Abstract

사전 훈련된 모델의 내부 활성화를 공유하여 일관된 subject 생성을 가능하게 하는 훈련 없는 접근 방식인 ConsiStory 제안

Method

- Subject-driven self-attention

- Enriching layout diversity

- Feature injection

- Anchor images and reusable subjects

- Multi-subject consistent generation

Subject-driven self-attention

모든 diffusion timestep과 32x32 해상도의 모든 cross-attention layer에서 attention map을 수집하고 임계값을 적용하여 subject mask를 얻는다.

배치 내의 모든 K, V를 연결하고 자신 이외의 마스크 M을 사용하여 self-attention을 수정한다.

Enriching layout diversity

Subjects가 모두 같은 포즈로 생성되는 등의 너무 과도한 유사성을 제한하기 위한 2가지 개선 사항.

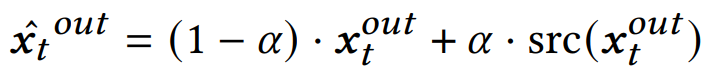

Using Vanilla Query Features

SDSA를 적용한 SDSA query와 그렇지 않은 vanila query를 선형 보간한 blending query를 사용한다.

이는 주로 레이아웃을 결정하는 초기 denoising step에서만 적용된다.

Self-Attention Dropout

마스크에서 임의의 패치를 0으로 설정하여 drop한다.

Feature injection

Identity 일관성을 향상하기 위해 self-attention 출력을 정렬한다.

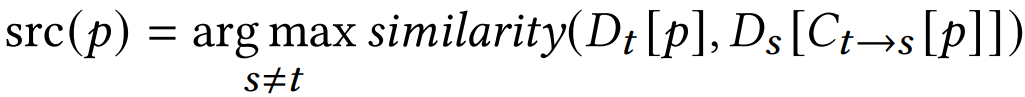

DIFT feature D를 사용하여 패치 대응 맵 C를 계산한다.

이를 배치로 확장하여 배치 내의 모든 이미지 패치 중 가장 유사한 패치를 찾는다.

해당 패치와 feature를 혼합.

실제로는 배경에 영향을 주지 않기 위해 subject mask 내에서만 유사 패치를 찾으며, 유사성이 충분히 높은 feature만 찾도록 임계값을 적용한다.

Anchor images and reusable subjects

추가적으로 이렇게 생성된 이미지의 일부를 anchor image로 지정하여 사용하면 계산 복잡성을 줄이면서 다른 새로운 배치에서도 동일한 subject를 무한하게 재사용할 수 있다.

Multi-subject consistent generation

모든 과정은 subject mask 내에서만 진행되기 때문에 multi-subject의 일관된 생성이 가능하다.

Experiments

ControlNet과 같은 기존 도구와 호환된다.

다른 모델들과 비교했을 때 subject가 잘 유지되면서도 확실히 다양한 이미지를 생성하는 것을 볼 수 있다.