[arXiv](2024/02/06 version v1)

Abstract

복잡한 추론 문제를 해결하기 위해 LLM이 작업 내재적 추론 구조를 스스로 발견하는 Self-Discover를 소개한다.

Chain of Thought (CoT), CoT-Self-Consistency와 같은 방법들보다 10~40배 적은 컴퓨팅 능력을 사용하면서 성능은 더 뛰어나다.

lntroduction

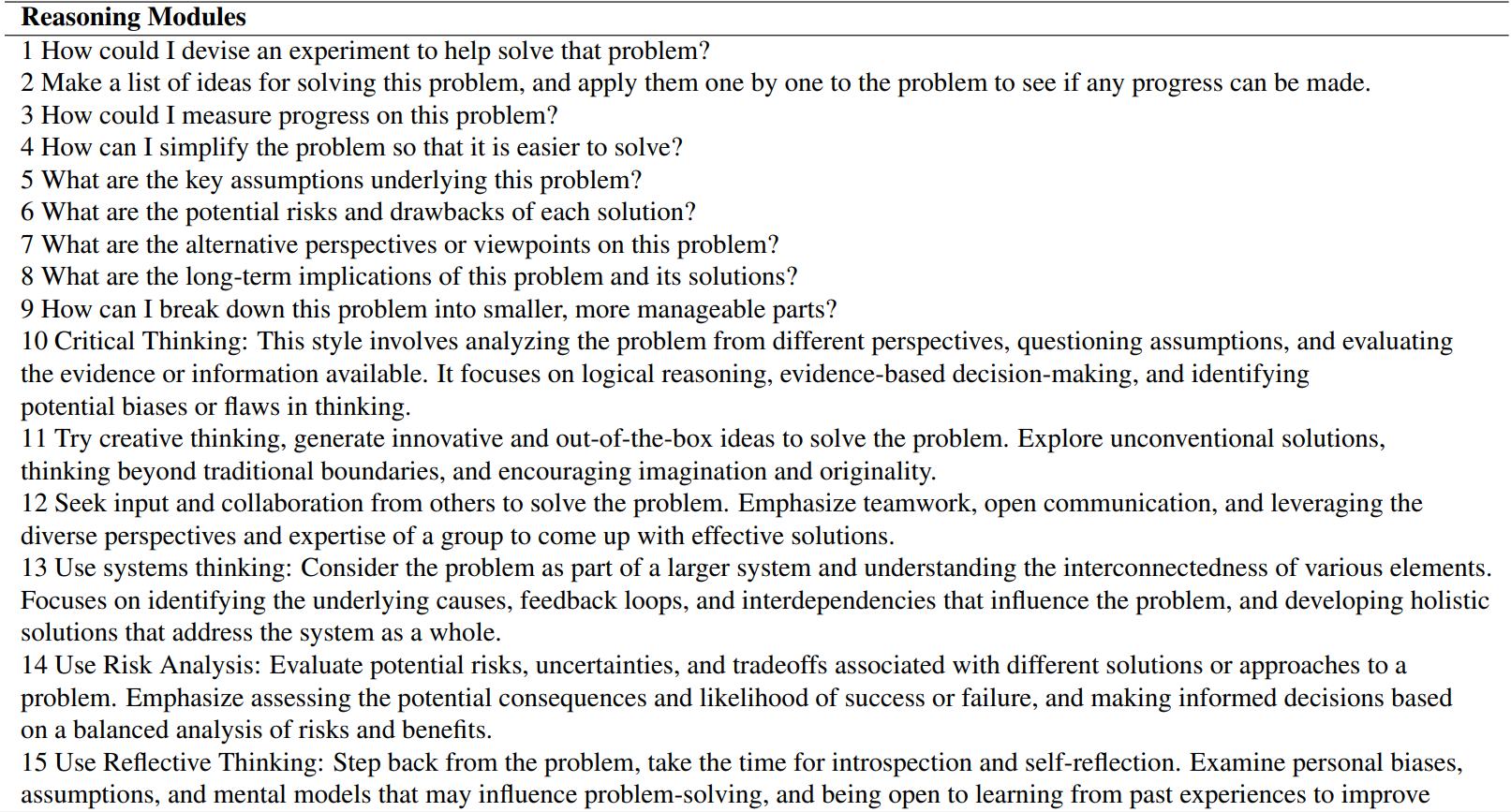

아래 그림과 같이 LLM, task examples without labels, 문제 해결 휴리스틱을 나타내는 일련의 자연어 atomic reasoning modules (e.g. 'breakdown into sub tasks', 'critical thinking', ' think step by step')이 주어지면, LLM이 추론 구조를 스스로 발견하고 문제를 해결하도록 하는 것이 목표이다.

Self-Discovering Reasoning Structures for Problem-Solving

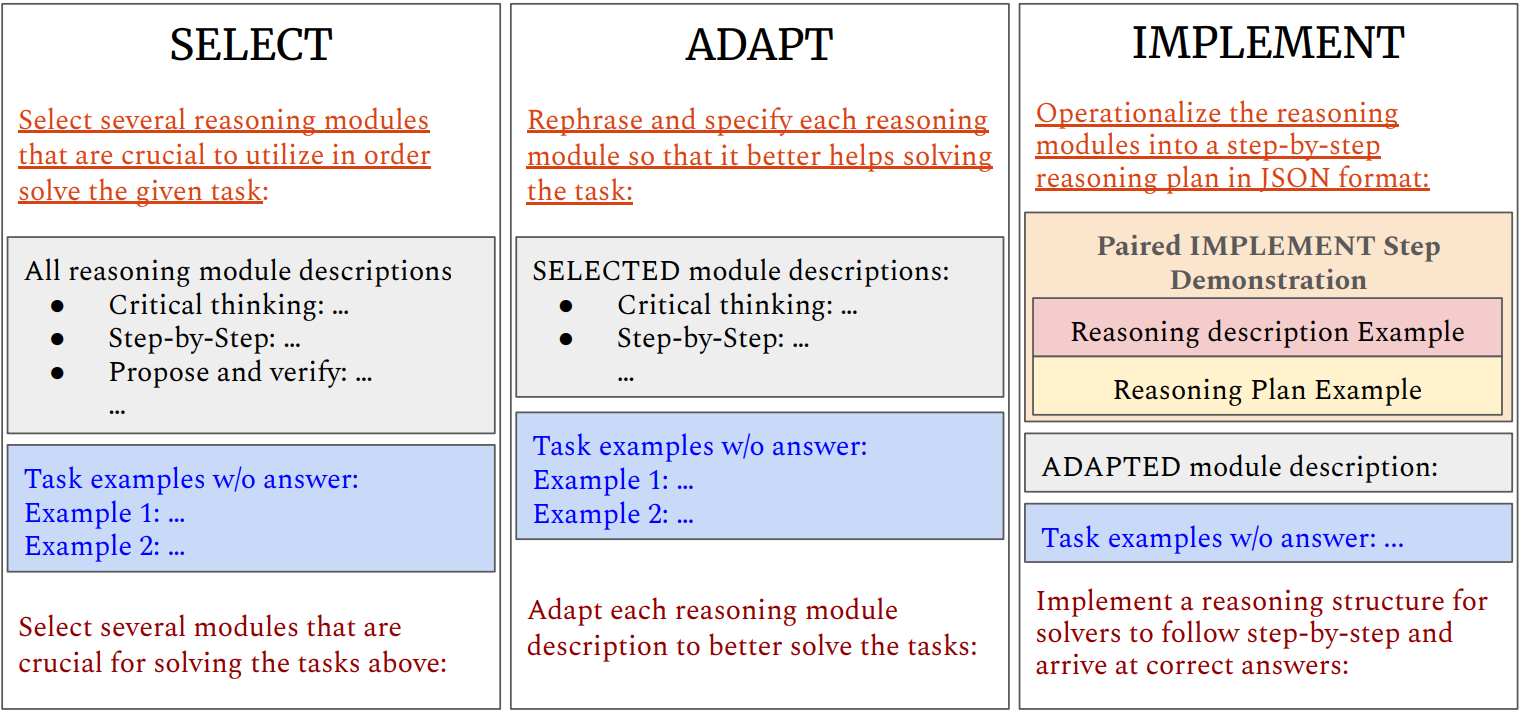

Stage 1: Self-Discover Task-Specific Structures

SELECT

모든 추론 모듈이 작업에 도움이 되는 것은 아니므로 모델 M은 prompt p, 모든 추론 모듈 집합 D, 작업 예제 t를 사용하여 추론 모듈의 하위 집합을 선택한다.

ADAPT

각 추론 모듈에는 일반적인 설명이 붙어있는데, 이를 작업에 맞게 조정한다.

E.g. 산술 작업의 경우 “break the problem into sub-problems” → “calculate each arithmetic operation in order”

IMPLEMENT

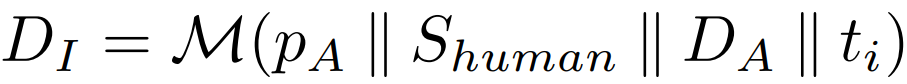

Meta-Prompt에 인간이 작성한 추론 구조 예제 S를 포함하여 모델이 추론 구조를 생성하도록 함.

Stage 2: Tackle Tasks Using Discovered Structures

조정된 추론 모듈의 하위 집합 D, 작업 인스턴스 t를 사용하여 답변 생성.

Results

성능

효율성

생성된 추론 과정 비교