[Github]

[arXiv](2024/01/29 version v1)

Abstract

Mixture-of-Experts + LLaVA

Method

Mixture-of-Experts (MoE)

LIMoE (Multi-modal MoE)

MoE-tuning

Stage I

LLM이 visual token을 이해할 수 있도록 MLP layer를 훈련.

Stage II

Multi-modal instruction data를 통해 fine-tuning.

Stage III

MoE 훈련. 각 토큰은 라우팅 된 top-k 전문가의 가중합으로 집계된다.

Objective

Auto-regressive Loss

P개의 토큰을 순서대로 생성하는 일반적인 자기 회귀 목표.

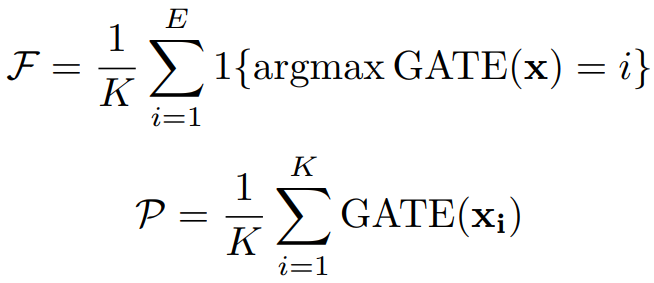

Auxiliary Loss

Load balancing을 위한 보조 손실.

배치 내의 K개의 토큰 중 각 전문가가 처리한 토큰의 비율 F와 평균 라우팅 확률 P의 내적이다.

Uniform distribution에서 최소가 된다고 한다.

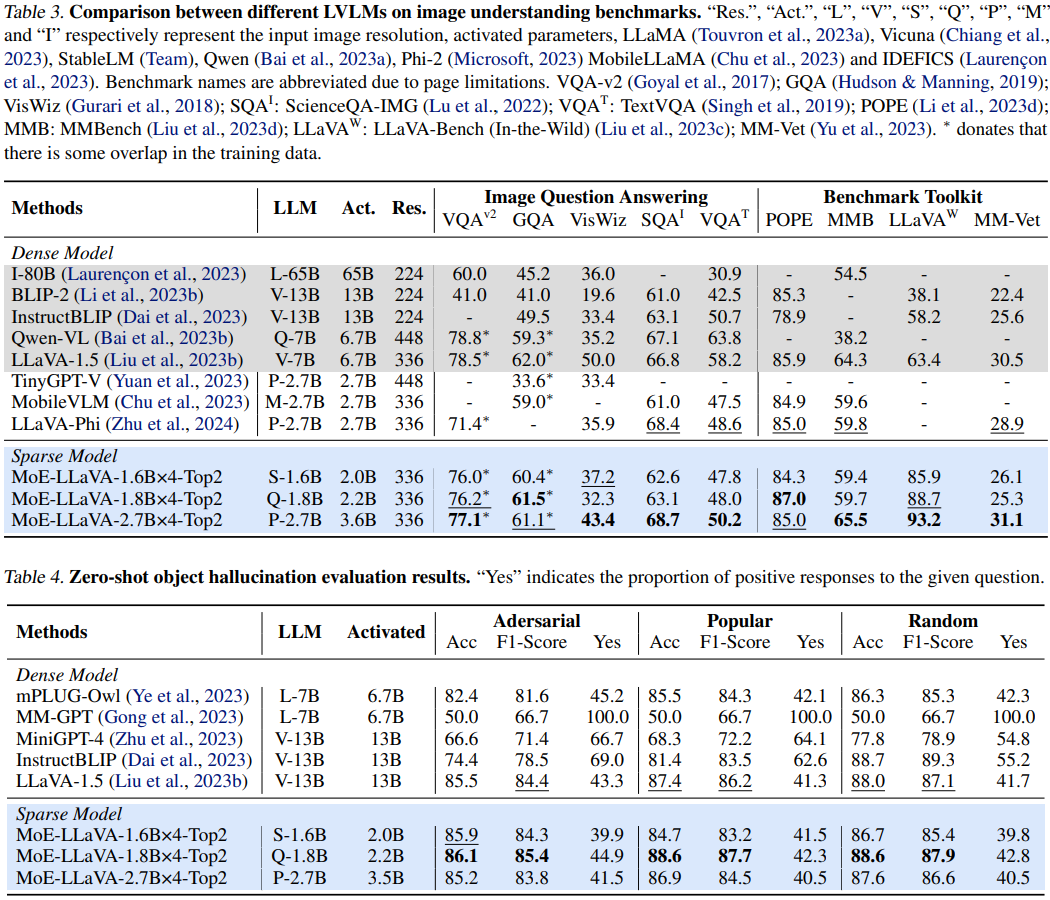

Experiments

LLaVA-1.5를 따르며 vision encoder로 CLIP-Large를 사용한다.

FFN과 MoE를 교대로 사용하여 MoE 레이어의 수는 전체 레이어의 절반이다.