[Github]

[arXiv](2024/01/22 version v1)

Abstract

한 쌍의 LLM을 대조하여 간단하게 LLM이 생성한 글을 탐지할 수 있는 Binoculars 제안

Binoculars: How it Works

Background & Notation

모델 M은 입력 문자열 s를 tokenization 후 확률 분포를 출력하여 어휘집 V 내에서 다음 토큰을 예측한다.

문자열이 얼마나 놀라운지 측정하는 log-perplexity:

한 모델의 결과가 다른 모델에 얼마나 놀라운지 측정하는 cross-perplexity. Cross-entropy와 비슷하다.

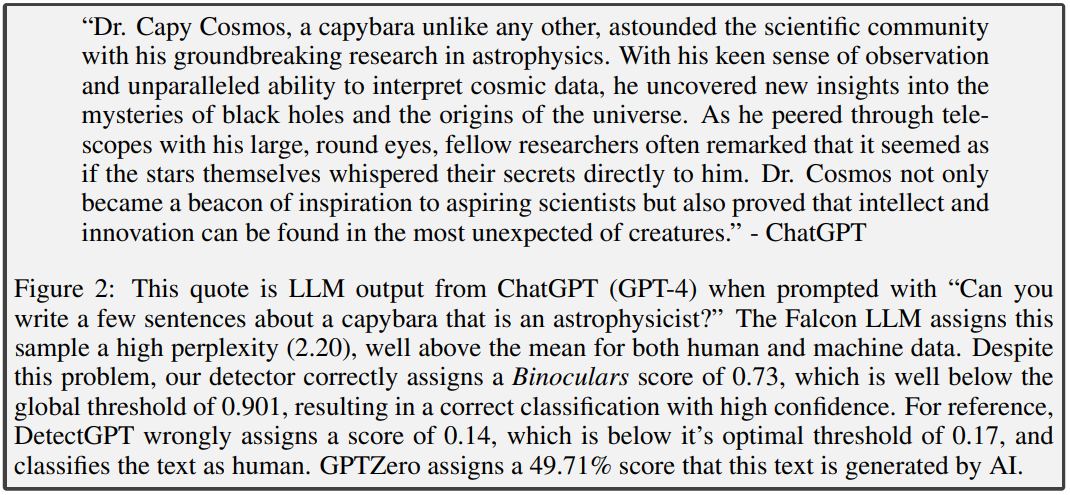

What makes detection hard? A primer on the capybara problem.

왜 cross-perplexity를 사용해야 하는가? 보통 인간이 쓴 글은 ppl이 높고 LLM이 쓴 글은 ppl이 낮다. 하지만 prompt가 포함되면 이야기가 달라진다.

"천체 물리학자인 카피바라에 대해 몇 문장을 쓸 수 있나요?"라는 혼란스러운 prompt가 있을 때, LLM과 인간이 쓴 글 모두 높은 ppl을 가지며, log-ppl의 경우 탐지에 실패한다.

Our detection score

위의 공식은 문자열 s가 같은 prompt에 대해 "M1이 생성한 문자열에 비해 얼마나 놀라운지"를 측정하기 때문에 prompt에 대해 견고하다.

Accurate Zero-Shot Detection

좋다고 합니다.