[arXiv](2022/10/27 version v1)

Abstract

언어 모델에서 추출한 긴 텍스트 샘플은 품질이 좋지 않을 수 있다.

이 문제를 해결하기 위해 entropy에 따른 확률 임계값 이하로 단어를 잘라내는 η-sampling 소개

Introduction

언어 모델에서 고품질의 다양한 샘플을 생성하는 데 효과적인 방법 중 하나는 truncation sampling이다. 이는 각 단어를 생성할 때 확률이 낮은 일부 단어의 확률을 0으로 설정한다.

Truncation의 원칙:

- 확률이 높은 단어는 잘리면 안 되고

- 분포의 모든 단어가 확률이 낮을 때는 나머지 단어에 비해 확률이 낮은 단어만 잘라야 한다.

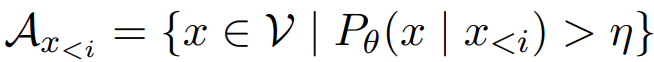

η-sampling:

- 절대 확률 임계값보다 작고

- 분포의 entropy에 따라 달라지는 확률 임계값보다 작은 단어를 잘라낸다.

Truncation as Desmoothing

KL-divergence and mode covering

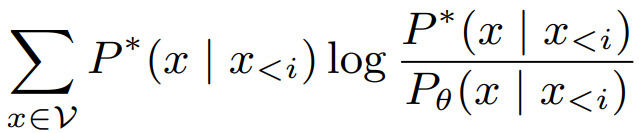

KL-divergence는 어휘집 V 내의 x에 대해 실제 조건부 분포 P*와 추정 조건부 분포 Pθ 사이의 차이를 측정한다.

KL-divergence는 mode-covering 특성이 있는데, 0에 가까운 확률을 잘못 추정하면 손실이 무한대에 가까워져 큰 페널티를 준다.

A neural LM as a smoothed distribution

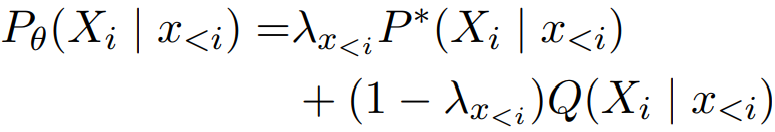

균등 분포와 유사한 분포 Q를 통해 soothing:

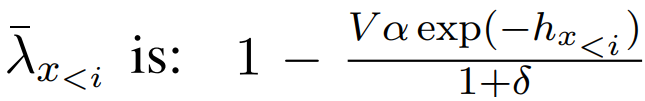

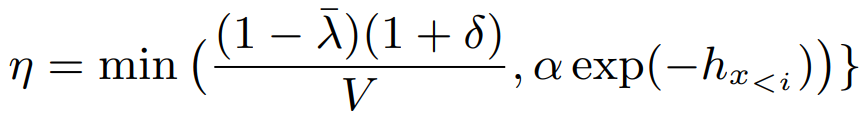

λ에는 η-sampling의 2가지 특징에 따라 다음과 같은 하한이 있다.

λ̄는 1보다 작은 절대 임계값(e.g., 0.8)이고, 전자는 entropy h에 따라 달라지는 임계값이다.

Principles for truncation as desmoothing

실제 분포에서 확률이 0보다 큰 단어 집합인 true distribution support를 S라 하자.

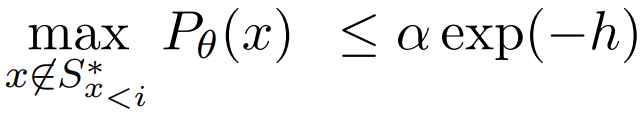

Absolute probability

λ에 하한이 있었으므로 S에 속하지 않는 단어들에게는 상한이 있다.

따라서 임계값 이상의 확률을 가진 단어는 반드시 S에 속한다.

Relative probability

Entropy가 높은 분포일수록 S에 속하지 않는 단어의 상한이 낮아진다.

= 균등한 분포일수록 상대적으로 더 작은 값만 절단함

η-sampling

'논문 리뷰 > Language Model' 카테고리의 다른 글

| Spotting LLMs With Binoculars: Zero-Shot Detection of Machine-Generated Text (0) | 2024.01.29 |

|---|---|

| Medusa: Simple LLM Inference Acceleration Framework with Multiple Decoding Heads (0) | 2024.01.25 |

| Fast Inference from Transformers via Speculative Decoding (0) | 2024.01.25 |

| Self-Rewarding Language Models (0) | 2024.01.24 |

| DiffusionGPT: LLM-Driven Text-to-Image Generation System (0) | 2024.01.24 |

| Towards Conversational Diagnostic AI (AMIE) (0) | 2024.01.18 |