[Github]

[arXiv](Current version v1)

Abstract

Multi-modal 학습이 가능한 MoE인 LIMoE(Language-Image MoE)를 제안

Multimodal Mixture of Experts

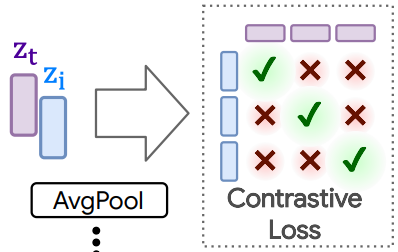

Multimodal contrastive learning

같은 pair data (i, t)끼리 더 가깝도록, unpair data가 멀도록 훈련됨.

The LIMoE Architecture

각각의 modality를 동일한 차원으로 투영하는 각각의 projection layer와 공유 transformer encoder로 입력을 처리하고 per-modality weight matrices Wm을 통해 projection한 후 Lj를 계산한다.

Sparse MoE backbone

V-MoE의 설계를 사용한다.

Challenges for multimodal MoEs

Multi-modal MoE의 한 가지 문제점은 modality 불균형이다.

실제로 훈련 설정에서 텍스트보다 이미지가 훨씬 더 많으며, 이는 소수인 modality 토큰이 소수의 전문가에게 쏠리는 현상이 나타난다.

Auxiliary losses

새로운 local entropy loss, global entropy loss 도입.

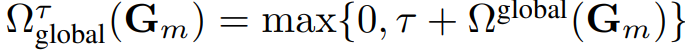

Definition

Modality m에 대해서 gating matrix Gm이 다음과 같을 때,

Effects of the losses

Local entropy를 최소화하여 동일한 modality는 동일한 전문가에 할당되도록 장려하고, global entropy를 최대화하여 너무 많은 토큰이 하나의 전문가에 몰려 drop되는 경우를 줄인다.

유연성을 허용하기 위해 global entropy의 최솟값을 제한한다.

Priority routing

Batch Priority Routing을 사용하여 더 작은 전문가 버퍼 용량을 사용하고 훈련을 안정화한다.