[Github]

[arXiv](2024/01/10 version v1)

Abstract

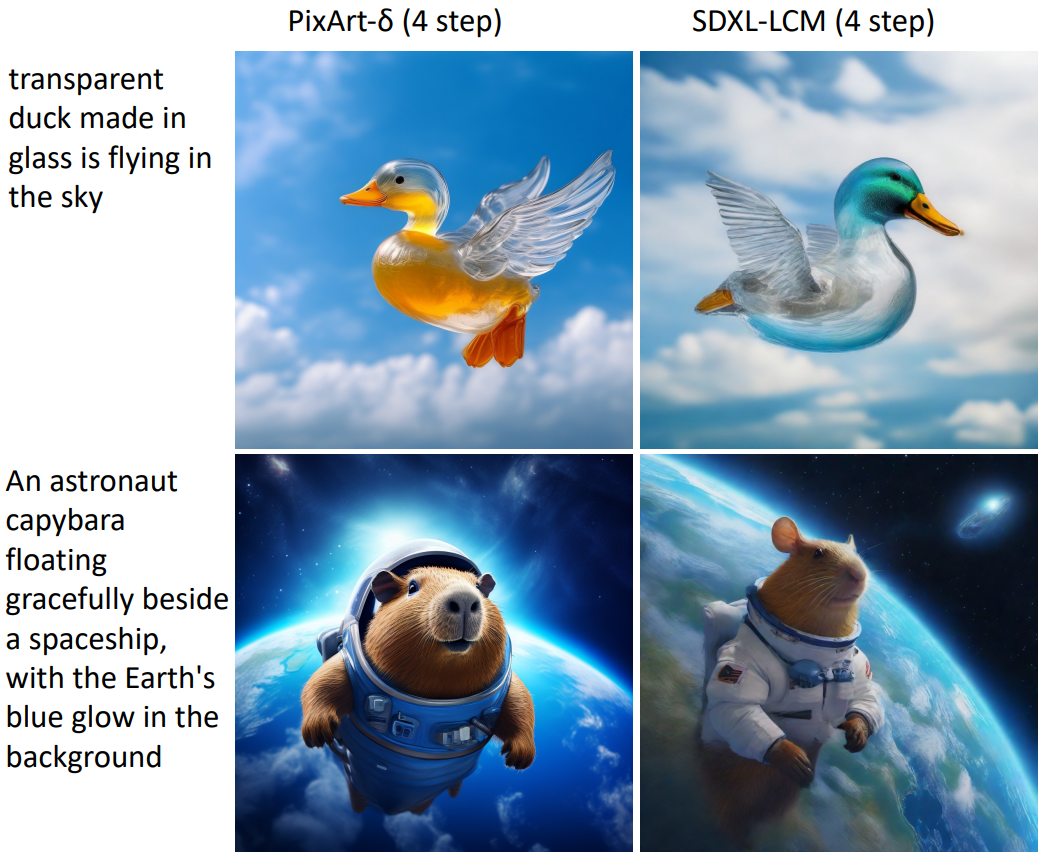

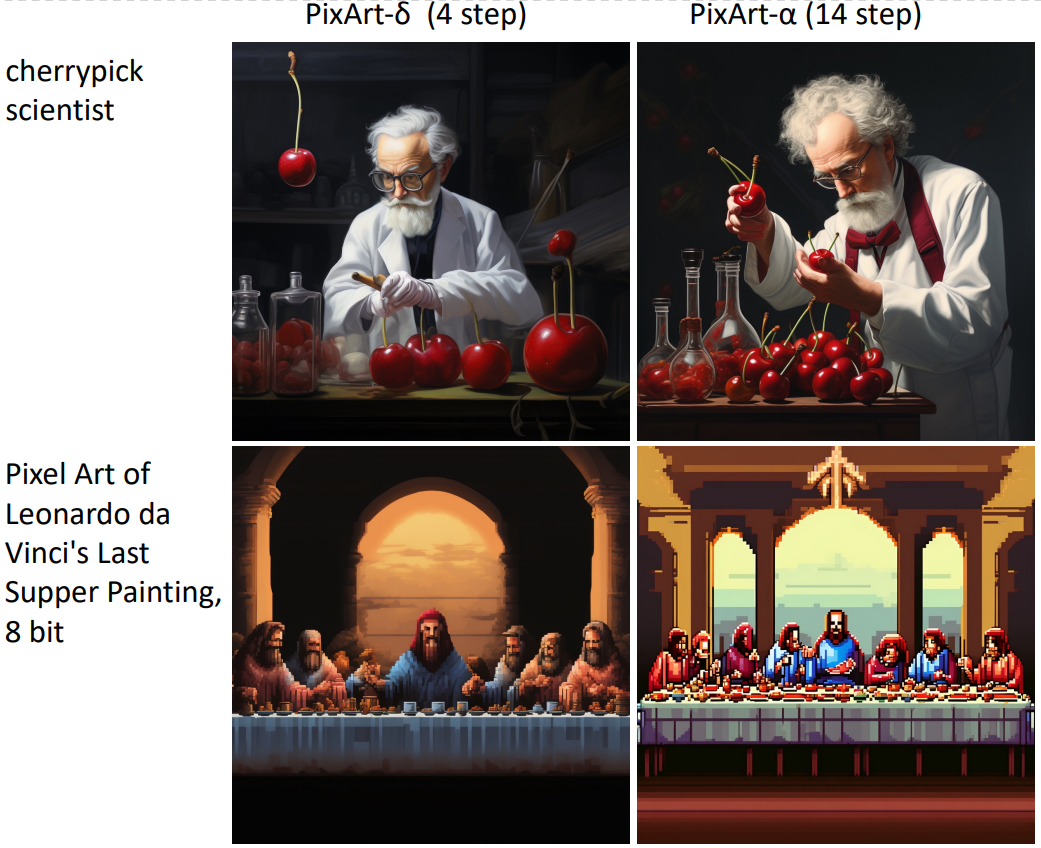

PixArt-α에 Latent Consistency Model과 ControlNet을 통합한 PixArt-δ 소개.

LCM in PixArt-δ

- Algorithm and Modification

- Training Efficiency and Inference Speedup

- Training Details

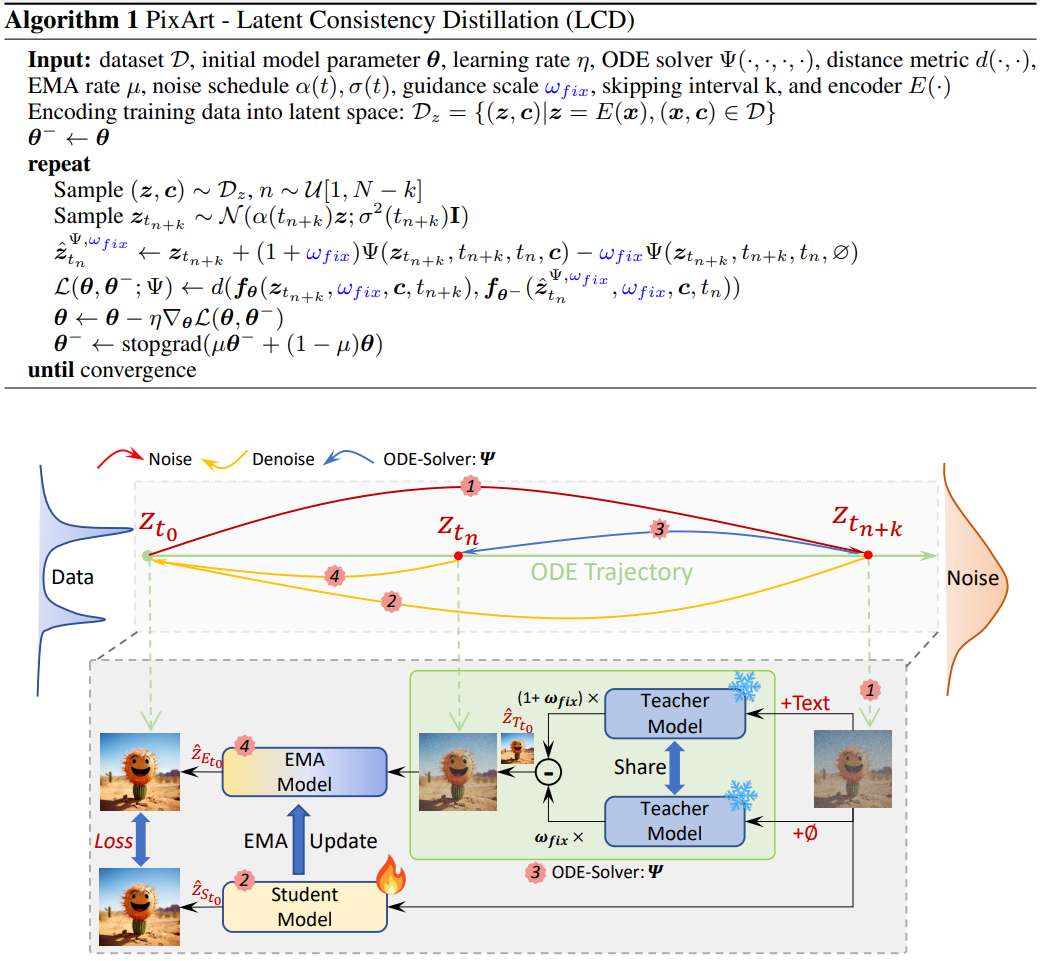

Algorithm and Modification

LCD Algorithm

가변 guidance scale w 대신 고정된 w를 사용하는 것 외에는 LCM과 똑같다.

Effect of Hyper-parameters

bs = batch size, w_fix = 고정된 w, w_Embed = 가변 w

- CFG Scale Analysis: 고정된 w가 더 성능 좋았다.

- Batch Size Examination: 더 큰 배치가 더 좋긴 하지만 작은 배치로도 좋은 성능을 낼 수 있다.

- Convergence: 약 5000 iteration 이후 거의 성능 개선 안 됨.

- Noise Schedule Adjustment: Simple Diffusion에 따라 noise schedule 조정.

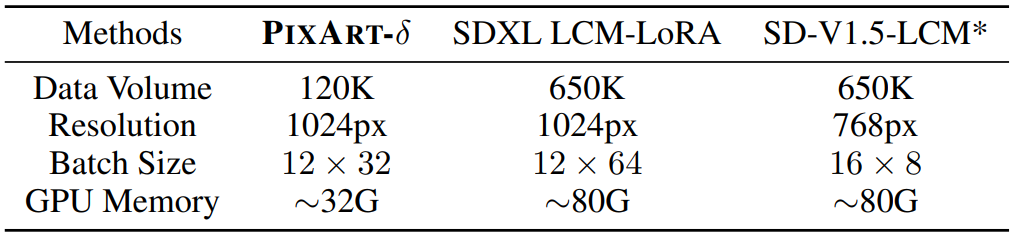

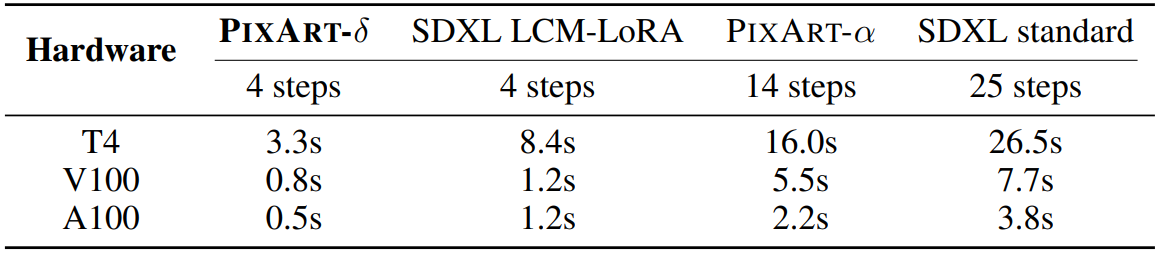

Training Efficiency and Inference Speedup

U-Net 기반 모델에 비해 메모리 제약이 크게 줄어 소비자급 GPU에서도 훈련할 수 있다.

8-bit inference를 통해 매우 빠르고 효율적인 추론 가능.

Training Details

자세한 훈련 설정들. 생략.

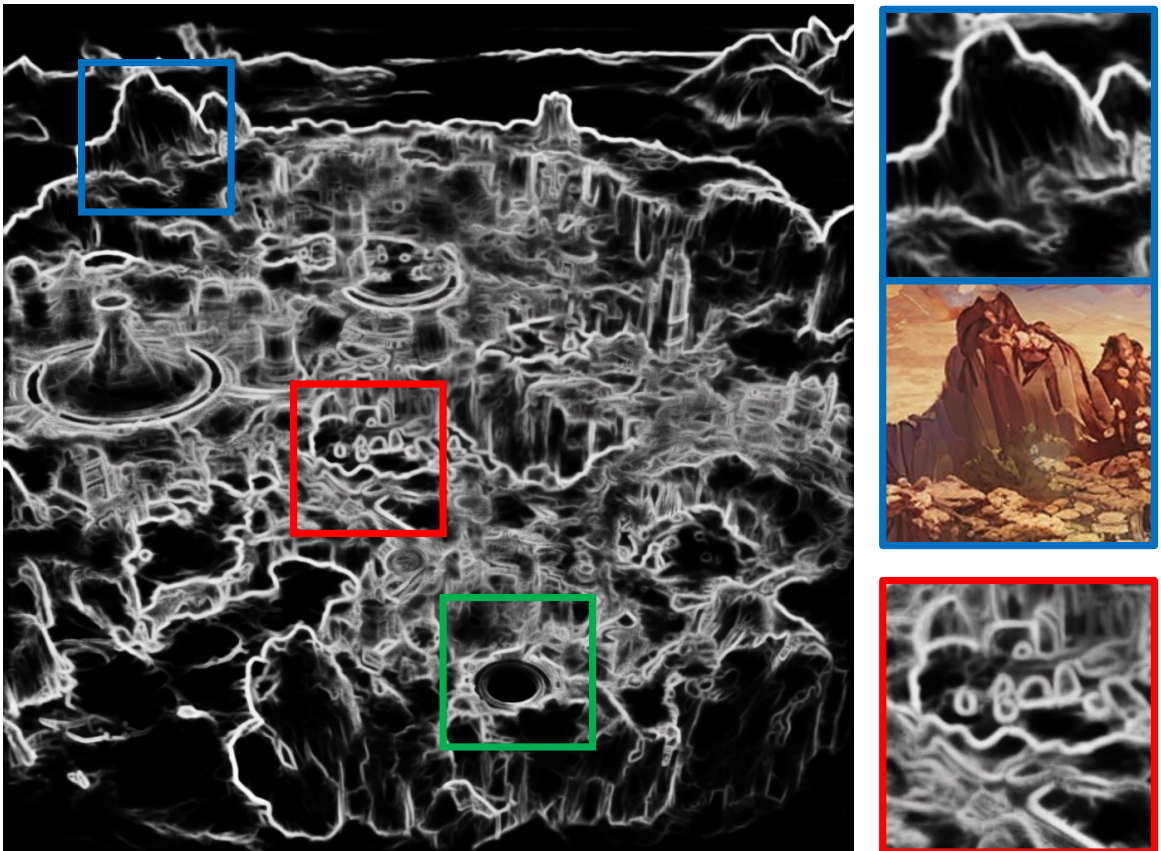

ControlNet in PixArt-δ

Zero-convolution을 zero-linear로 대체하고 두 가지 구조 제안.

ControlNet-UNet

1 ~ 14 block을 인코더, 15 ~ 28 block을 디코더로 취급한다. 하지만 이 방법은 transformer architecture에서 벗어나기 때문에 효율성이 떨어진다.

ControlNet-Transformer

초기 N개의 block을 복사하고 i 번째 copy block의 출력을 fixed block의 출력에 바로 더한다. 이러한 구조는 transformer의 원래 데이터 흐름을 준수하여 성능이 크게 향상된다.

Experiments