[arXiv](2024/01/08 version v1)

Abstract

Mistral 7B와 동일하지만 각 레이어가 8개의 feedforward block으로 구성된 Sparse Mixture of Experts (SMoE) 모델인 Mixtral 8x7B 소개

LLaMA2 70B와 대등하거나 그 이상...

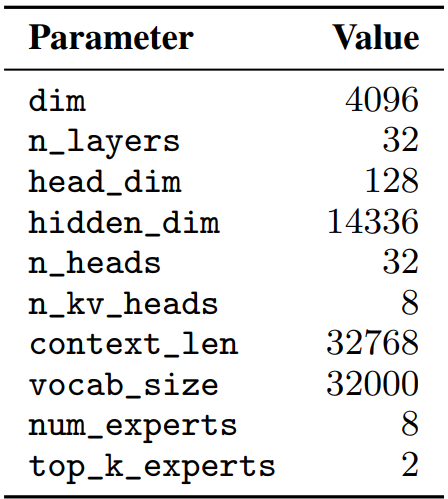

Architectural details

Mistral 7B와 다른점은 32K token의 조밀한 context 길이를 지원하고 FF를 MoE로 대체했다.

Mistral 7B |

Mixtral 8x7B |

Sparse Mixture of Experts

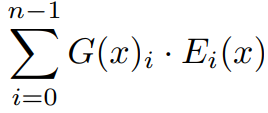

Mixture of Experts: gating network G를 통해 전문가를 선택한다.

V-MoE: Transformer의 경우 토큰 단위로 gating이 수행되며 같은 전문가에 할당된 토큰끼리 모아서 연산한다.

Mixtral에서는 K = 2, SwiGLU를 사용하여 각 전문가를 SwiGLU의 sub block으로 취급한다.

Results

Mixtral of experts

A high quality Sparse Mixture-of-Experts.

mistral.ai

'논문 리뷰 > Language Model' 카테고리의 다른 글

| Self-Rewarding Language Models (0) | 2024.01.24 |

|---|---|

| DiffusionGPT: LLM-Driven Text-to-Image Generation System (0) | 2024.01.24 |

| Towards Conversational Diagnostic AI (AMIE) (0) | 2024.01.18 |

| Mistral 7B (1) | 2024.01.11 |

| TinyLlama: An Open-Source Small Language Model (0) | 2024.01.09 |

| DocLLM: A layout-aware generative language model for multimodal document understanding (0) | 2024.01.09 |