[arXiv](2023/12/31 version v1)

Abstract

LLM이 layout을 고려하여 시각적 문서를 추론하도록 경량으로 확장한 DocLLM 소개

DocLLM Framework

Model Architecture

Baseline: LLaMA2

OCR을 사용하여 얻은 text token과 공간 정보를 별개의 양식으로 취급하여 별개의 벡터를 사용한다.

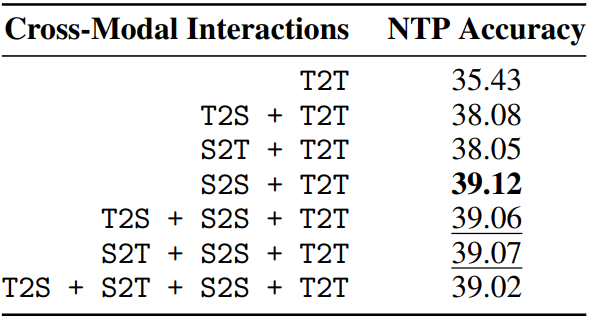

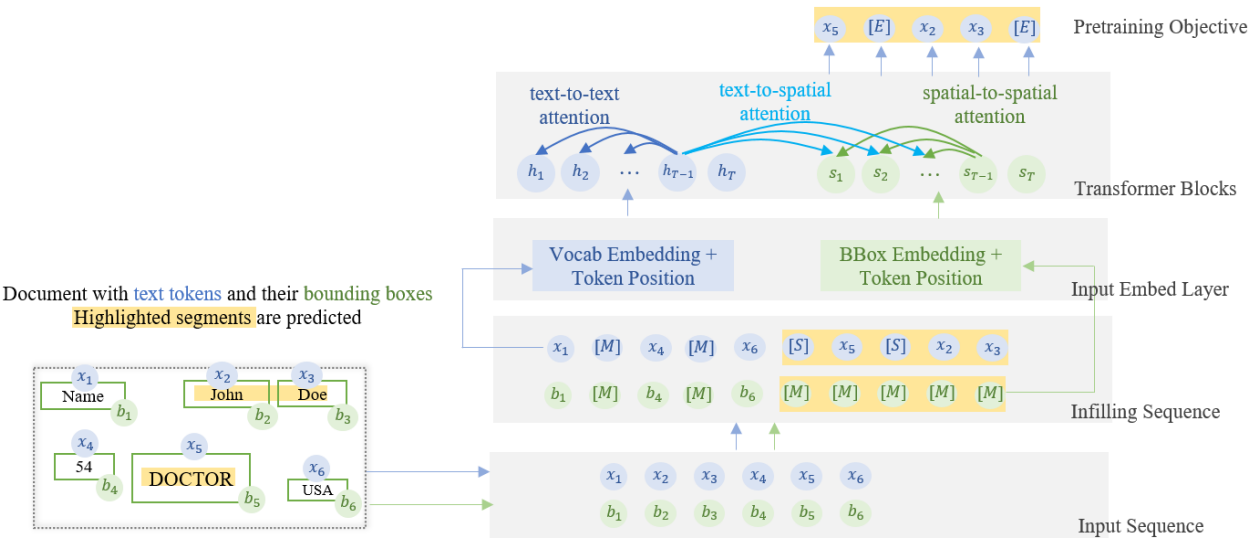

Disentangled Spatial Attention

Text token t의 hidden vector H에 대한 일반적인 self-attention:

DocLLM에서는 입력 {(x, b)}에 대해 bbox를 hidden vector S로 임베딩하고 text-to-text, text-to-spatial, spatial-to-text, spatial-to-spatial attention을 수행한다.

xi에서 xj로의 attention map은 다음과 같이 계산된다.

여기서 주의할 점은 S가 여러 레이어에 걸쳐 재사용된다는 점이다.

또한 추가 피라미터는 레이아웃 임베딩과 projection layers로 이미지 모델을 사용하는 것에 비하면 현저히 적다.

이전 연구에서와 같이 단순하게 H에 S를 더하는 방법보다 attention score에서 양식을 분리하여 표현함으로써 선택적 집중을 가능하게 한다. (인접한 텍스트가 서로 관련이 없을 수도 있으므로)

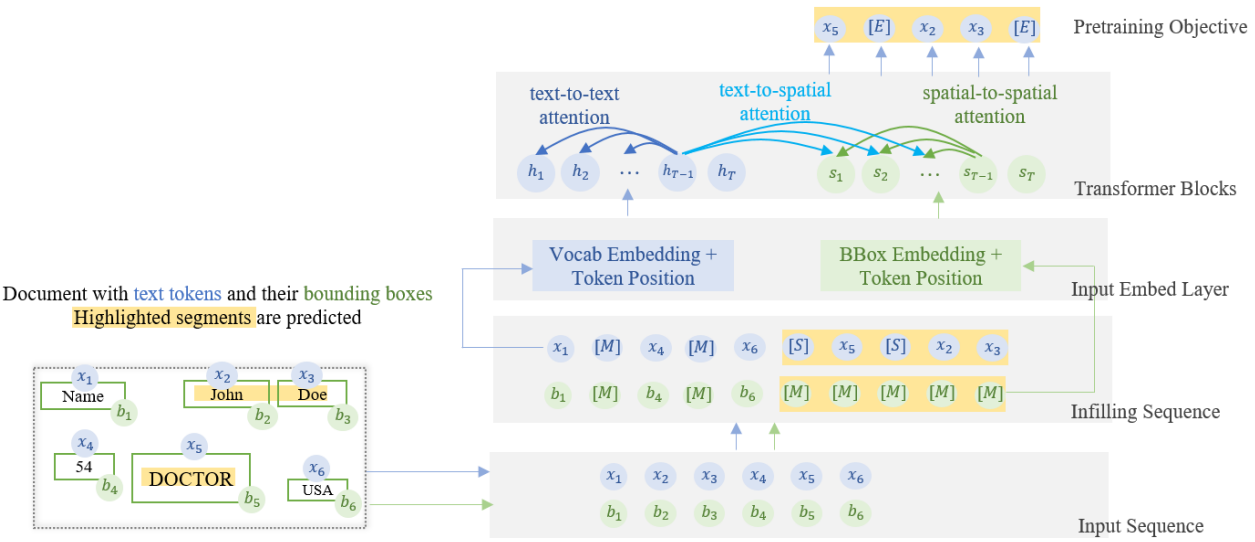

Pretraining

시각적 문서는 '이름', '직업'과 같이 단절되고 불규칙한 텍스트 조각으로 구성된 경우가 많다. 따라서 OCR이 식별한 입력 시퀀스 x에 대해 text infilling 목표를 사용한다.

Text infilling에 대한 자세한 설명은 GLM - autoregressive blank filling 참고

DocLLM에서의 text infilling:

Text infilling에 대한 Cross-Entropy Loss:

이 목표는 pretraining step에서만 모델의 모든 피라미터에 대해 사용된다.

Instruction Tuning

각 작업에 따라 적절한 Instruction Tuning 수행. 그냥 나열이므로 생략.

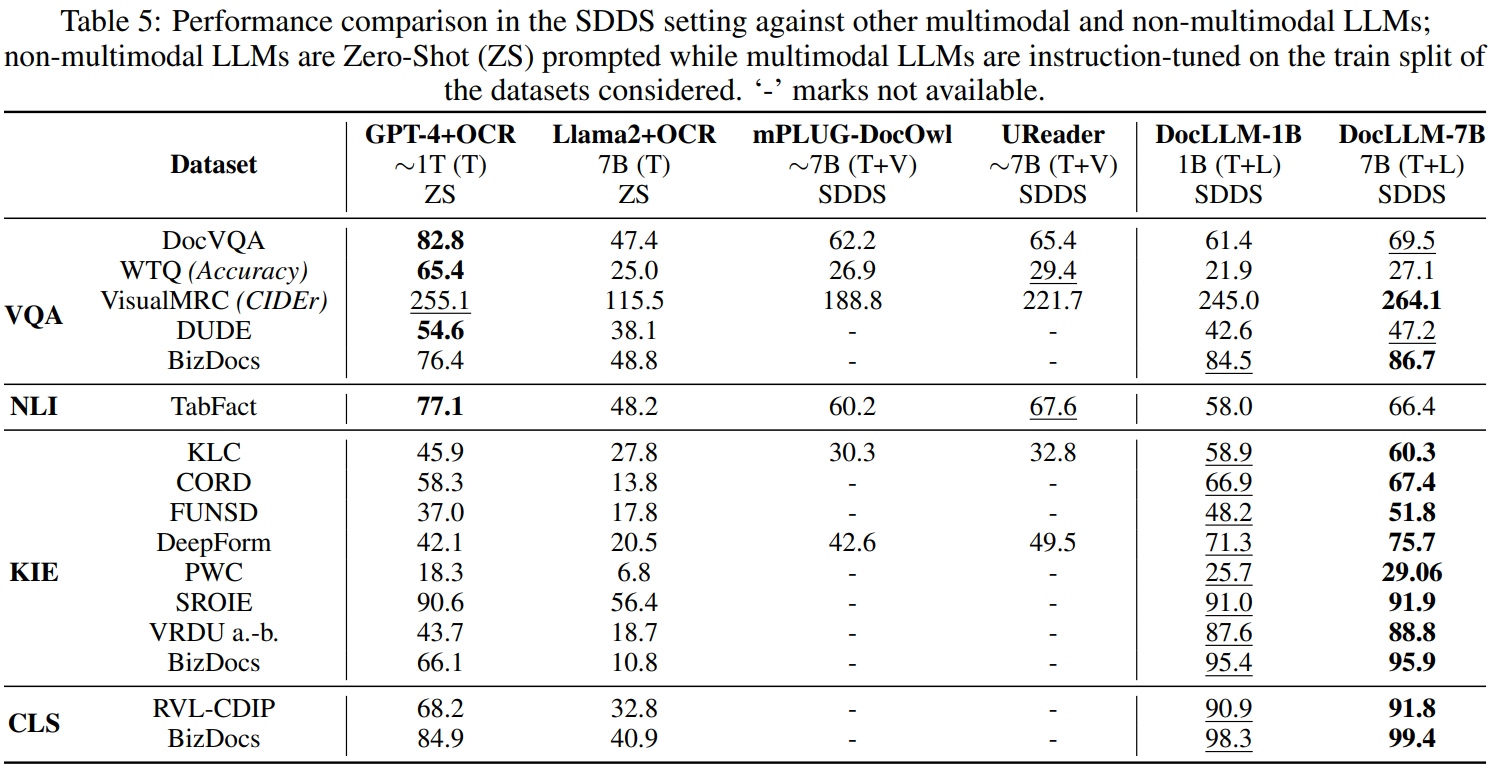

Experiments

'논문 리뷰 > Language Model' 카테고리의 다른 글

| Mixtral of Experts (Mixtral 8x7B) (0) | 2024.01.11 |

|---|---|

| Mistral 7B (1) | 2024.01.11 |

| TinyLlama: An Open-Source Small Language Model (0) | 2024.01.09 |

| LLaMA Beyond English: An Empirical Study on Language Capability Transfer (2) | 2024.01.08 |

| Improving Text Embeddings with Large Language Models (0) | 2024.01.04 |

| LARP: Language-Agent Role Play for Open-World Games (0) | 2024.01.03 |