[Github]

[arXiv](Current version v1)

Abstract

개념 침식을 일으키지 않고 특정 개념을 삭제할 수 있는 adapter인 SPM 제안

Introduction

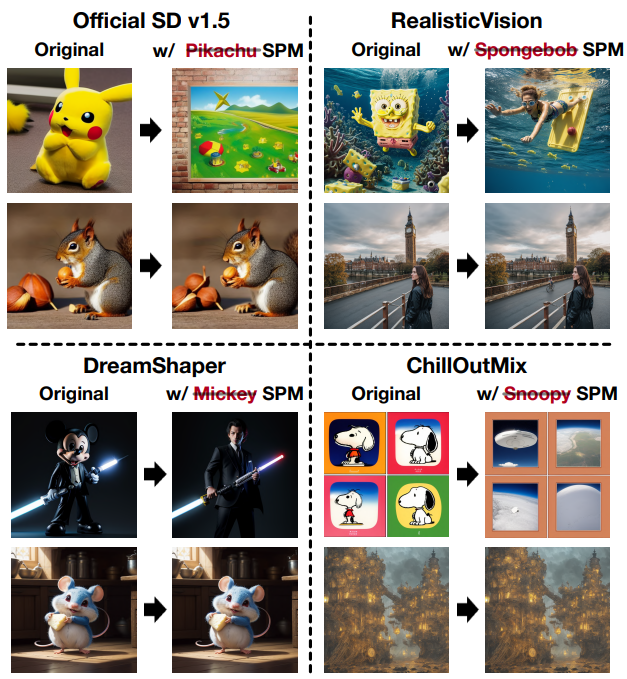

Fine-tuning을 통한 개입은 위 그림과 같이 개념 침식(concept erosion)을 일으킨다.

DM에 membrane으로 주입하여 반투과성(SemiPermeability) 개념을 학습할 수 있는 1-dim non-invasive adapter를 개발한다.

SPM은 보조적인 훈련 데이터 없이도 사전 훈련된 모델을 유지하면서 개념을 지우는 방법을 학습한다.

삭제된 SPM corpus를 확보하면 재조정 없이도 다른 DM으로 이전할 수 있다.

한꺼번에 여러 개념을 삭제할 수 있고 SOTA에 비해 160배 이상의 속도 향상을 보여준다.

Method

- SPM

- Latent Anchoring

- Facilitated Transport Mechanism

SPM as a 1-dim Lightweight Adapter

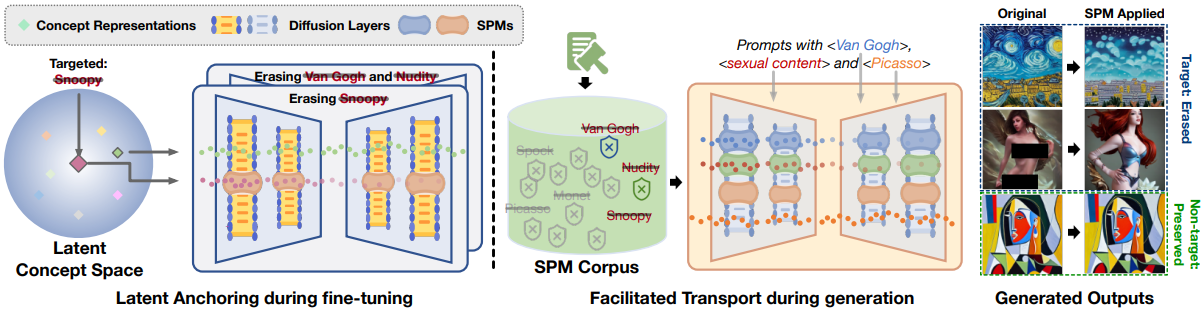

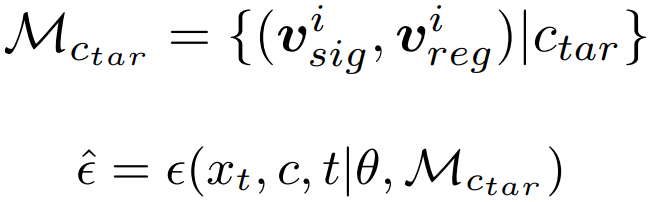

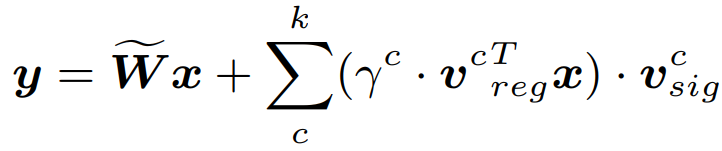

SPM은 삭제 신호 vsig, regulator vreg일 때 다음과 같이 모델 가중치에 개입한다.

LDM의 노이즈 예측

개념 ctar을 지우는 SPM은 다음과 같이 공식화됨.

Latent Anchoring

Diffusion Model의 개념 구성과 부정이 로그 확률에 대한 산술 연산과 일치할 수 있다는 발견에서 영감을 받아 개념 제거를 수행.

목표 개념 ctar과 erased model에서 ctar이 입력되었을 때의 동작을 의미하는 개념 csur을 정의하고 SPM은 erasing loss를 사용하여 ctar과 csur의 확률 분포를 일치시킨다.

해당 참조 논문에 따르면 관련 개념이 함께 정의되어야 개념 제거를 수행할 수 있다. 또한 η가 클수록 SPM은 목표 개념을 더 강하게 제거해야 한다.

목표 개념과 멀리 떨어진 개념에 대해서는 일관성을 유지하도록 기대한다.

목표 개념과의 CLIP 코사인 유사도를 비교하여 목표 개념과 먼 개념일수록 더 많이 샘플링되는 샘플링 분포 D를 도출하고

Anchoring loss를 다음과 같이 공식화한다.

Total training loss:

Facilitated Transport

개념별로 모델 독립적인 방식으로 SPM을 학습하면 plug-and-play 방식으로 다른 DM W̃에 적용할 수 있다.

Latent anchoring에도 불구하고 multi-SPMs가 있는 까다로운 시나리오에서는 필연적으로 개념이 얽히기 때문에 이를 해결하기 위하여 facilitated transport mechanism을 도입한다.

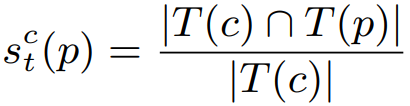

구체적으로 텍스트 프롬프트 p가 입력되었을 때 목표 개념 c에 대한 정보 투과성 γc(p)는 p에 표시된 c의 확률에 따라 달라진다. 이는 텍스트 인코딩 공간에서 코사인 거리 scf(p)를 계산하여 구하는데, 기존의 global 표현에다가 추가로 토큰 수준의 유사성을 식별하는 metric을 추가로 도입하고 (T = text tokenizer)

c가 설명에 나타날 확률은 다음과 같이 도출된다.

이로써 global, local 수준에서 c와의 상관관계를 파악할 수 있고 γ의 값에 따라 동적으로 삭제 신호를 방출한다.

Experiments