Data curating의 중요성, 더 많은 diffusion noise

Stability.AI는 실망시키지 않아...

[Github]

[Paper]

Abstract

고해상도, 최첨단 Text-to-Video, Image-to-Video 생성을 위한 잠재 비디오 확산 모델인 Stable Video Diffusion 소개.

Text-to-Image pretraining, Video pretraining, high-quality Video fine-tuning 각 단계를 식별하고 평가한다.

Introduction

생성 모델에 대한 데이터의 중요성에도 불구하고 놀랍게도 비디오 생성에서 데이터의 영향을 조사한 연구는 없었다. 이미지 모델링의 경우 크고 다양한 dataset에서 사전 훈련 후 고품질 dataset에서 fine-tuning 시 성능이 크게 향상되는 것으로 알려졌다.

3개의 비디오 훈련 단계를 식별, 대규모 video data curation의 효과에 대한 경험적 연구를 제시한다.

A general motion and multi-view prior

제안된 큐레이션 방식을 통해 구성된 대규모 video dataset에서 훈련된 모델은 다양한 작업 대한 강력한 기반이 될 수 있다.

Background

Latent Diffusion Model (Stable Diffusion)

Baseline: Video-LDM(Stable video diffusion에서는 시간 계층만 훈련하지 않고 모든 모델을 fine-tuning 한다.)

프레임 속도에 대한 Micro conditioning 도입 : SDXL (Micro conditioning part만 읽어도 됨. 사실 몰라도 됨.)

EDM-framework (졸라 어려움)

Curating Data for HQ Video Synthesis

Data Processing and Annotation

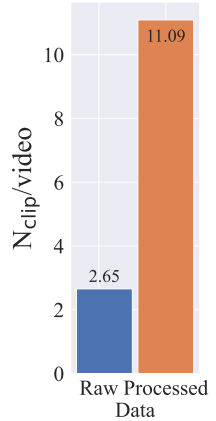

Cut detection pipeline을 통해 메타데이터의 3가지 다른 FPS 수준에서 훨씬 더 많은 클립을 얻는다.

Coca로 클립의 중간 프레임에 대한 이미지 캡션을 얻고, V-BLIP로 비디오에 대한 캡션을 얻은 후 LLM을 통해 클립에 대한 3번째 설명 생성.

Large Video Dataset (LVD)이라고 부르는 초기 데이터셋은 580M의 video-clip pair로 구성된다.

OpenCV를 통해 dense optical flow를 계산하고 움직임이 적은 정적인 클립을 제거.

OCR detection을 통해 텍스트가 포함된 클립 제거. 각 클립의 처음, 중간, 마지막 프레임에 CLIP 임베딩을 부여하여 aesthetics score, text-image 유사성 계산.

Stage I: Image Pretaining

Stage II: Curating a Video Pretraining Dataset

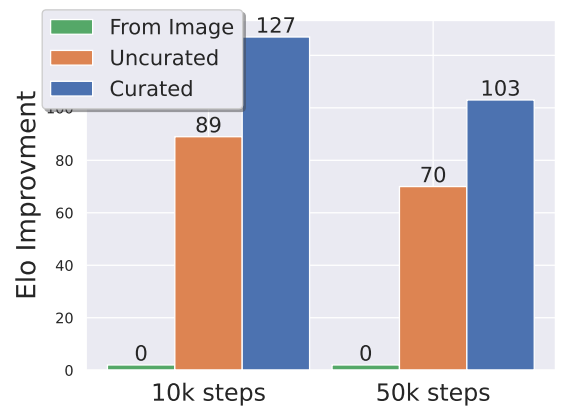

각 유형의 annotation(CLIP score, aesthetic score, OCR detection rate, synthetic caption, optical flow score)에서 하위 12.5%, 25%, 50%를 제거한 각 하위 집합에 대해 동일한 모델을 훈련하고, 인간 선호도 투표에 대한 Elo ranking을 평가한다. 이를 통해 각 annotation에 대한 최적의 필터링 임계값을 찾는다. (synthetic caption의 경우 수치적으로 계산할 수 없으므로 생성 방법에 대한 선호도 조사)

필터링 전후의 통계량 비교:

선호도 조사

Stage III: High-Quality Finetuning

고품질의 250K 비디오 클립으로 구성된 dataset으로 fine-tuning 후 선호도 조사:

Training Video Models at Scale

기본 모델 훈련 후 다양한 작업에 대해 fine-tuning.

Pretrained Base Model

노이즈 스케줄을 선택하는 것이 중요하다는 것을 강조한 simple diffusion에서 영향을 받았다.

고해상도일수록 더 많은 노이즈가 필요하며, 이산 시간 노이즈의 최대 timestep에서도 원본 이미지의 long-wavelength를 완전히 지우지 못한다.

EDM에서 제안한 네트워크 사전 조정을 사용하여 이산 노이즈 스케줄을 연속 노이즈로 바꾸고 바뀐 노이즈 스케줄에 대해 SD 2.1을 fine-tuning 한다.

그다음 시간 계층을 삽입한 후 임베딩을 제외한 모든 계층을 EDM 노이즈 스케줄을 사용하여 256x384의 해상도로 14개 프레임에 대해 훈련한 뒤, 노이즈 분포를 더 많은 노이즈로 이동시킨 후 320x576 해상도에서 추가 훈련한다.

여기까지 다양한 작업의 fine-tuning에 사용될 '기본 모델'이다.

High-Resolution Text-to-Video Model

높은 시각적 품질을 가진 576x1024, ~1M dataset에서 fine-tuning. EMA 사용.

High Resolution Image-to-Video Model

텍스트 임베딩을 CLIP 임베딩으로 대체. 입력에 소량의 노이즈를 추가한 뒤(noise augmentation) 각 프레임의 채널에 연결하고 기본 해상도(320x576)에서 fine-tuning.

조건화 신호가 매우 강하기 때문에 노이즈 분포를 더 많은 노이즈로 이동시키고 576x1024에서 추가 훈련. EMA.

Camera Motion LoRA

3가지 카메라 동작에 대한 LoRA 훈련.

Frame Interpolation

2개의 noise-augmented frame 사이의 3개의 프레임을 보간하도록 훈련됨.

576x1024, EMA, 많은 노이즈 스케줄.

256의 작은 배치 크기에서도 매우 빠르게 수렴하고 일관되고 부드러운 출력을 생성한다고 함.

Multi-View Generation

Image-to-Video SVD를 Objaverse dataset의 curated subset에 대해 객체의 한 예제와 카메라 고도를 조건으로 fine-tuning.

Multi-shot generation 또한 적은 반복으로 빠르게 수렴할 수 있다.

MVImgNet dataset