픽셀, 잠재 기반 Diffusion Model을 혼합하여 적은 비용으로 고품질 비디오 생성 가능

[Github]

[arXiv]

Abstract

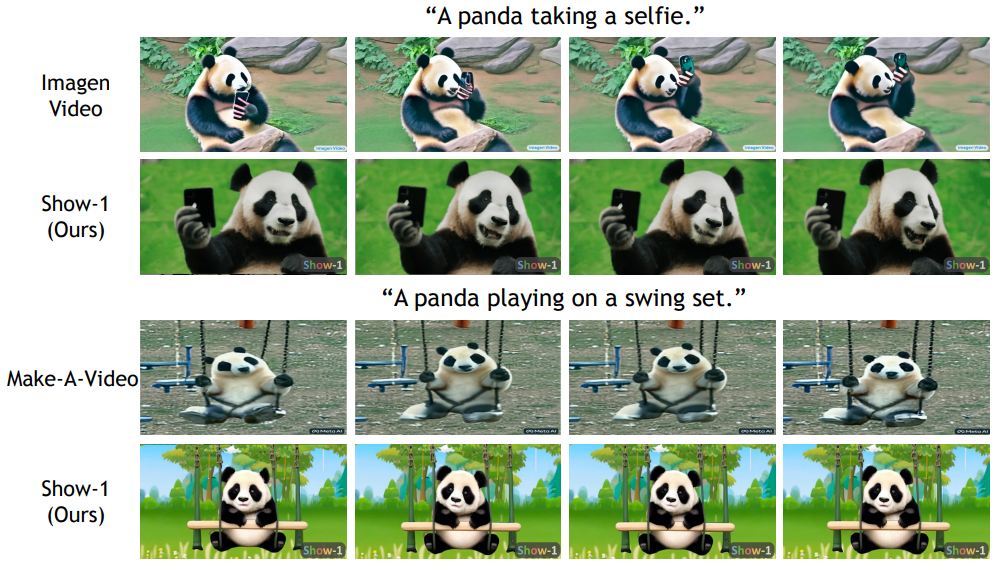

픽셀 기반 및 잠재 기반 VDM(Video Diffusion Model)을 결합한 Show-1 제안

Introduction

픽셀 기반 VDM: 프롬프트에 정확하게 맞춰진 모션을 생성할 수 있지만 높은 계산 비용

잠재 기반 VDM: 계산 효율이 좋지만 해상도가 높아질수록 비디오-텍스트 정렬 무시

키 프레임 생성, 프레임 보간, 초해상도에 각각의 모듈을 사용.

본 논문의 기여:

- 저해상도에서는 텍스트 정렬이 정확한 픽셀 기반 VDM을, 고해상도에서는 정렬된 결과를 바탕으로 계산 효율이 높은 잠재 기반 VDM을 사용하여 고품질 비디오 생성

- 낮은 계산 비용으로 고해상도 비디오 생성 가능

Show-1

Turn image U-Net to video

시간 차원을 계산하기 위한 1D convolution과 attention 계층 추가.

Pixel-based keyframe generation model

Why we choose pixel diffusion over latent diffusion here?

키 프레임 생성에서 우리의 목표는 64x40과 같은 작은 공간을 갖는 것이다. 여기서 잠재 확산을 선택하면 해상도가 너무 낮아져 공간적 의미를 유지할 수 없다.

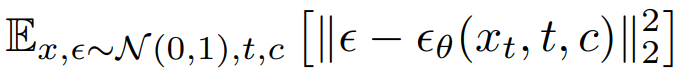

키 프레임 모듈의 훈련 목표는 기본적인 확산 모델과 같음.

Temporal interpolation model

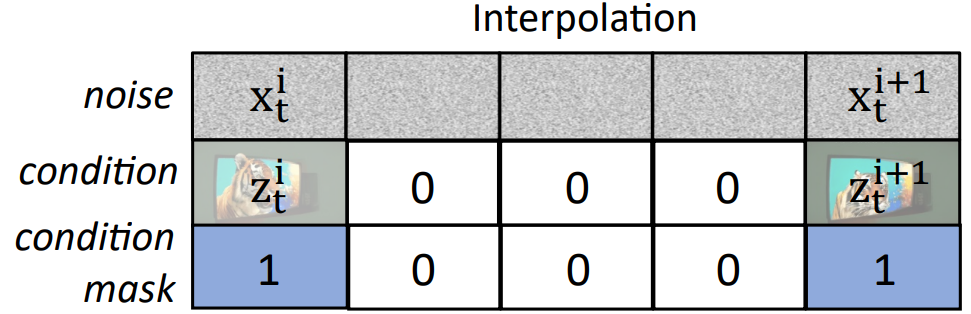

원본 픽셀 채널 외에 4개의 보충 채널 추가.

3개의 채널은 입력 비디오의 RGB 마스크된 채널.

나머지 1개의 채널은 키 프레임인지 아닌지를 알려주는 채널이다.

(입력된 키 프레임은 보간 모듈의 조건으로써 쓰이고, 보간 모듈에서는 noise x부터 다시 denoising을 시작)

또한 z에는 cascade 구조의 순차적 모델을 훈련하는 데 유용한 noise conditioning augmentation을 적용.

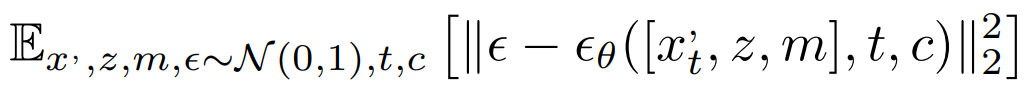

훈련 목표:

Super-resolution at low spatial resolution

보간 모듈이 완성한 비디오의 RGB를 받기 위한 3개의 추가 채널, noise conditioning augmentation 또한 적용.

모든 프레임을 동시에 업스케일 하는 것은 계산 비용이 막대함.

따라서 4개의 segment로 나눈 뒤 개별적으로 업스케일 하는데,

세그먼트 간의 연속성을 유지하기 위해 전 세그먼트의 마지막 프레임을 사용해 다음 세그먼트의 3개 프레임을 완성.

Super-resolution at high spatial resolution

eDiff-I에 따르면, U-Net을 denoising step의 특정 단계에 특화시킬 수 있다.

따라서 마지막 모델은 세부 사항 생성에만 특화된 모델로 만든다. (900~0 denoising step에 대해서 훈련)

일단 입력 비디오를 업스케일 한 뒤, 잠재 공간으로 인코딩하고 SDEdit에 따라 목표한 일정 단계만큼의 노이즈만 추가하고 다시 denoising 하는 것을 훈련하여 특화 모델로 만듦.

Experiments