LDM을 시간 차원으로 확장하여 비디오 생성

[Github]

[arXiv](Current version v2)

Abstract

저차원 3D 잠재공간을 활용한 Latent Video Diffusion Models(LVDM) 제안

Introduction

LDM의 저차원 잠재공간을 활용해 효율적으로 비디오를 생성할 수 있는 LVDM.

+훈련 길이보다 더 긴 비디오를 생성할 수 있는 계층적 LVDM 프레임워크,

긴 비디오에 대한 성능 저하를 완화하기 위해 조건부 잠재 섭동과 무조건 지침 사용.

Method

Video Autoencoder

경량 3D 오토인코더로 비디오 압축.

비디오 샘플 x0 ∈ RH × W × L × 3가 주어지면 인코더 E는 spatial and temporal downsampling factor fs, ft에 대해 z0 ∈ Rh × w × l × c로 인코딩한다. D는 반대.

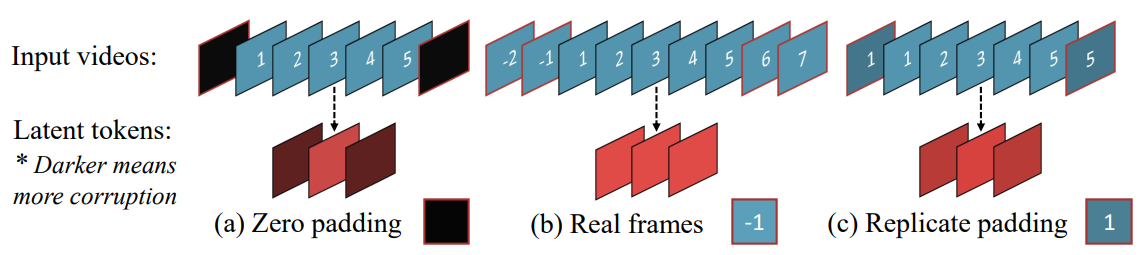

Temporally shift-equivariant를 보장하기 위해 모든 3차원 컨볼루션에서 replicate padding 사용.

StyleGAN3 논문 리뷰 개념편을 보면 equivariant의 개념을 알 수 있다.

또한, equivariant를 해치지 않으려면 모델이 '여긴 가장자리구나' 하는 위치 편향을 배우면 안 된다.

따라서 zero padding은 쓸 수 없고, 이전과 이후 프레임을 가져와서 쓰면 비용 오버헤드가 발생한다.

이때 양 끝의 프레임을 복사해서 쓰면 추가 비용도 발생하지 않음과 동시에 위치 편향도 제거할 수 있다.

(인접한 프레임 간의 feature는 대부분 비슷하기 때문에)

재구성 손실 + 적대적 손실로 훈련됨. (ψ = 판별자)

Base LVDM for Short Video Generatio

Revisiting Diffusion Model

순방향

역방향

신경망의 피라미터화

훈련 목표

Video Generation Backbon

Video Diffusion Models를 따라 1x3x3 컨볼루션과 temporal attention 도입.

Adaptive group normalization을 사용하여 채널별 scale 및 bias를 제어하기 위해 정규화 모듈에 timestep 임베딩 주입.

Hierarchical LVDM for Long Video Generation

긴 비디오를 생성하기 위해 자기회귀 방식으로 잠재 코드를 생성할 수 있는 조건부 모델 제안.

Autoregressive Latent Prediction

각 프레임의 채널 차원에 마스크 채널을 추가하고 마스크에 따라 zti를 z0i로 교체함으로써, 나머지 프레임을 조건으로 새로운 프레임을 생성할 수 있는 조건부 모델과 무조건 모델을 공동으로 훈련할 수 있다. (모두 0이면 무조건 모델)

Hierarchical Latent Generation

자기회귀 방식으로 순서대로 긴 비디오를 생성하면 시간이 지남에 따라 오류가 누적되어 품질이 저하될 수 있다. 따라서 계층 생성 전략 사용.

먼저 자기회귀 생성 모델이 잠재 희소 프레임 세트를 생성한 다음, 프레임 간 마스크가 모두 0인 희소 프레임에서 훈련된 또 다른 자기회귀 생성 모델을 사용하여 누락된 프레임을 채운다.

Conditional Latent Perturbation

조건부 오류를 완화하기 위해 Cascaded Diffusion Models의 truncated conditioning에서 영감을 받은 조건부 잠재 섭동을 사용한다.

z0에 확산 프로세스를 수행하여 소량의 노이즈가 추가된 zs를 조건으로 사용하고 샘플링 시에는 자기회귀 예측 동안 노이즈를 지속적으로 추가한다. (노이즈가 있는 조건에서 훈련했으므로)

Unconditional Guidance

자기회귀 예측의 오류 누적으로 조건부 점수가 모델 학습 분포를 벗어날 수 있다.

공동 훈련을 통해 하나의 모델로 무조건 및 조건부 점수를 추정할 수 있으므로 classifier-free guidance를 통해 샘플링 프로세스를 안내하여 품질 저하를 완화한다.