대규모 모델의 경우 블록으로 나누어 블록째로 가지치기

[arXiv](Current version v3)

[BERT]

Abstract

대규모 모델인 BERT를 희소화할 수 있는 Optimal BERT Surgeon(oBERT) 제안

The Optimal BERT Surgeon (oBERT)

Generalized Second-Order Block Pruning

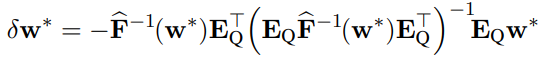

WoodFisher와 다른 점은 그룹으로 진행된다는 점이다.

WoodFisher의 eq는 단일 기저벡터였다면, 본 논문의 ek는 블록 내 인덱스에 해당하는 기저벡터의 집합이다.

(편의성을 위해 s.t. ~ 수식의 표기 변경)

그 뒤론 똑같음.

An Efficient Implementation

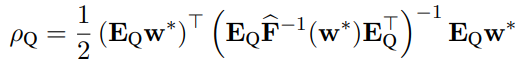

Pruning the optimal set of weights

가지치기될 각 블록들의 조합까지 계산하는 것은 불가능하므로 블록 간의 상관관계를 무시하고 pQ가 낮은 블록들을 제거한다.

Memory and run-time complexity

경험적 fisher matrix를 구하는 데는 WoodFisher에서 언급한 블록별 대각성분 근사를 활용한다.

'논문 리뷰 > etc.' 카테고리의 다른 글

| GPTQ: Accurate Post-Training Quantization for Generative Pre-trained Transformers (0) | 2023.11.02 |

|---|---|

| Loss Aware Post-training Quantization (LAPQ) (2) | 2023.11.01 |

| Optimal Brain Compression: A Framework for Accurate Post-Training Quantization and Pruning (OBC) (1) | 2023.10.30 |

| WoodFisher: Efficient Second-Order Approximation for Neural Network Compression (1) | 2023.10.27 |

| Accelerated Sparse Neural Training (0) | 2023.10.26 |

| Online normalizer calculation for softmax (1) | 2023.10.23 |