Image-paired data로 모든 양식 통합하기

Abstract

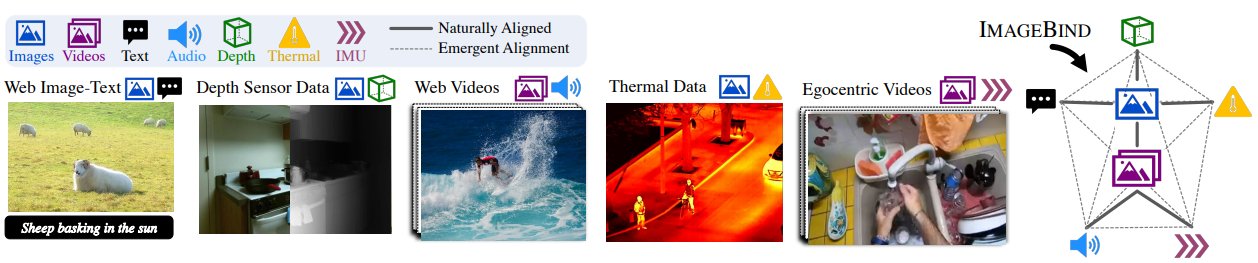

6가지 다른 양식에 걸쳐 joint 임베딩을 학습하는 접근 방식인 ImageBind 제안.

훈련에 모든 pair data가 필요하지 않으며 image-paired data만 있으면 충분하다.

Introduction

해변의 이미지는 파도 소리, 모래의 질감, 바람을 떠올리게 하거나 시에 영감을 줄 수도 있다.

이미지의 이 binding 속성은 이미지와 관련된 모든 감각 경험과 정렬하여 시각적 기능을 학습할 수 있는 많은 소스를 제공한다.

본 논문에서는 여러 유형의 image-paired 데이터를 활용하여 단일 공유 표현 공간을 학습하는 ImageBind를 제시한다.

이미지의 binding 속성을 활용하여 각 양식의 임베딩을 이미지 임베딩에 정렬하는 것만으로도 모든 양식에 걸쳐 정렬이 이루어짐을 보여준다.

Method

Preliminaries

대조 학습(Contrastive learning)을 이용하여 두 가지 양식을 정렬할 수 있지만 세 가지 이상은 불가능.

CLIP은 텍스트와 다른 양식 간의 제로샷 분류를 가능하게 한다. ImageBind는 텍스트가 없는 양식에 대해서도 제로샷 분류 가능.

Binding modalities with images

대규모 웹 데이터 세트로 양식 쌍 (Image, Modality) 정렬.

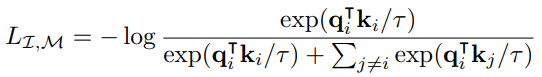

I, M을 정규화된 임베딩으로 인코딩하고

임베딩과 인코더를 InfoNCE loss를 통해 최적화

(positive pair의 임베딩은 가깝게, negative pair의 임베딩은 멀게 인코딩 됨.)

연구진은 (I, M1), (I, M2) 쌍만 사용하여 훈련하더라도 임베딩 공간에서 (M1, M2) 쌍이 정렬되는 emergent behavior을 관찰하였다.

이를 통해 ImageBind는 다양한 양식에서 zero-shot 및 cross-modal 검색 작업을 수행할 수 있다.

CLIP 등 ViT 기반 아키텍처 사용.

Experiment

파란색 부분이 직접 쌍을 교육하지 않고 emergence로 발생된 정렬의 성능.

애초에 아키텍처도 바닐라 ViT에 가깝고 성능보다는 emergence 현상에 중점을 둔 논문이다.

'논문 리뷰 > etc.' 카테고리의 다른 글

| Simple and Controllable Music Generation (MusicGen) (0) | 2023.06.15 |

|---|---|

| High Fidelity Neural Audio Compression (EnCodec) (0) | 2023.06.13 |

| SoundStream: An End-to-End Neural Audio Codec (0) | 2023.06.13 |

| A Method for Animating Children's Drawings of the Human Figure (1) | 2023.04.19 |

| Reviving Iterative Training with Mask Guidance for Interactive Segmentation (0) | 2023.04.09 |

| Iteratively Trained Interactive Segmentation (1) | 2023.04.09 |