Abstract

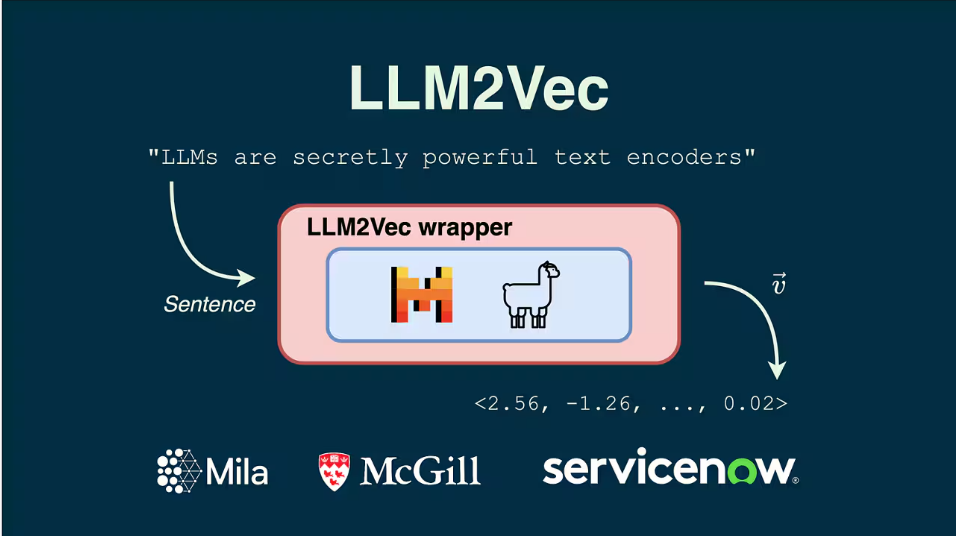

LLM을 text encoder로 변환하는 효율적이고 간단한 비지도 접근 방식인 LLM2Vec 제안

[Blog]

[Github]

[arXiv](2024/04/09 version v1)

LLM2Vec

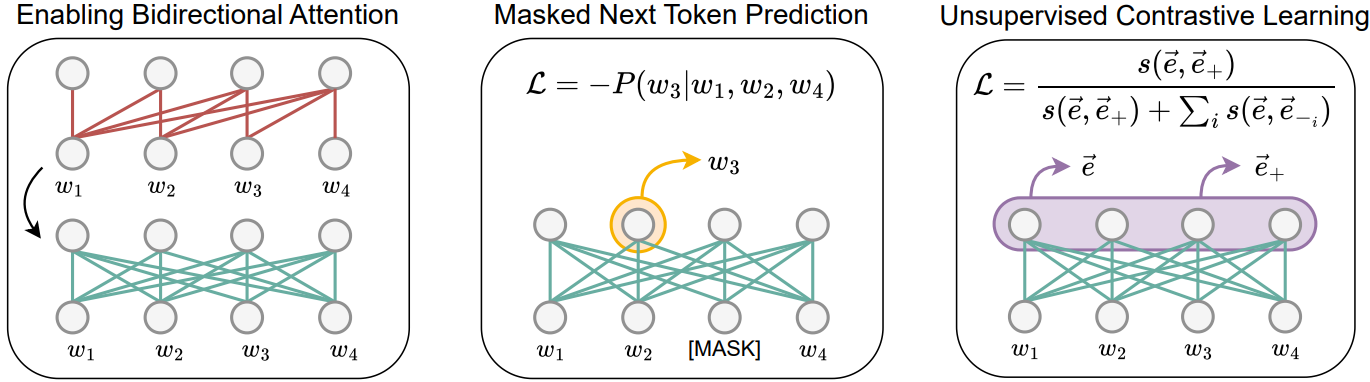

Three simple ingredients

먼저 bidirectional attention을 활성화하고 masked next token prediction 목표에 대해 모델을 훈련한다.

이 단계에서 decoder-only LLM을 word-level encoder로 변환할 수 있다.

추가적으로 입력 시퀀스가 주어지면 독립적으로 샘플링된 dropout mask를 사용하여 동일한 시퀀스에 대한 2가지 다른 표현을 생성하고 두 표현 간의 유사도를 최대화, 배치 내의 다른 시퀀스와의 유사도는 최소화하도록 대조 학습을 수행한다.

Transforming decoder-only LLMs with LLM2Vec

Masked next token prediction

훈련에는 LoRA를 사용하며 단일 80GB A100 GPU에서 90분만에 훈련할 수 있다.

Unsupervised contrastive learning

또 다른 LoRA를 추가하여 훈련. 약 2.5시간이 소요된다.

LLM2Vec-transformed models are strong unsupervised text embedders

결과

공개 데이터셋을 사용해 지도 대조 학습을 수행하면 더 좋은 성능을 낼 수 있다.

간단하고 효율적인 방법이지만 최신 텍스트 임베딩 모델인 Gecko (FRet)과 근접하는 성능.