Abstract

Next-token 예측을 next-scale 예측으로 재정의하는 차세대 패러다임인 Visual AutoRegressive (VAR) modeling 제안

[Github]

[arXiv](2024/04/03 version v1)

Method

AR modeling을 vision에 적용했을 때 문제점:

- Image encoder는 양방향 상관관계를 가지며 AR의 단방향 가정과 모순된다.

- 토큰의 평탄화는 이미지에 내재된 공간성을 방해한다.

Visual autoregressive modeling via next-scale prediction

Reformulation

다음과 같이 AR modeling을 변경한다. 예측하는 것은 하나의 토큰이 아니라 다음 해상도의 모든 토큰이다.

rK는 원본 feature map의 해상도와 같다.

Tokenization

VQGAN과 유사한 새로운 multi-scale quantization autoencoder를 개발.

Algorithm 1: 각 단계에서 feature map을 n × n 개의 토큰으로 보간하고 양자화하여 R에 저장, 코드북 벡터와 치환하고 원본 feature map에서 뺀다.

Algorithm 2: 반대로 각 단계의 feature들을 모두 더해서 최종 feature map을 구성한다. 즉, 모든 rk가 필요하다.

추가 conv layer ϕ를 활용한 residual style design이 경험적으로 더 나은 성능을 보였기 때문에 채택했다.

모든 scale에서 같은 코드북 Z를 공유한다.

rk의 모든 토큰은 병렬로 생성된다. 논문에는 생성 과정이 자세하게 나와있지 않다. 궁금하면 여기를 보도록.

Implementation details

VAR tokenizer

Vanilla VQVAE에 multi-scale quantization 방식만 추가되었다.

VAR transformer

GPT-2와 같은 decoder-only transformer, VQGAN 아키텍처 채택.

핵심은 VAR algorithm에 있으므로 LLM의 최신 기술(e.g. SwiGLU, RoPE, RMSNorm)은 사용하지 않았다.

Empirical Results

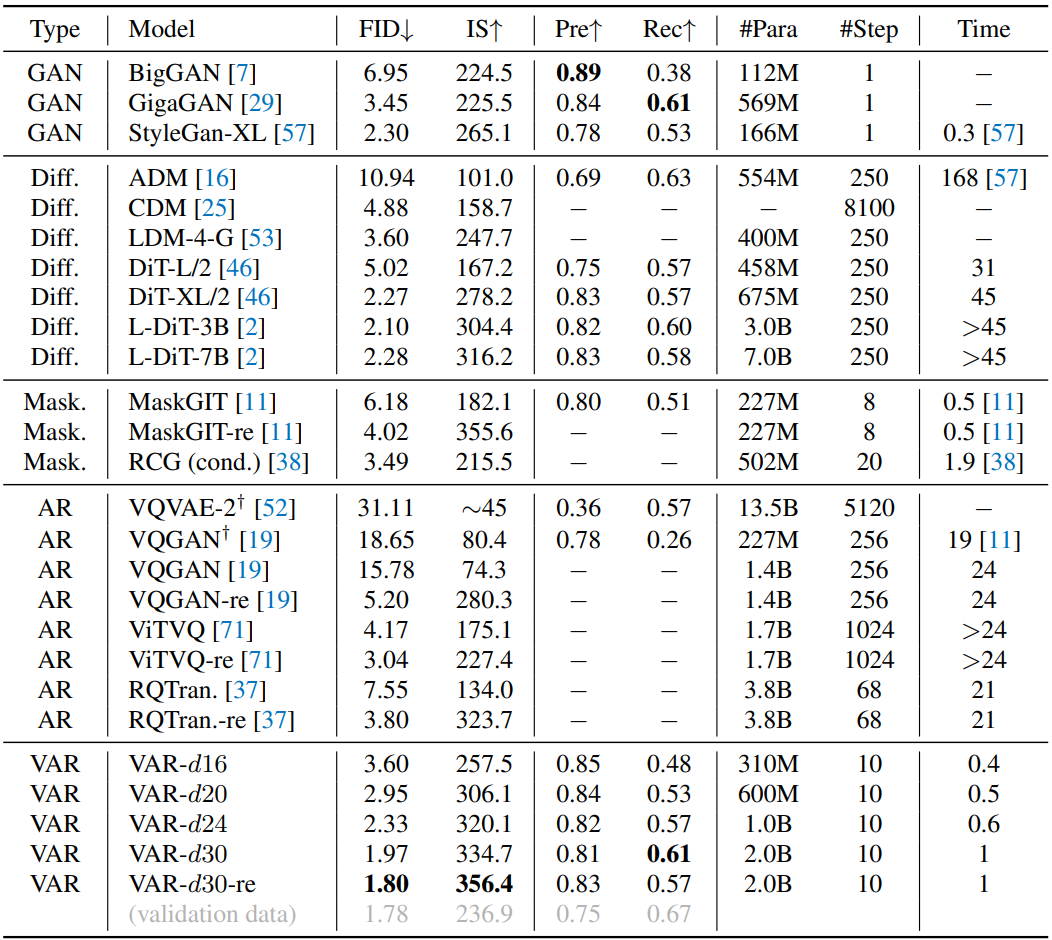

ImageNet 256x256

ImageNet 512x512

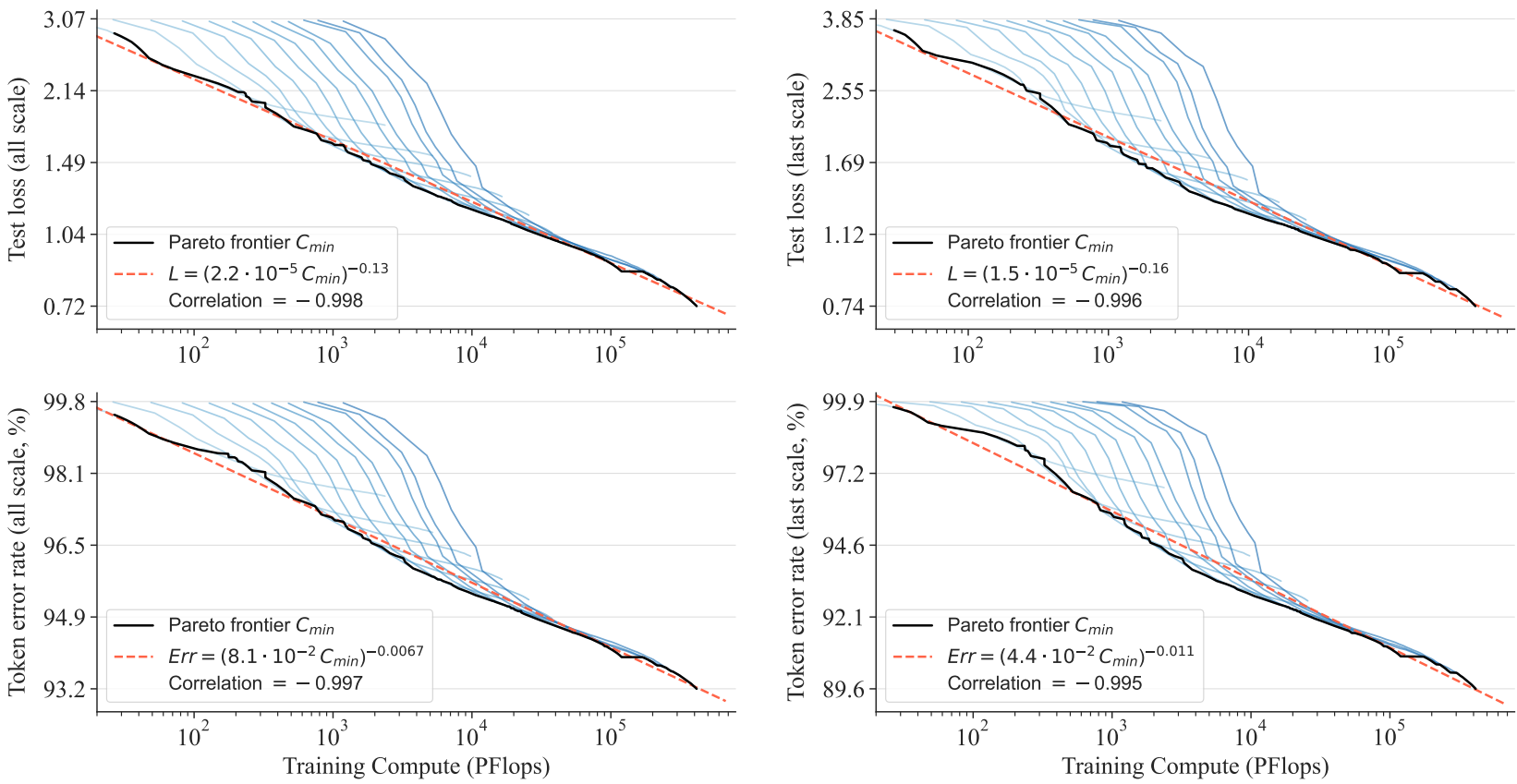

Scaling law 적용댐.

정성적 평가는 Project Page로

Template

var.vision