[Github]

[arXiv](2024/02/01 version v1)

|

|

|

Abstract

Image prior, motion prior 추출을 분리하는 학습 전략과 plug-and-play adapter를 효율적으로 적응하는 전략 제안

Consistency Models

Consistency Models 논문 리뷰 : 매우 자세한, 간단 버전

일반적으로 잔차 연결을 통해 consistency model을 피라미터화 한다.

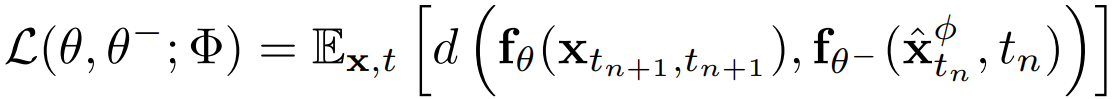

xtn+1을 샘플링하고 ODE solver를 통해 xtnΦ를 계산하여 인접한 한 쌍의 데이터 포인트(xtnΦ, xtn+1)를 생성할 수 있고

데이터 포인트 쌍에 대한 일관성 모델의 출력의 차를 최소화하여 consistency distillation loss를 유도할 수 있다.

θ̄는 θ의 EMA 모델

Methodology

From DMs to CMs

Latent Consistency Models에 따라 Diffusion Model을 CM에 적용하는 방법

From ϵ-prediction to x0-prediction

노이즈 예측 모델 ϵθ를 통해 피라미터화.

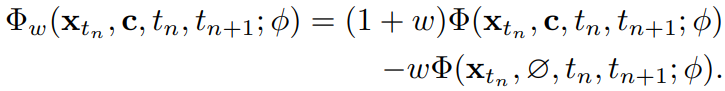

Classifier-free guidance augmented ODE solver

CFG 도입.

Sample sparse timesteps from dense timesteps

1000 step에서 50개의 step을 균일하게 샘플링한 sparse timestep에서 훈련.

Decoupled Consistency Learning

공개적으로 사용 가능한 고품질 비디오 데이터가 별로 없기 때문에 이미지 생성과 모션을 분리한다.

먼저 고품질 image-text dataset에서 LoRA를 사용하여 DM을 CM으로 증류한 뒤 LoRA 가중치를 동결하고 비디오 훈련이 가능하도록 조정. (3D conv, temporal layer)

Initialization strategy

Spatial LoRA는 시간 모델링을 고려하지 않고 샘플링을 가속화하도록 훈련되었기 때문에 모션 훈련 초기에 표현을 손상시키는 경향이 있다. 이에 대해 경험적으로 발견한 효과적인 훈련 전략을 소개한다.

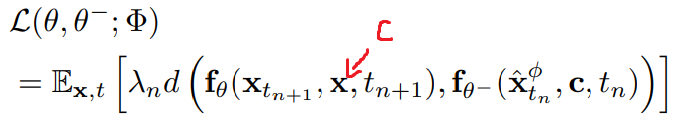

위 그림과 같이 target CM에는 spatial LoRA 가중치를 반영하지 않고 EMA를 통해 훈련 도중에 스며들게 하면 학습 효율이 크게 향상된다. 논문에 잘못 표기되어 있는데 x가 아니라 c임

더 작은 timestep의 예측이 더 큰 timestep에 대한 목표로 작동한다는 점을 고려하여 작은 timestep의 학습에 더 큰 가중치를 준다.

거리 측정 함수 d()는 huber loss로, L2 loss 보다 outlier에 더 견고하다.

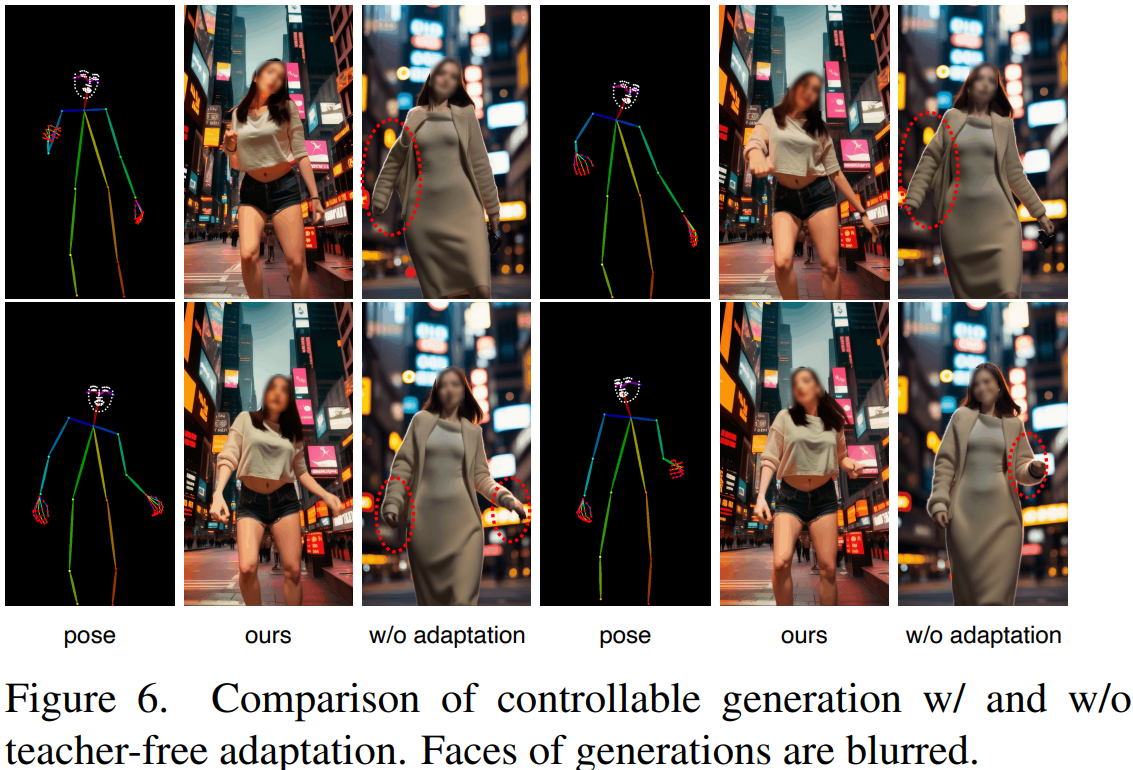

Teacher-Free Adaptation

이미지 DM으로 훈련된 많은 plug-and-play adapter는 다음과 같이 세부적인 제어력을 상실한다. 더 나은 호환성을 위해 기존 adapter를 수용하거나 처음부터 훈련하는 효과적인 전략을 소개한다.

다음과 같이 동일한 노이즈를 이용한 2개의 순방향 SDE를 통해 teacher video DM model 없이도 adapter를 적응시킬 수 있다.

Image-to-video

비디오에 이미지를 통합하기 위한 일반적인 방법은 cross-attention 또는 첫 번째 프레임을 주어진 이미지로 하고 마스크를 1, 나머지 프레임의 마스크를 0으로 하는 mask modeling이다. 본문에서는 그보다 더 효과적인 방법을 소개한다.

먼저 이미지를 잠재 공간으로 인코딩한 다음 프레임만큼 반복, 이후 light block에 공급하여 다양한 해상도의 feature를 추출하고 U-Net에 직접 추가한다.

Controllable video generation

이미지 도메인에서 훈련된 ControlNet 등의 adapter를 teacher-free adaptation을 통해 효율적으로 조정할 수 있다.

Experiments

AnimateLCM

AnimateLCM: Accelerating the Animation of Personalized Diffusion Models and Adapters with Decoupled Consistency Learning Click to Play the Animations Generated with AnimateLCM in 4 steps! Abstract Video diffusion models has been gaining increasing attentio

animatelcm.github.io