생성 모델을 자연어로 제어할 수 있도록 multi-modal instruction tuning.

[arXiv](2024/01/03 version v1)

Abstract

자연어를 사용하여 서로 다른 양식을 통합함으로써 다양한 생성 의도를 통일된 형식으로 표준화할 수 있는 Instruct-Imagen 제안

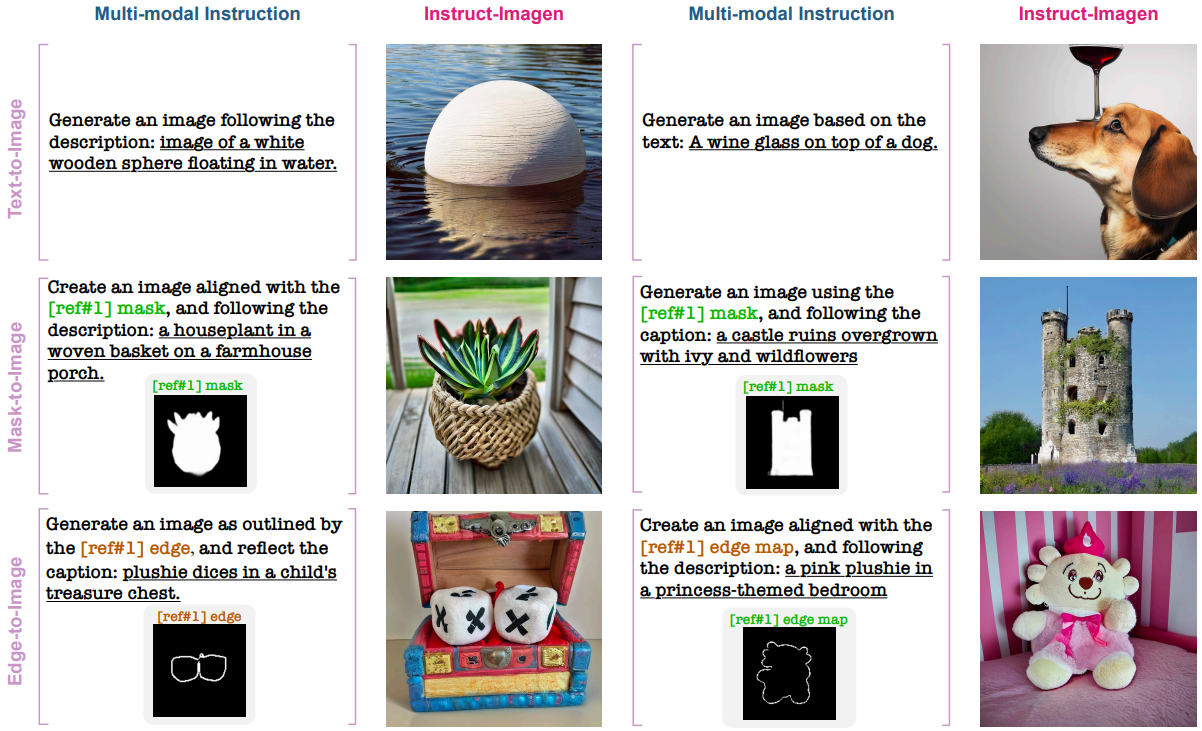

Multi-modal Instructions for Generation

Multi-modal instruction은 2가지 핵심 구성요소로 이루어져 있다.

- 마커([ref#1])와 함께 작업에 대한 설명을 제공하는 text instruction

- 마커와 pairing 된 multi-modal context

Instruct-Imagen

- Imagen with Multi-modal Instruction

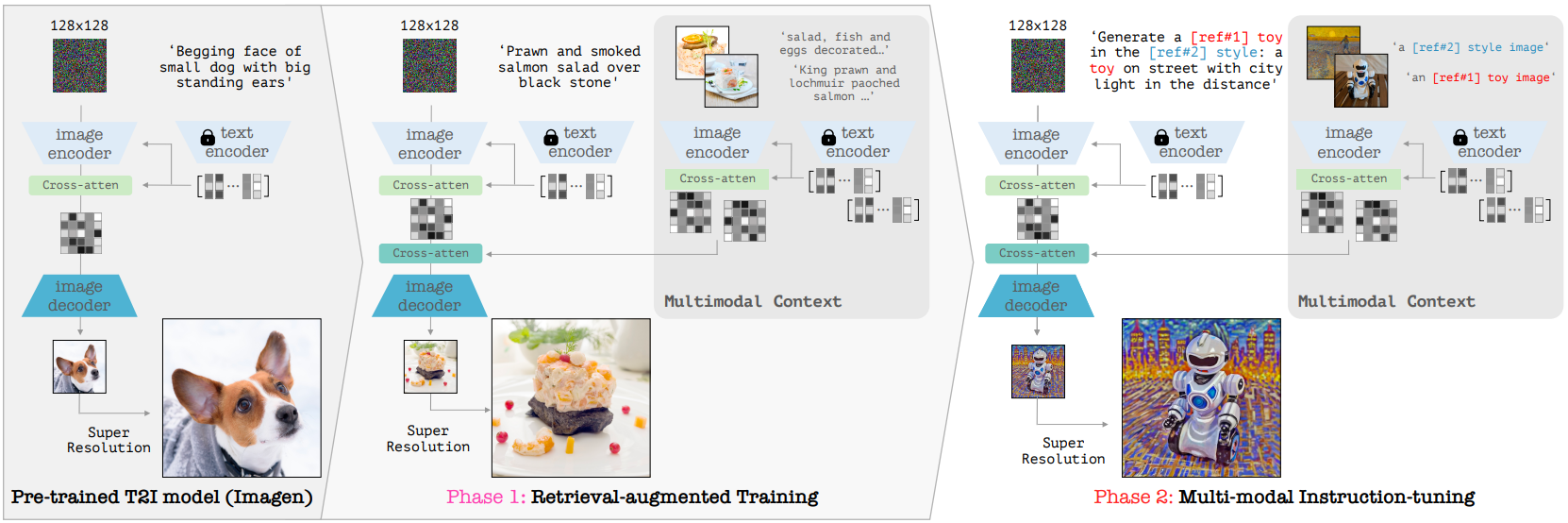

- Training Instruct-Imagen in Two Stages

Imagen with Multi-modal Instruction

Cascaded Backbone Text-to-Image Model

Imagen에서 몇 가지 수정사항:

- Super-resolution model은 하나만 사용함 (128x128 → 1024x1024)

- 해상도 당 하나의 Up/Down block과 여러 개의 ResNetBlock을 사용했던 기존 설정 대신 같은 해상도에서 여러 개의 Up/Down block을 사용하고 블록 당 ResNetBlock을 하나만 사용한다. (더 많은 attention을 수행하기 위함)

Encoding Multi-modal Instruction

다음과 같이 Imagen의 인코더 부분을 복제하여 multi-modal instruction encoder로 사용하고 bottleneck 이후 cross-attention layer를 추가하여 Imagen에 통합한다.

Training Instruct-Imagen in Two Stages

훈련은 2-stage로 이루어짐.

Retrieval-augmented Text-to-image Training

인터넷의 multi-modal data(e.g. wikipedia with images)는 context를 무시하게 되는 경우가 많다.

예를 들어, 미국의 대통령에 대한 문서에 존재하는 바이든의 이미지는 루즈벨트 이미지를 생성하는데 도움 되지 않는다.

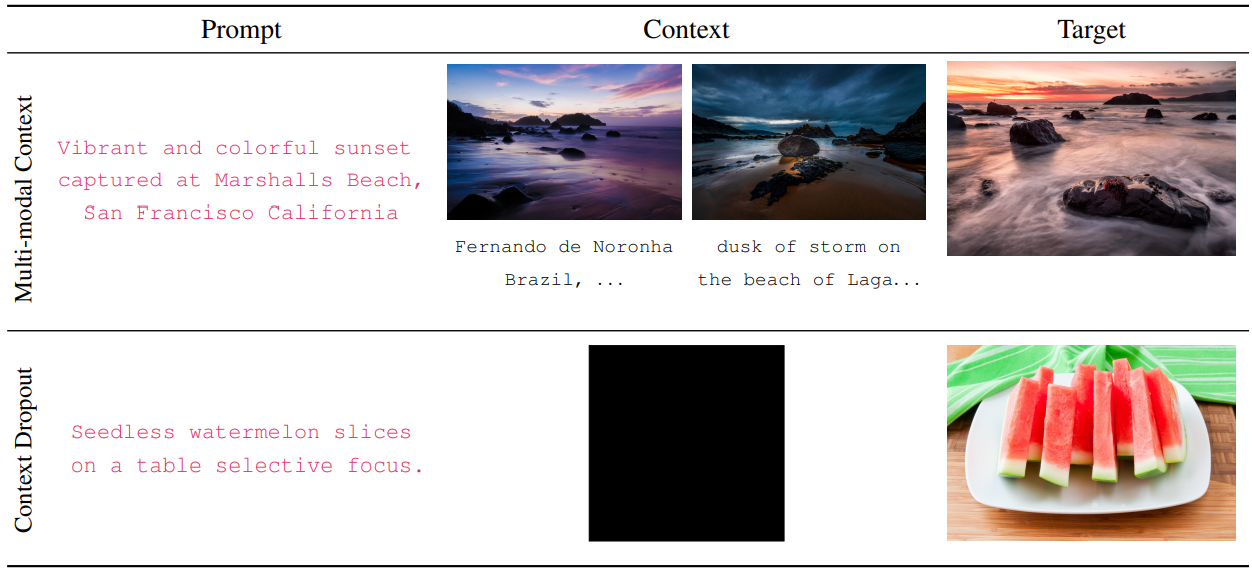

Web scale image-text corpus WebLI에서 저품질 이미지 필터링 후 image-text 매칭을 통해 특정 클러스터의 이미지를 분류하고 CLIP 임베딩을 사용하여 각 클러스터에서 이미지 클러스터링을 수행. 각 이미지 클러스터에 대해 가장 가까운 이웃 10개를 추출하고 유사도가 높은 이미지와 동일한 URL을 가진 이미지를 제거. 이미지가 5개가 되도록 잘라내어 클러스터 당 5개의 image-text pair가 있는 8.08M 클러스터를 생성했다.

훈련 중 1 pair는 Instruct-Imagen의 prompt 및 target으로, 3 pair는 context로 제공된다.

Prompt와 context 또는 context만 dropout 될 확률이 각각 10%.

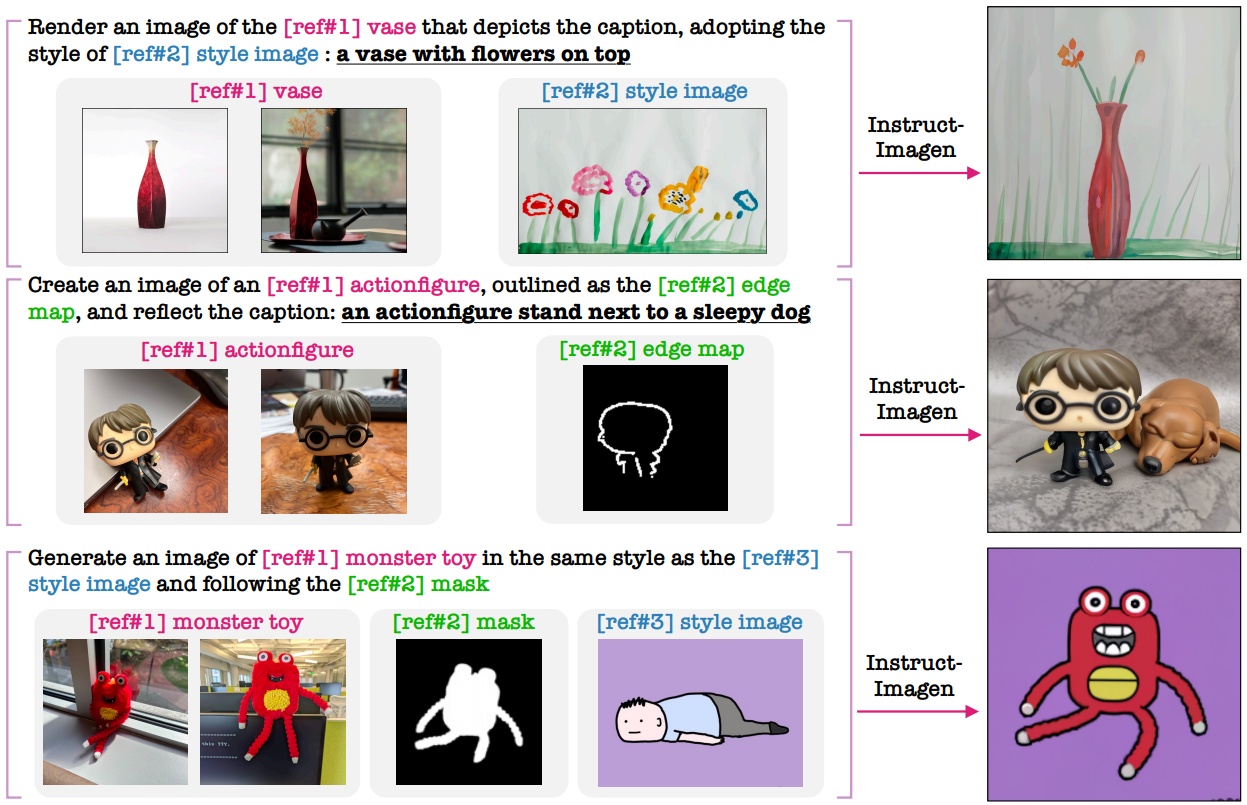

Multi-modal instruction-tuning for Image Generation

Instruction tuning을 위한 11개의 추가 데이터셋(e.g. depth map, edge map)과 5개의 작업 범주를 구성하고 GPT-4를 통해 데이터셋 당 100개의 다양한 명령어 템플릿을 구성하도록 했다.

혼합 작업 데이터셋에서 맨 오른쪽의 혼합 ratio를 사용하여 공동훈련 하였다.

Experiments