Abstract

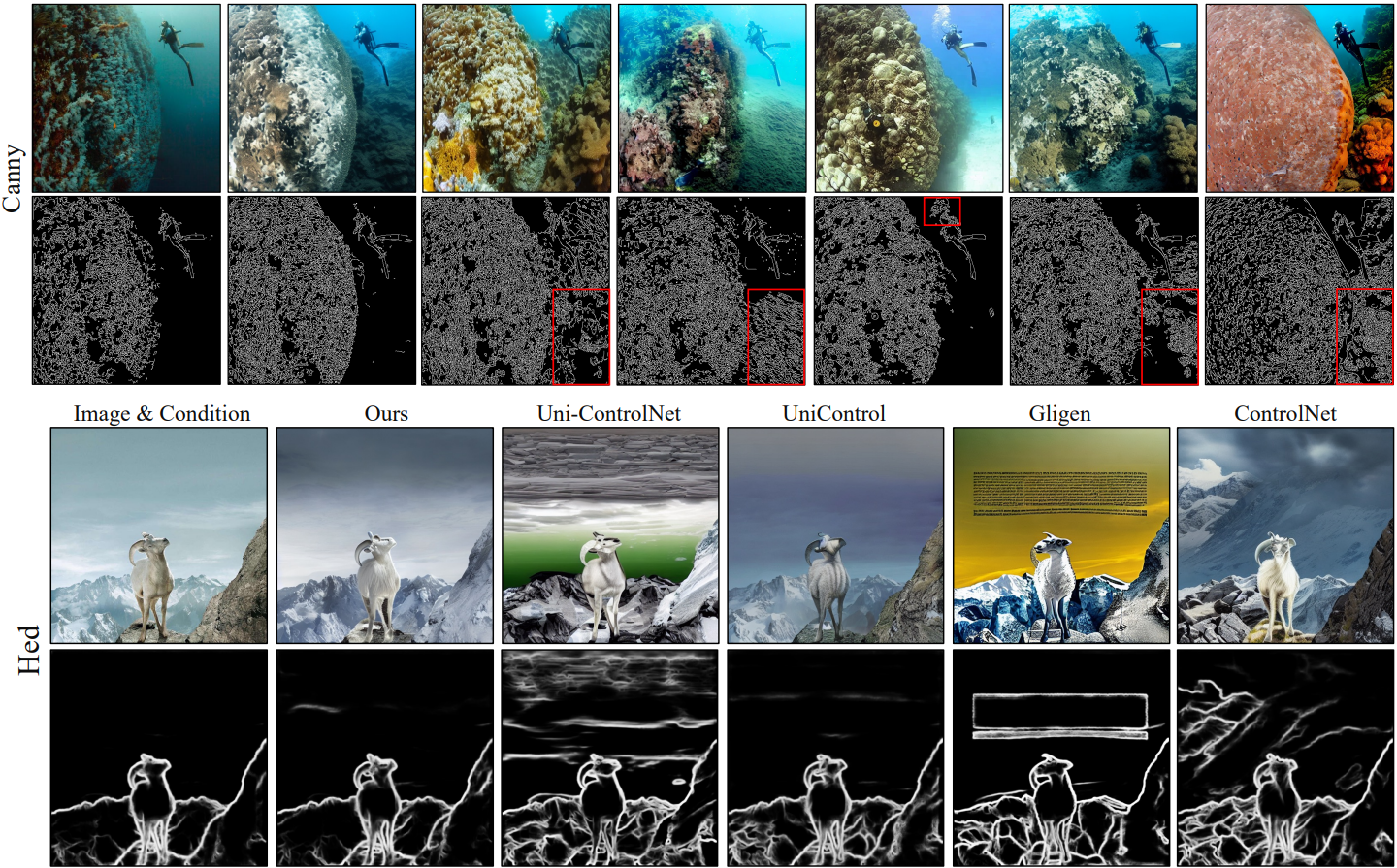

Cycle consistency를 명시적으로 최적화하여 이미지 제어를 향상시키는 ControlNet++ 제안

[Github]

[arXiv](2024/04/11 version v1)

Introduction

CycleGAN에서 영감을 받아 조건으로 이미지를 생성한 후 다시 조건으로 회귀할 수 있는 cycle consistency를 이용할 것을 제안.

Method

Reward Controllability with Consistency Feedback

Reward consistency loss 정의:

L = 픽셀 공간 손실 측정 함수, G = stable diffusion, D = 탐지 등의 조건 변환 모델

이미지 생성 기능이 손상 되지 않도록 기존의 diffusion training loss도 사용한다.

Efficient Reward Fine-tuning

SD로 이미지를 렌더링하려면 여러 단계가 필요하므로 비효율적이다.

아래 그림과 같이 one-step 보상 전략을 제안한다.

원본 이미지에 소량의 노이즈를 추가하고 one-step sampling을 통해 이미지를 예측 후

보상을 계산한다.

Total loss function:

ControlNet만 업데이트한다.

큰 노이즈에서 조건을 강제하면 심한 왜곡이 발생하므로 작은 t에서만 적용하는 것이 핵심이다.

Experiments