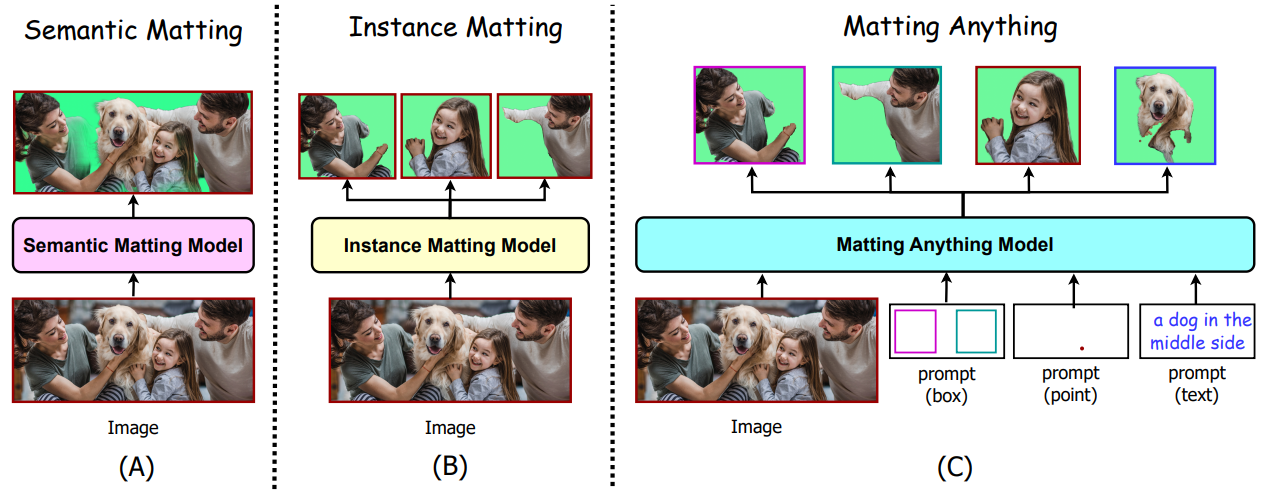

SAM을 활용한 image matting 모델. 다양한 matting 작업 처리 가능.

Abstract

Matting Anything Model(MAM)

- 단일 모델로 다양한 유형의 image matting 처리 가능

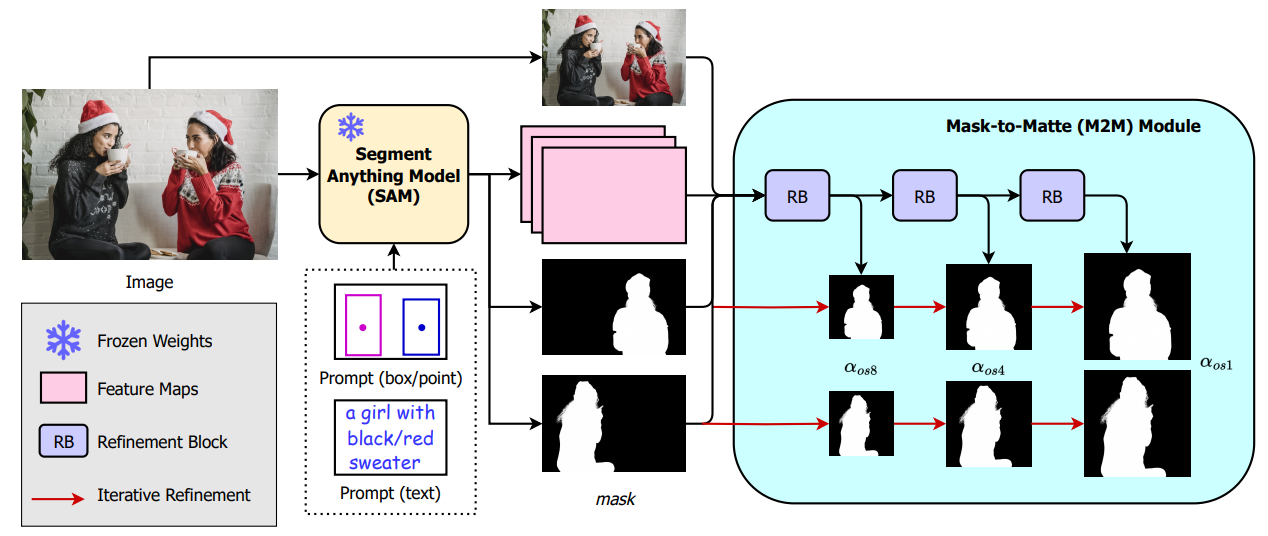

- SAM(Segment Anything Model)의 feature map에 경량 M2M(Mask-to-Matte) 모듈을 채택하여 alpha matte 예측

- SAM을 통해 대화식으로 사용 가능

Introduction

MAM은 SAM feature map과 마스크 출력을 입력으로 사용하고 대상 인스턴스의 alpha matte를 예측하기 위해 가벼운 M2M(Mask-to-Matte) 모듈을 추가했다.

서로 다른 클래스의 인스턴스를 다루는 5가지 이미지 매팅 데이터 세트의 조합에 대해 학습하여 다양한 매팅 작업 처리 가능.

M2M 모듈은 multi-scale alpha matte를 예측하여 마스크를 다듬고, 반복적인 정제 프로세스를 통해 multi-scale 예측을 병합하여 최종 alpha matte를 얻는다.

Matting Anything

Mask-to-Matte

Multi-Scale Prediction

입력 이미지 I가 주어지면 feature map F, 마스크 예측 m을 생성한다.

재조정된 이미지, F, m을 연결하고 M2M 모듈의 입력 Fm2m을 구성한 후

1/8 해상도인 αos8에서 self-attention, batchnorm, activation이 포함된 refinement blocks 사용.

세세한 객체를 추출하고 다양한 scale의 객체를 처리하기 위해 1/4, 전체 해상도에서도 수행.

Iterative Refinement

훈련하는 동안 이미지의 다른 영역을 강조 표시하는 가중치 맵 wos8, wos4, wos1을 계산.

각 가중치는 loss 계산 과정에서 순서대로 전체 이미지 강조, background filtering, transition area 강조에 쓰인다.

최종적으로 alpha matte prediction α ∈ R1×H×W 얻음.

Matting Anything Model

Foreground instance, background를 포함하는 다양한 데이터셋을 통해 foreground, alpha matte, background의 조합으로 합성 이미지를 생성하고, 해당 이미지 내의 객체들에 대한 경계상자를 추출.

합성 이미지와 경계 상자를 MAM에 넣은 뒤 L1 loss, Laplacian loss 계산

Experiments