SAM에서 세부적인 마스크 품질 개선

Abstract

SAM(Segment Anything Model)의 마스크 품질을 개선한 HQ-SAM 제안

Introduction

SAM의 주요한 문제 중 하나는 얇은 선 같은 물체를 잘 감지하지 못하는 것

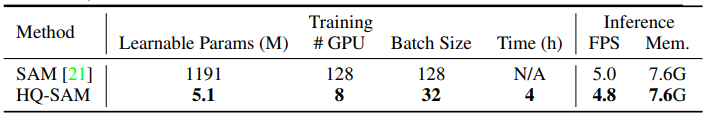

HQ-SAM은 SAM의 가중치를 건드리지 않고 0.5% 미만의 피라미터를 추가하여 고품질 segmentation에 적응

- SAM의 디코더에 입력되는 학습 가능한 HQ 출력 토큰 설계

- HQ 토큰은 디코더 feature만이 아닌 세부 정보를 얻기 위해 정제된 feature에서 작동

고품질 segmentation 훈련을 위한 HQSeg-44K 데이터셋 제작.

Method

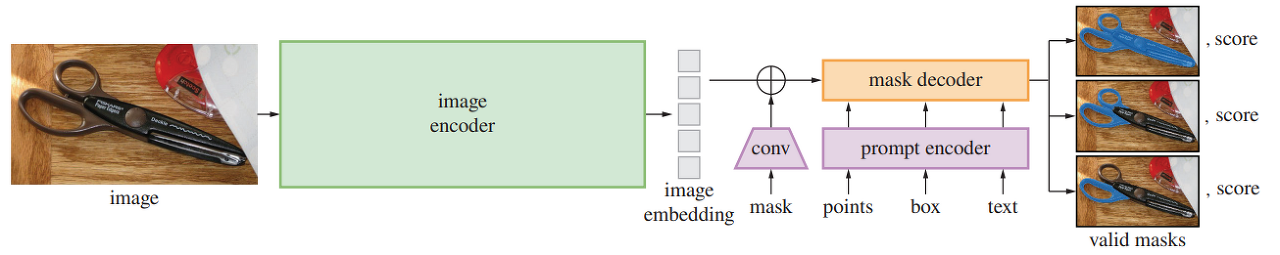

Preliminaries: SAM

Ours: HQ-SAM

High-Quality Output Token

Output token과 비슷한 역할을 하는 HQ token을 추가하고 HQ token을 위한 새로운 예측 레이어 도입.

HQ token은 다른 토큰들과 같이 두 개의 디코더 계층에서 각종 attention을 수행하고 새로운 3계층 MLP를 통과한 뒤 fused HQ-feature와 요소별로 곱하여 마스크를 생성한다.

Global-local Fusion for High-quality Features

인코더와 디코더에서 feature 정보를 가져옴으로써 고품질 feature 구성

- 인코더 초기 계층에서 가장자리, 경계 세부사항 얻음(64x64)

- 인코더 후기 계층에서 전역 이미지 context 정보 얻음(64x64)

- 디코더의 mask feature에서 자세한 마스크 모양 정보 얻음(256x256)

인코더에서 얻은 feature는 transposed convolution을 통해 256x256으로 업샘플링한 후 간단한 컨볼루션 처리를 하고 다른 feature와 요소별 방식으로 요약.

Training and Inference of HQ-SAM

세부적인 segmentation을 위해 제작한 HQSeg-44K 데이터셋으로 훈련.

학습 가능한 피라미터는 HQ token, 3계층 MLP, HQ-feature를 얻는 데 쓰이는 간단한 컨볼루션뿐이다.

추론에서는 SAM과 HQ-SAM의 출력을 256x256에서 합친 다음 원래 해상도로 업샘플링.

추론 시간 거의 늘어나지 않음.

Experiments

'논문 리뷰 > Vision Transformer' 카테고리의 다른 글

| Grounding DINO: Marrying DINO with Grounded Pre-Training for Open-Set Object Detection (0) | 2023.06.19 |

|---|---|

| Matting Anything (MAM) (0) | 2023.06.15 |

| Matte Anything: Interactive Natural Image Matting with Segment Anything Models (MatAny) (1) | 2023.06.15 |

| Personalize Segment Anything Model with One Shot (PerSAM) (4) | 2023.06.09 |

| Inpaint Anything: Segment Anything Meets Image Inpainting (0) | 2023.04.19 |

| Segment Anything (SAM) (0) | 2023.04.09 |